具体的には、Googleの親会社であるアルファベットは、従業員に対し、AIチャットボットに機密文書を入力しないよう勧告しました。ロイターが入手したアルファベット内部の情報筋によると、同社はエンジニアに対し、チャットボットが生成するコンピュータコードを直接使用しないよう警告したとのことです。

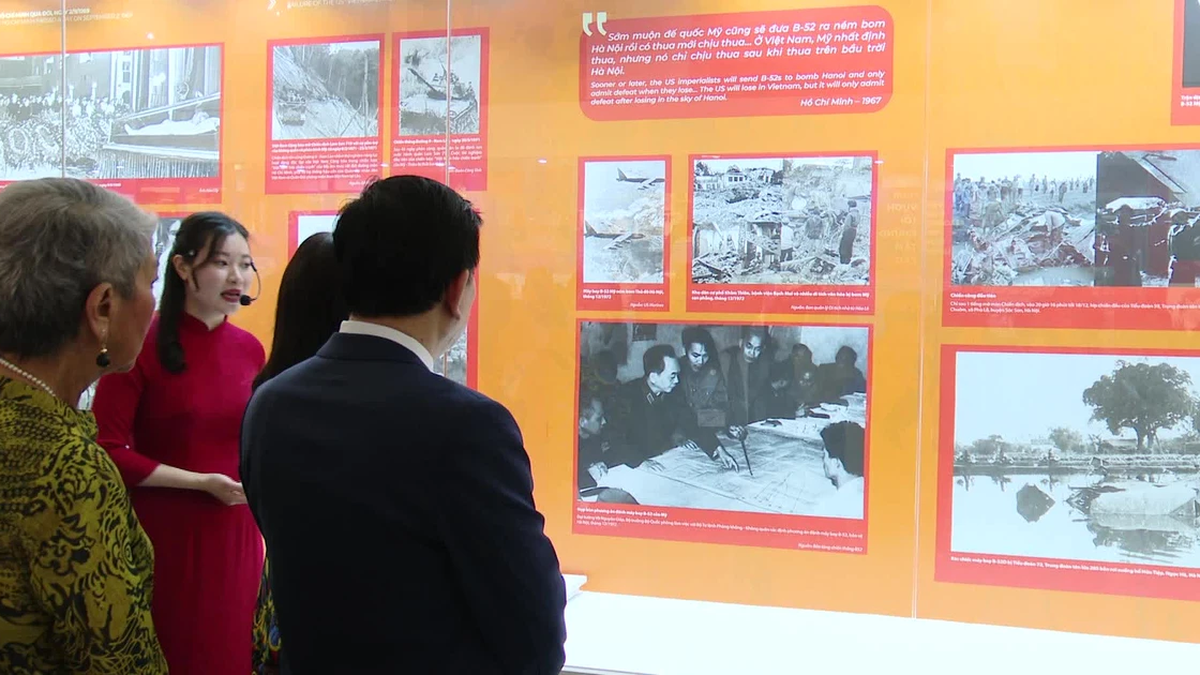

テクノロジー大手のグーグルも、自社のAIチャットボットを通じた情報漏洩を懸念している。写真:ロイター

BardやChatGPTなどのチャットボットは、いわゆる汎用人工知能(GPA)を用いてユーザーと人間のような会話を行うプログラムです。専門家によると、チャットボットは応答時に吸収したデータを複製する可能性があり、ユーザー情報の漏洩リスクが生じる可能性があります。

これらの懸念は、GoogleがChatGPTに対抗するためにリリースするソフトウェアによるビジネスへの悪影響を回避しようとしていることを示しています。Googleの慎重な姿勢は、企業がチャットボットに関する情報開示に警告を発するなど、 世界的な恐怖感の高まりを反映しています。

サムスン、アマゾン、ドイツ銀行など、世界中でますます多くの企業が AI チャットボットに安全対策を講じています。

米国のウェブサイト「フィッシュボウル」が約1万2000人を対象に実施した調査によると、1月時点で技術専門家の約43%がChatGPTなどのAIツールを使用しており、その多くは上司に報告せずに使用していた。

Insiderの報道によると、Googleは2月までにBardチャットボットの従業員に対し、社内情報を共有しないよう指示していた。Googleは現在、Bardを180カ国以上、40言語で展開している。

GoogleのAI技術は、メールや文書の自動作成、さらにはソフトウェアの作成まで行うツールに応用されています。しかし、これらのタスクには虚偽の情報が含まれる可能性があり、情報漏洩のリスクも伴います。

ブイ・フイ(ロイター、インサイダーによる)

[広告2]

ソース

コメント (0)