Jika anda pernah melayari media sosial, kemungkinan besar anda pernah terjumpa imej atau video yang dihasilkan oleh AI. Ramai orang telah tertipu, seperti video tular arnab melompat di atas trampolin. Tetapi Sora – aplikasi saudara kepada ChatGPT yang dibangunkan oleh OpenAI – sedang membawa video AI ke tahap yang baharu, menjadikan pengesanan kandungan palsu semakin mendesak.

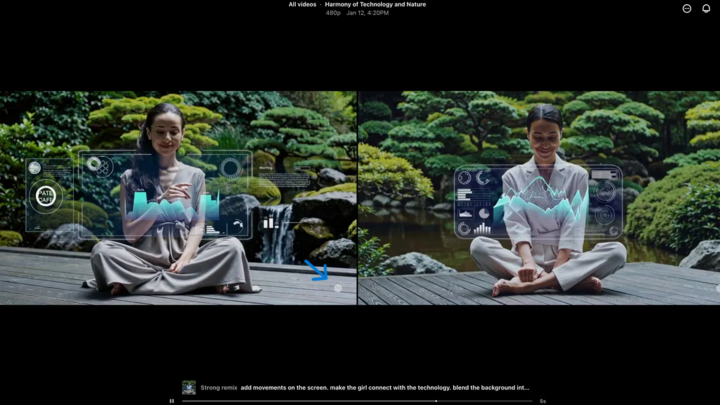

Alat video AI menjadikannya lebih sukar berbanding sebelum ini untuk mengenal pasti video tulen. (Sumber: CNET)

Dilancarkan pada tahun 2024 dan baru-baru ini dinaik taraf dengan Sora 2, aplikasi ini mempunyai antara muka yang serupa dengan TikTok, di mana semua video dijana AI. Ciri "kameo" membolehkan orang sebenar dimasukkan ke dalam rakaman simulasi, menghasilkan video yang sangat realistik.

Oleh itu, ramai pakar bimbang bahawa Sora akan menyebabkan deepfake tersebar, memutarbelitkan maklumat dan mengaburkan perbezaan antara realiti dan palsu. Selebriti amat terdedah, menyebabkan organisasi seperti SAG-AFTRA menggesa OpenAI untuk memperkukuh perlindungan.

Mengenal pasti kandungan yang dijana AI merupakan cabaran utama bagi syarikat teknologi, platform media sosial dan pengguna. Tetapi terdapat cara untuk mengenali video yang dihasilkan menggunakan Sora.

Cari tanda air Sora

Tanda Air Sora (ditunjukkan oleh anak panah biru) ialah penanda yang mengenal pasti alat yang digunakan untuk mencipta video. (Sumber: CNET)

Setiap video yang dihasilkan pada aplikasi Sora iOS mempunyai tanda air apabila dimuat turun – logo Sora putih (ikon awan) bergerak di sekitar tepi video, serupa dengan tanda air TikTok.

Ini adalah cara visual untuk mengenal pasti kandungan yang dijana AI. Contohnya, model "nano-pisang" Gemini Google juga menambah tanda air pada imej secara automatik. Walau bagaimanapun, tanda air tidak selalunya boleh dipercayai. Jika tanda air statik, ia boleh dipangkas dengan mudah. Malah tanda air dinamik seperti Sora boleh dialih keluar menggunakan aplikasi khusus.

Apabila ditanya tentang perkara ini, Ketua Pegawai Eksekutif OpenAI, Sam Altman berhujah bahawa masyarakat perlu menyesuaikan diri dengan realiti bahawa sesiapa sahaja boleh mencipta video palsu. Sebelum Sora, tidak pernah wujud alat yang begitu popular, mudah diakses dan tidak memerlukan kemahiran untuk mencipta video sedemikian. Perspektifnya menekankan keperluan untuk bergantung pada kaedah pengesahan alternatif.

Semak metadata

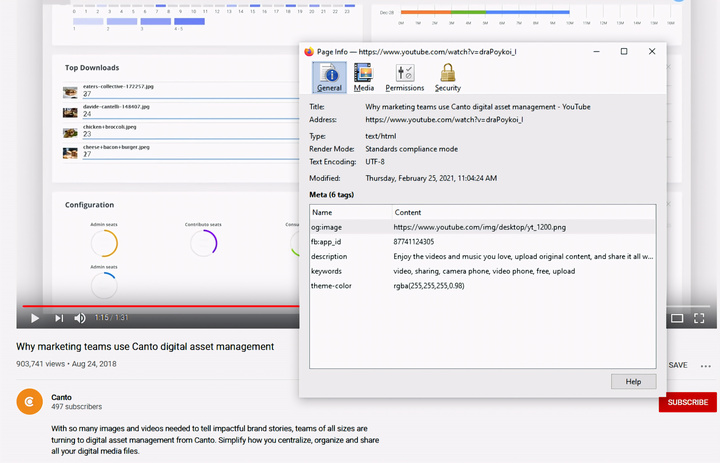

Memeriksa metadata – langkah penting dalam menentukan sama ada video dicipta oleh AI, seperti Sora. (Sumber: Canto)

Anda mungkin berpendapat bahawa menyemak metadata terlalu rumit, tetapi ia sebenarnya agak mudah dan sangat berkesan.

Metadata ialah satu set maklumat yang dilampirkan secara automatik pada kandungan apabila ia dicipta, seperti jenis kamera, lokasi, masa rakaman dan nama fail. Sama ada kandungan itu dihasilkan oleh manusia atau dihasilkan oleh AI, ia mempunyai metadata. Dengan kandungan yang dihasilkan oleh AI, metadata selalunya merangkumi maklumat atribusi sumber.

OpenAI ialah ahli Gabungan untuk Asal Usul dan Ketulenan Kandungan (C2PA), jadi video Sora akan mengandungi metadata C2PA. Anda boleh mengesahkannya menggunakan alat pengesahan inisiatif ketulenan kandungan:

Cara menyemak metadata:

- Lawati verify.contentauthenticity.org

- Muat naik fail yang hendak disemak.

- Tekan “Buka”

- Lihat maklumat dalam jadual di sebelah kanan.

Jika video itu dicipta oleh AI, ringkasan akan menyatakannya dengan jelas. Apabila menyemak video Sora, anda akan melihat baris "diterbitkan oleh OpenAI" dan maklumat yang mengesahkan video itu dicipta menggunakan AI. Semua video Sora mesti mempunyai maklumat ini untuk mengesahkan asal usulnya.

Sumber: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Foto] Perdana Menteri Pham Minh Chinh menerima kunjungan Gabenor Wilayah Tochigi (Jepun)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Langsung] Gala Anugerah Tindakan Komuniti 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Imej] Imej yang bocor menjelang majlis gala Anugerah Tindakan Komuniti 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Foto] Perdana Menteri Pham Minh Chinh menerima kunjungan Menteri Pendidikan dan Sukan Laos, Thongsalith Mangnormek](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

Komen (0)