Het kantoor van de procureur-generaal van New Hampshire maakte maandag bekend dat het onderzoek doet naar mogelijke kiezersmanipulatie na klachten over een nepstem die precies klonk als die van de Amerikaanse president Joe Biden en die kiezers opriep niet te stemmen bij de voorverkiezingen in de staat.

Onderzoekers waarschuwden ook voor het gebruik van deepfake-audio om politici en leiders na te bootsen. Bekende voorbeelden hiervan zijn te vinden in 2023 in het Verenigd Koninkrijk, India, Nigeria, Soedan, Ethiopië en Slowakije.

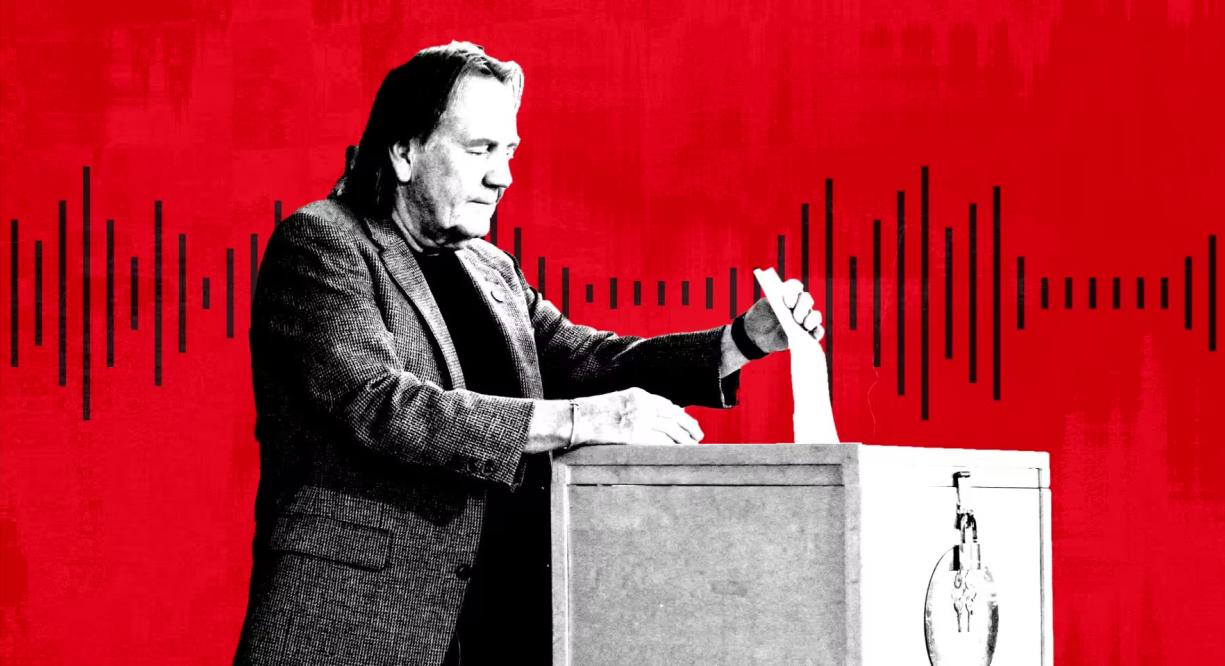

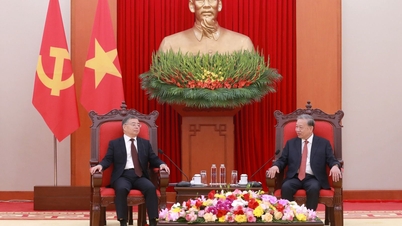

Een persoon stemt tijdens de voorverkiezingen in New Hampshire, VS. Foto: Getty

Deepfake-audio is volgens experts een populaire vorm van desinformatie geworden door de opkomst van een reeks goedkope en effectieve AI-tools van startups. Microsoft heeft ook een nieuw AI-model ontwikkeld dat stemmen kan kopiëren uit slechts drie seconden opnametijd.

"Als het om visuele manipulatie gaat, kent iedereen Photoshop of weet in ieder geval dat het bestaat", aldus Henry Ajder, AI- en deepfake-expert en consultant voor Adobe, Meta en EY. "Er is weinig bewustzijn over hoe audio gemanipuleerd kan worden, dus dat maakt ons wat mij betreft echt kwetsbaar."

In september ontdekte NewsGuard, een systeem dat de kwaliteit en betrouwbaarheid van nieuwssites beoordeelt, een netwerk van TikTok-accounts die zich voordeden als legitieme nieuwssites en die AI-gegenereerde content gebruikten om complottheorieën en politieke desinformatie te verspreiden. Deepfake-opnames, waaronder de stem van voormalig Amerikaans president Barack Obama, werden honderden miljoenen keren bekeken.

Volgens NewsGuard lijken de nep-voice-overs te zijn gegenereerd door een tool van ElevenLabs, dat wordt ondersteund door Andreessen Horowitz. De clips zijn inmiddels honderden miljoenen keren bekeken.

"Meer dan 99% van de gebruikers op ons platform creëert interessante, creatieve en nuttige content, maar we erkennen dat er gevallen van misbruik zijn en we hebben voortdurend beschermingsmaatregelen ontwikkeld en geïntroduceerd om dit te beperken", aldus ElevenLabs.

ElevenLabs, twee jaar geleden opgericht door voormalig Google- en Palantir-medewerkers Piotr Dabkowski en Mati Staniszewski, biedt rudimentaire AI-audiogeneratietools gratis aan met één klik. Abonnementsabonnementen variëren van $ 1 per maand tot $ 330 per maand en hoger voor wie op zoek is naar complexere diensten.

Vorig jaar waarschuwden Amerikaanse inlichtingendiensten in een rapport dat “gepersonaliseerde AI-zwendel aanzienlijk is toegenomen vanwege de introductie van geavanceerde en goed getrainde AI-stemkloonmodellen.”

Naast financieel gemotiveerde oplichtingspraktijken luiden politieke experts nu ook de noodklok over virale deepfake-audioclips en het gebruik van deepfakes voor robocalls of campagnes. "Je kunt een krachtige, wijdverspreide desinformatiecampagne opzetten door je op telefoons te richten", aldus AJ Nash, vicepresident en distinguished intelligence fellow bij cybersecuritygroep ZeroFox.

Sommige van deze bedrijven zijn proactief geweest in het vinden van andere manieren om desinformatie te bestrijden. Microsoft heeft een ethische verklaring uitgegeven waarin gebruikers worden opgeroepen om misbruik van hun AI-audiotool te melden. ElevenLabs heeft eigen detectietools ontwikkeld om audio-opnamen die door hun systeem zijn gemaakt, te identificeren.

Tijdens de Nigeriaanse verkiezingen van 2023 ging er een met behulp van AI gemanipuleerde clip viraal op sociale media. Hierin werd beweerd dat een oppositiekandidaat van plan was de stemming te manipuleren, aldus de mensenrechtenorganisatie Freedom House.

In Slowakije ging een nep-audio-opname viraal, slechts enkele dagen voor de presidentsverkiezingen in september. Daarop is te zien dat oppositiekandidaat Michal Šimečka de verkiezingen wil manipuleren.

"De deepfake in New Hampshire herinnert ons aan de vele manieren waarop deepfakes verwarring kunnen zaaien en ons kunnen misleiden", aldus Robert Weissman, voorzitter van de non-profit consumentenorganisatie Public Citizen. "Het politieke deepfake-moment is aangebroken. Beleidsmakers moeten snel maatregelen nemen om veiligheidsmaatregelen te treffen, anders krijgen we te maken met electorale chaos."

Mai Anh (volgens FT)

Bron

![[Foto] Diepzeezandafzettingen, oud houten schip An Bang loopt risico opnieuw begraven te worden](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/13/1763033175715_ndo_br_thuyen-1-jpg.webp)

![Dong Nai OCOP-transitie: [Artikel 3] Toerisme koppelen aan OCOP-productconsumptie](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Reactie (0)