Onderzoekers van DeepSeek hebben een nieuw experimenteel model aangekondigd met de naam V3.2-exp. Dit model is ontworpen om de kosten van inferentie aanzienlijk te verlagen bij gebruik in lange contextbewerkingen.

DeepSeek kondigde het model aan in een bericht op Hugging Face en plaatste ook een gelinkt academisch artikel op GitHub.

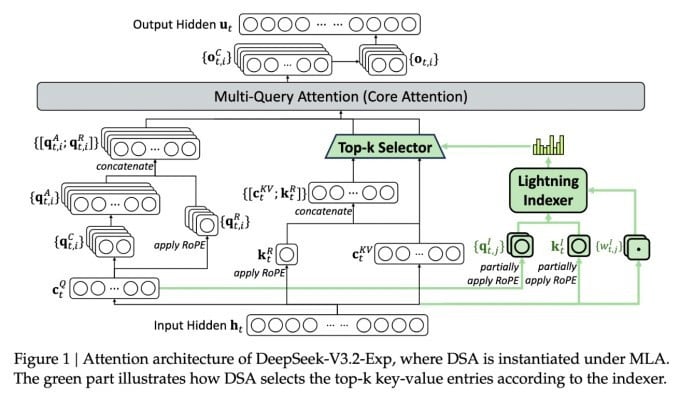

De belangrijkste functie van het complexe nieuwe model heet DeepSeek Sparse Attention. In wezen gebruikt het systeem een module genaamd "lightning indexer" om specifieke fragmenten uit het contextvenster te prioriteren.

DeepSeek kondigt kosteneffectief inferentiemodel aan.

Een apart systeem, het "fine-grained token selection system", selecteert vervolgens specifieke tokens uit die fragmenten om te laden in het beperkte aandachtsvenster van de module. Gecombineerd zorgen ze ervoor dat Sparse Attention-modellen kunnen werken op lange contextfragmenten met een relatief lage serverbelasting.

De voordelen van het systeem zijn aanzienlijk voor operaties met een lange context. Uit voorlopige tests van DeepSeek blijkt dat de kosten van een eenvoudige API-aanroep (inference function) tot wel de helft kunnen worden verlaagd in scenario's met een lange context.

Er zijn meer tests nodig om tot een robuustere beoordeling te komen, maar aangezien het model openbaar en gratis beschikbaar is op Hugging Face, zal het niet lang meer duren voordat tests door derden de claims in het artikel kunnen evalueren.

In tegenstelling tot andere AI Chatbot-modellen die veel energie verbruiken, richt DeepSeek zich op kostenbesparing, van training tot gebruik.

Het nieuwe model van DeepSeek is een van een reeks recente doorbraken die het probleem van de inferentiekosten aanpakken: de serverkosten voor het uitvoeren van een vooraf getraind AI-model, in tegenstelling tot de kosten voor het trainen ervan.

In het geval van DeepSeek zochten de onderzoekers naar manieren om de basisarchitectuur van de transformator efficiënter te maken. Ze kwamen tot de conclusie dat er aanzienlijke verbeteringen nodig waren.

DeepSeek, gevestigd in China, is een ongewone figuur in de AI-gekte, vooral voor degenen die AI-onderzoek zien als een concurrentiestrijd tussen de VS en China. Het bedrijf maakte eerder dit jaar furore met zijn R1-model, dat voornamelijk is getraind met behulp van reinforcement learning, tegen veel lagere kosten dan zijn Amerikaanse concurrenten.

Het model slaagde er echter niet in om de grootschalige revolutie in AI-training teweeg te brengen die sommigen hadden voorspeld, en het bedrijf verdween in de maanden die volgden langzaam uit de schijnwerpers.

Het is onwaarschijnlijk dat de nieuwe aanpak van ‘sparse attention’ zoveel verontwaardiging zal oproepen als R1, maar het zou Amerikaanse dienstverleners wel een aantal broodnodige trucjes kunnen leren om de kosten van inferentie laag te houden.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-halve/

Bron: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Foto] Het Permanente Comité van het Organiserende Subcomité voor het 14e Nationale Partijcongres komt bijeen om informatie en propaganda voor het congres te verzorgen.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/19/1763531906775_tieu-ban-phuc-vu-dh-19-11-9302-614-jpg.webp)

![[Foto] Premier Pham Minh Chinh en zijn vrouw ontmoeten de Vietnamese gemeenschap in Algerije](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/19/1763510299099_1763510015166-jpg.webp)

![[Foto] Secretaris-generaal van Lam ontvangt Slowaakse vicepremier en minister van Defensie Robert Kalinak](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/18/1763467091441_a1-bnd-8261-6981-jpg.webp)

![[Foto] Secretaris-generaal van Lam ontvangt CEO van AP Moller-Maersk Group, Denemarken](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/18/1763462288958_a3-bnd-8222-2510-jpg.webp)

Reactie (0)