Teknologien «tanketeksting» overrasker den vitenskapelige verden ved å gjøre hjernesignaler om til nøyaktige beskrivelser av bilder eller scener folk tenker på. Dette er en ny teknologi annonsert av en gruppe amerikanske forskere – et bemerkelsesverdig skritt fremover innen kunstig intelligens og nevrovitenskap: «tanketekstingsteknologi».

Systemet kan avkode hjerneaktivitet og konvertere det en person ser eller forestiller seg i hodet til en skriftlig beskrivelse med forbløffende nøyaktighet.

Arbeidet, publisert i tidsskriftet Science Advances, åpner for nye perspektiver i forståelsen av hvordan den menneskelige hjernen tolker verden rundt seg. Samtidig antyder denne nye teknologien også potensielle bruksområder for å støtte personer med språkforstyrrelser, for eksempel etter et hjerneslag.

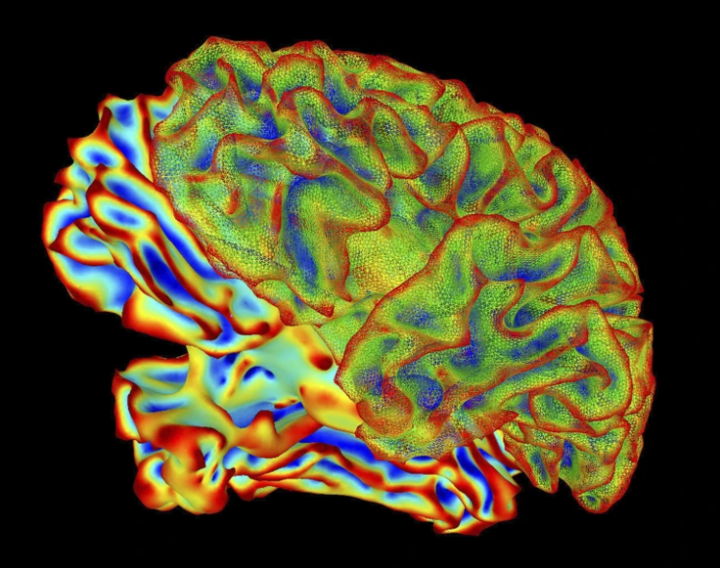

Tekstteknologi for tanketeksting kan avkode hjerneaktivitet og konvertere det folk ser eller forestiller seg i hodet til tekstbeskrivelser med høy nøyaktighet. (Foto: Nature.com)

Ifølge et forskerteam ved University of California, Berkeley (USA), bruker denne teknikken ikke-invasiv hjerneavbildningsteknologi for å registrere nevral aktivitet. Forskere bruker deretter avanserte AI-språkmodeller for å forutsi og nøyaktig beskrive hva deltakeren ser eller forestiller seg.

«Systemet kan forutsi på et svært detaljert nivå hva en person ser, noe som er enestående», sier beregningsorientert nevroforsker Alex Huth.

I over et tiår har forskere forsøkt å forutsi bilder eller lyder basert på hjernesignaler. Det er imidlertid fortsatt en stor utfordring å «oversette» komplekst innhold som videoer eller abstrakte former til språk.

Tidligere metoder gjenkjente bare enkeltstående nøkkelord i stedet for hele konteksten, som emne, handling og omkringliggende miljø.

For å overvinne denne begrensningen utviklet forskerteamet til Tomoyasu Horikawa, en nevroforsker ved NTT Communications Science Laboratories (Japan), en AI-modell med dyp språk. Først brukte de en dyp språkmodell for å analysere undertekstene i mer enn 2000 videoer, og konverterte hvert segment til en «meningssignatur» – en digital graf som representerer videoinnholdet.

Teamet trente deretter et annet AI-system til å gjenkjenne sammenhengen mellom disse «betydningssignaturene» og hjerneaktiviteten til seks deltakere mens de så videoene.

Resultatene viste at AI nøyaktig kunne «oversette» det deltakerne så eller forestilte seg til fullstendige beskrivende setninger, ikke bare til å liste opp nøkkelord.

Eksperter sier at teknologien for «mind-captioning» ikke bare er en milepæl innen nevrovitenskapelig forskning, men også åpner for muligheten for brede praktiske anvendelser. I fremtiden kan denne teknikken støtte mennesker som har mistet evnen til å snakke, og hjelpe dem med å kommunisere gjennom hjernesignaler.

Selv om det fortsatt er i en tidlig fase, markerer «tankelesning» et stort skritt fremover i reisen mot å dekode språket i menneskelig tankegang, og bringer muligheten for «tankelesning» som tidligere bare eksisterte i science fiction-filmer nærmere virkeligheten.

Kilde: https://vtcnews.vn/cong-nghe-dot-pha-tri-tue-nhan-tao-doc-duoc-suy-nghi-con-nguoi-ar985947.html

![[Foto] Hogging av bakker for å gi plass til folk som kan reise på rute 14E som ble rammet av jordskred](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762599969318_ndo_br_thiet-ke-chua-co-ten-2025-11-08t154639923-png.webp)

![[Foto] "Skipskirkegård" på Xuan Dai-bukten](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[Video] Hue-monumentene åpner igjen for å ønske besøkende velkommen](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Kommentar (0)