Statsadvokatkontoret i New Hampshire kunngjorde mandag at de etterforsker mulig manipulering av velgere etter klager om en falsk stemme som hørtes nøyaktig ut som USAs president Joe Biden som oppfordret velgerne til ikke å stemme i statens primærvalg.

Forskere advarte også mot bruk av deepfake-lyd for å etterligne politikere og ledere, med fremtredende tilfeller som fant sted i 2023 i Storbritannia, India, Nigeria, Sudan, Etiopia og Slovakia.

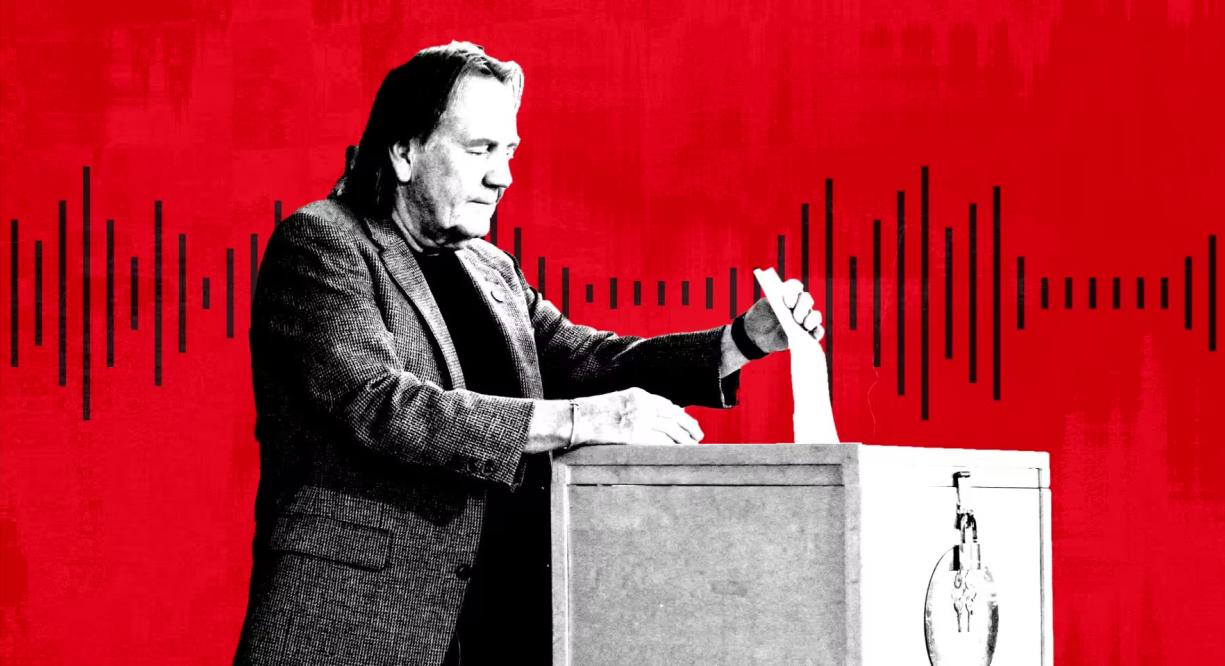

En person stemmer i primærvalget i New Hampshire, USA. Foto: Getty

Deepfake-lyd har blitt en populær form for feilinformasjon på grunn av fremveksten av en rekke billige og effektive AI-verktøy fra oppstartsbedrifter, ifølge eksperter. Microsoft har også utviklet en ny AI-modell som kan kopiere stemmer fra bare tre sekunders opptak.

«Når det gjelder visuell manipulasjon, er alle kjent med Photoshop, eller i det minste vet de at det finnes», sa Henry Ajder, en ekspert på kunstig intelligens og deepfake og konsulent for Adobe, Meta og EY. «Det er svært lite bevissthet om hvordan lyd kan manipuleres, så for meg gjør det oss virkelig sårbare.»

I september oppdaget NewsGuard, et system som vurderer kvaliteten og troverdigheten til nyhetssider, et nettverk av TikTok-kontoer som utga seg for å være legitime nyhetssider, og som brukte AI-generert innhold for å spre konspirasjonsteorier og politisk feilinformasjon. Deepfake-opptak, inkludert stemmen til tidligere amerikanske president Barack Obama, fikk hundrevis av millioner visninger.

De falske voiceover-stemmene ser ut til å ha blitt generert av et verktøy levert av Andreessen Horowitz-støttede ElevenLabs, mens klippene har fått hundrevis av millioner visninger, ifølge NewsGuard.

«Over 99 % av brukerne på plattformen vår lager interessant, kreativt og nyttig innhold, men vi erkjenner at det finnes tilfeller av misbruk, og vi har kontinuerlig utviklet og innført beskyttelse for å begrense dem», sa ElevenLabs.

ElevenLabs, grunnlagt for to år siden av tidligere Google- og Palantir-ansatte Piotr Dabkowski og Mati Staniszewski, tilbyr rudimentære verktøy for generering av AI-lyd gratis med bare et klikk. Abonnementsplanene varierer fra 1 dollar i måneden til 330 dollar i måneden og mer for de som ønsker mer komplekse tjenester.

I fjor advarte amerikanske etterretningstjenester i en rapport om at «personlig AI-svindel har økt betydelig på grunn av lanseringen av sofistikerte og veltrente AI-stemmekloningsmodeller».

I tillegg til økonomisk motiverte svindelforsøk, slår nå politiske eksperter alarm om virale deepfakes-lydklipp, samt bruken av deepfakes til automatiske samtaler eller kampanjer. «Du kan bygge en kraftig, utbredt desinformasjonskampanje ved å målrette telefoner», sa AJ Nash, visepresident og fremtredende etterretningsmedarbeider i cybersikkerhetsgruppen ZeroFox.

Noen av disse selskapene har vært proaktive i å finne andre måter å bekjempe feilinformasjon på. Microsoft har utstedt en etisk erklæring der de oppfordrer brukere til å rapportere misbruk av sitt AI-lydverktøy. ElevenLabs har bygget sine egne deteksjonsverktøy for å identifisere lydopptak laget av systemet deres.

Under Nigerias valg i 2023 gikk et AI-manipulert klipp viralt på sosiale medier «som angivelig antydet at en opposisjonskandidat planla å manipulere valget», ifølge menneskerettighetsgruppen Freedom House.

I Slovakia gikk et falskt lydopptak av opposisjonskandidaten Michal Šimečka, som tilsynelatende planla å rigge valget, viralt bare dager før landets presidentvalg i september.

«Deepfakes-kampanjen i New Hampshire er en påminnelse om de mange måtene deepfakes kan forvirre og jukse på», sa Robert Weissman, president i den ideelle forbrukerorganisasjonen Public Citizen. «Det politiske deepfake-øyeblikket er kommet. Politikere må handle raskt for å sette i verk sikkerhetstiltak, ellers vil vi stå overfor valgkaos.»

Mai Anh (ifølge FT)

[annonse_2]

Kilde

![[Foto] Generalsekretær To Lam mottar visepresident i Luxshare-ICT Group (Kina)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763211137119_a1-bnd-7809-8939-jpg.webp)

![[Foto] Statsminister Pham Minh Chinh møter representanter for fremragende lærere](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763215934276_dsc-0578-jpg.webp)

![[Foto] Panorama av finalerunden i Community Action Awards 2025](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763206932975_chi-7868-jpg.webp)

Kommentar (0)