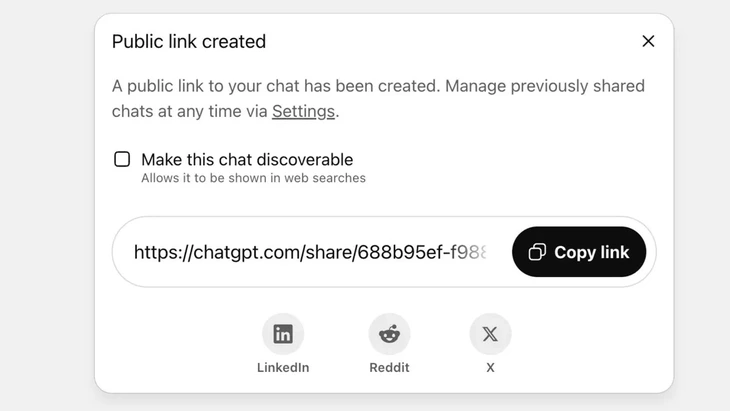

Funksjon for å dele chatter via offentlig lenke på ChatGPT - Foto: Techradar

ChatGPT når nå over 2,5 milliarder henvendelser fra globale brukere hver dag, noe som viser den økende populariteten til denne chatboten.

Dette verktøyet møter imidlertid sterk kritikk fra brukere, ettersom «delingsfunksjonen» har ført til at tusenvis av samtaler har lekket sensitiv informasjon til Google og noen søkemotorer på Internett.

Høy sikkerhetsrisiko

Vu Ngoc Son – leder for teknologiavdelingen i National Cyber Security Association (NCA) – vurderte at hendelsen ovenfor viser et høyt nivå av sikkerhetsrisiko for ChatGPT-brukere.

«Hendelsen ovenfor er ikke nødvendigvis en teknisk feil, ettersom det er et visst initiativ fra brukeren når de klikker på dele-knappen. Det kan imidlertid sies at problemet ligger i utformingen av AI-chatbot-produktet, der det har forvirret brukerne, og det ikke finnes sterke nok varslingstiltak om risikoen for at personopplysninger lekker ut hvis brukerne deler», analyserte Vu Ngoc Son.

På ChatGPT implementeres denne funksjonen etter at brukeren velger å dele chatten via en offentlig lenke. Innholdet lagres på OpenAIs server som et offentlig nettsted (chatgpt.com/share/...), uten behov for innlogging eller passord for å få tilgang.

Googles robotsøkeprogrammer skanner og indekserer disse sidene automatisk, slik at de vises i søkeresultatene, inkludert sensitiv tekst, bilder eller chatdata.

Mange brukere var ikke klar over risikoen, og trodde de delte chatten med venner eller kontakter. Dette førte til at tusenvis av samtaler ble eksponert, i noen tilfeller inneholdende sensitiv personlig informasjon.

Selv om OpenAI raskt fjernet denne funksjonen sent i juli 2025 etter kritikk fra lokalsamfunnet, tok det fortsatt tid å koordinere med Google for å fjerne de gamle indeksene. Spesielt med det komplekse lagringssystemet, som inkluderer Googles cache-servere, kan ikke dette gjøres raskt.

Ikke behandle AI-chatboter som en «sikkerhetsboks»

Datasikkerhetsekspert Vu Ngoc Son – teknologisjef i National Cyber Security Association (NCA) – Foto: CHI HIEU

Lekkasje av tusenvis av chatlogger kan utgjøre risikoer for brukere, som å avsløre personlige og forretningshemmeligheter, skade på omdømme, økonomiske risikoer eller til og med sikkerhetsfarer på grunn av avsløring av hjemmeadresser.

«AI-aktiverte chatboter er nyttige, men ikke en «svart boks», ettersom delte data kan eksistere for alltid på nettet hvis de ikke kontrolleres.»

Hendelsen ovenfor er absolutt en lærdom for både leverandører og brukere. Andre leverandører av AI-tjenester kan lære av denne erfaringen og utforme funksjoner med tydeligere og mer transparente advarsler.

Samtidig må brukerne også proaktivt begrense ukontrollert publisering av identifiserende eller personlig informasjon på AI-plattformer», anbefalte sikkerhetsekspert Vu Ngoc Son.

Ifølge datasikkerhetseksperter viser hendelsen ovenfor behovet for juridiske korridorer og cybersikkerhetsstandarder for AI. Leverandører og utviklere av AI må også designe systemer som sikrer sikkerhet, og unngår risikoen for datalekkasje, som for eksempel lekkasje gjennom dårlige sårbarheter; programvaresårbarheter som fører til databaseangrep; dårlig kontroll som fører til forgiftning, misbruk for å svare på falske og forvrengte spørsmål.

Brukere må også kontrollere delingen av personlig informasjon med AI, ikke deling av sensitiv informasjon. Ved reelt behov anbefales det å bruke anonym modus eller aktivt kryptere informasjon for å unngå at data kobles direkte til bestemte individer.

Kilde: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Foto] Hogging av bakker for å gi plass til folk som kan reise på rute 14E som ble rammet av jordskred](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762599969318_ndo_br_thiet-ke-chua-co-ten-2025-11-08t154639923-png.webp)

![[Video] Hue-monumentene åpner igjen for å ønske besøkende velkommen](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Kommentar (0)