DeepSeek, najgorętszy chiński startup ostatnich dni, wyraził wątpliwości co do twierdzeń firmy, że jest w stanie stworzyć sztuczną inteligencję dorównującą OpenAI, dysponując kapitałem w wysokości zaledwie 5 milionów dolarów.

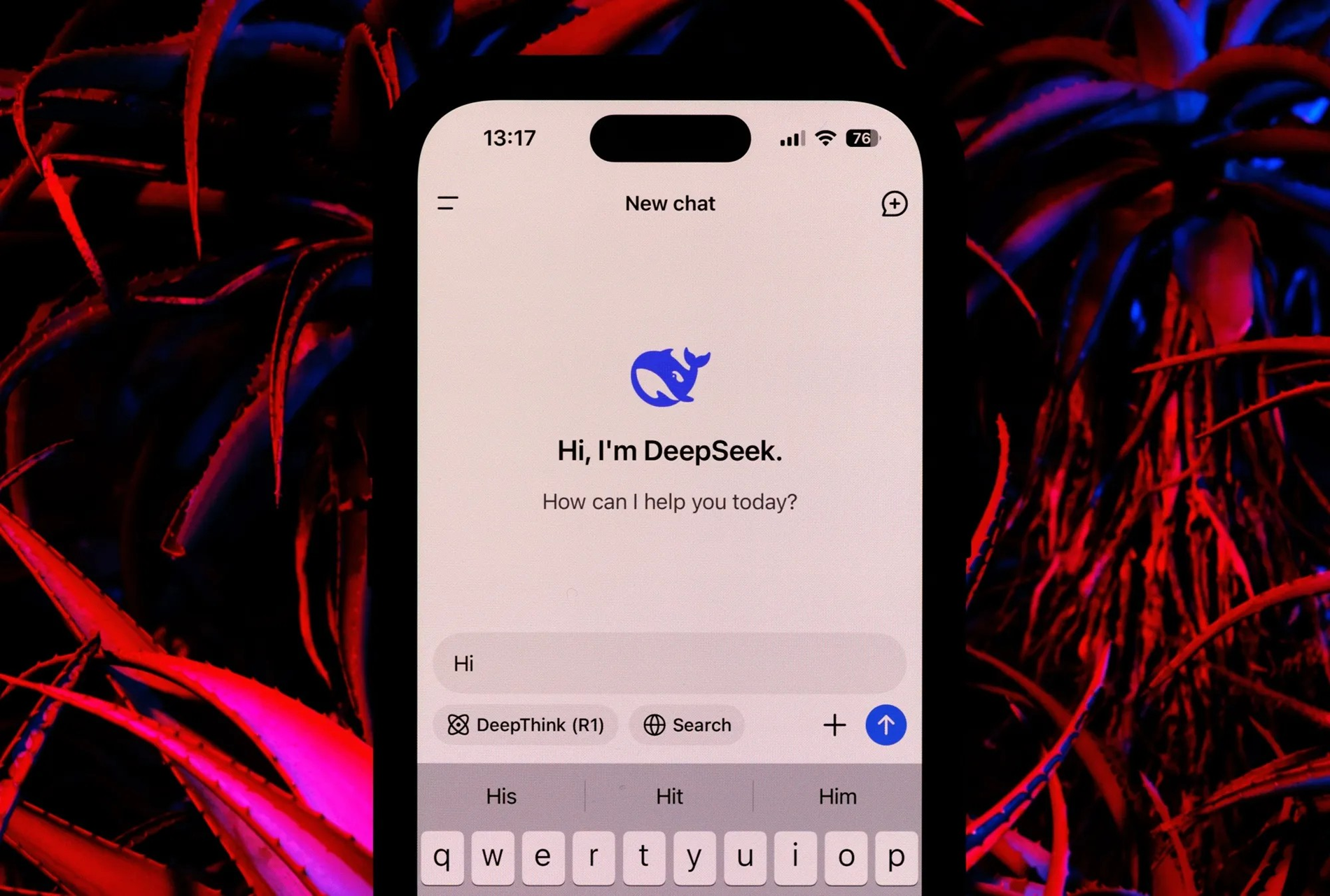

DeepSeek wzbudził szerokie zainteresowanie mediów i serwisów społecznościowych na początku Roku Węża, wywołując znaczne wstrząsy na światowych rynkach akcji.

Jednak najnowszy raport firmy doradztwa finansowego Bernstein ostrzega, że pomimo imponujących osiągnięć, twierdzenie o stworzeniu systemu AI porównywalnego z OpenAI za zaledwie 5 milionów dolarów jest nieprawdziwe.

Według Bernsteina oświadczenie DeepSeek jest mylące i nie odzwierciedla szerszego obrazu.

„Naszym zdaniem DeepSeek nie „stworzył OpenAI za 5 milionów dolarów”; modele są fantastyczne, ale nie uważamy, żeby były cudami; a panika, która wybuchła w ten weekend, wydaje się przesadzona” – czytamy w raporcie.

DeepSeek opracowuje dwa główne modele sztucznej inteligencji: DeepSeek-V3 i DeepSeek R1. Model języka V3 o dużej skali wykorzystuje architekturę MOE, łącząc mniejsze modele w celu osiągnięcia wysokiej wydajności przy mniejszym zużyciu zasobów obliczeniowych niż modele tradycyjne.

Z drugiej strony model V3 ma 671 miliardów parametrów, przy czym w dowolnym momencie aktywnych jest 37 miliardów parametrów. Zastosowano w nim takie innowacje, jak MHLA, która redukuje wykorzystanie pamięci, a także wykorzystano FP8 w celu zwiększenia wydajności.

Szkolenie modelu V3 wymagało klastra 2048 procesorów graficznych Nvidia H800 w ciągu dwóch miesięcy, co odpowiada 5,5 milionom godzin pracy GPU. Chociaż niektóre szacunki szacują koszt szkolenia na około 5 milionów dolarów, raport Bernsteina podkreśla, że kwota ta obejmuje jedynie zasoby obliczeniowe i nie uwzględnia znacznych kosztów związanych z badaniami, testowaniem i innymi wydatkami rozwojowymi.

Model DeepSeek R1 bazuje na fundamencie V3 i wykorzystuje technologię uczenia przez wzmacnianie (RL) oraz inne techniki zapewniające zdolność wnioskowania.

Model R1 może konkurować z modelami OpenAI w zadaniach wnioskowania. Bernstein zwraca jednak uwagę, że opracowanie R1 wymaga znacznych zasobów, choć nie zostały one szczegółowo opisane w raporcie DeepSeek.

Komentując DeepSeek, Bernstein pochwalił modele za imponujące. Na przykład model V3 działa równie dobrze lub lepiej niż inne główne modele językowe w lingwistyce, programowaniu i matematyce, a jednocześnie wymaga mniej zasobów.

Proces wstępnego trenowania wersji 3 wymagał zaledwie 2,7 miliona godzin pracy GPU, czyli 9% zasobów obliczeniowych niektórych innych modeli najwyższej klasy.

Bernstein stwierdził, że choć postępy DeepSeek są godne uwagi, należy wystrzegać się przesadnych twierdzeń. Pomysł stworzenia konkurenta dla OpenAI za zaledwie 5 milionów dolarów wydaje się chybiony.

(Według Times of India)

Źródło: https://vietnamnet.vn/deepseek-khong-the-lam-ai-tuong-duong-openai-voi-5-trieu-usd-2367340.html

Komentarz (0)