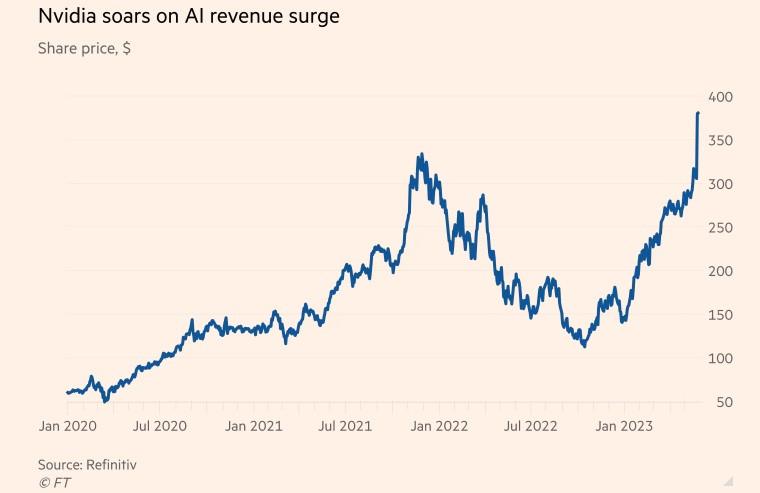

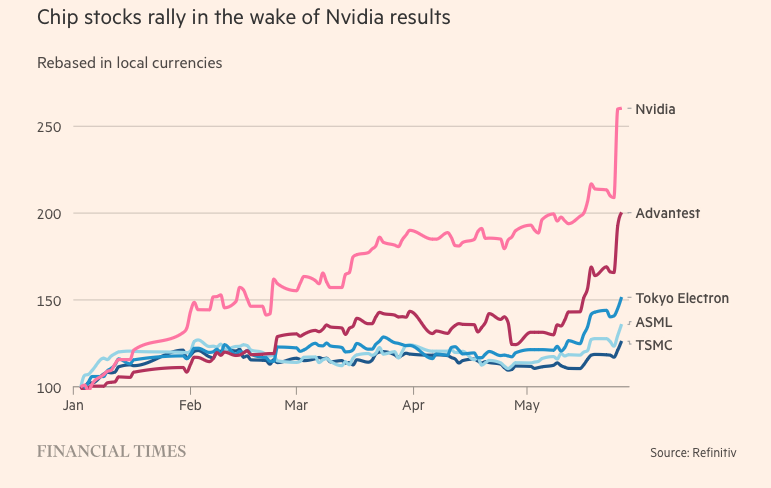

Firma Nvidia była kiedyś znana jako producent układów scalonych wykorzystywanych w grach wideo, jednak w ostatnich latach przeniosła swoją działalność na rynek centrów danych.

Amerykańska firma produkująca układy scalone prosperowała w czasie pandemii, ponieważ popyt na gry i aplikacje chmurowe gwałtownie wzrósł, a moda na kopanie kryptowalut rozprzestrzeniła się na cały świat . Do końca roku obrotowego, kończącego się 29 stycznia, działalność związana z układami scalonymi dla centrów danych stanowiła ponad 50% przychodów firmy.

Tymczasem popularny chatbot ChatGPT w tym roku wyniósł generatywną sztuczną inteligencję (AI) na wyższy poziom, wykorzystując ogromne ilości istniejących danych do tworzenia nowych treści na tematy od poezji po programowanie komputerowe.

Microsoft i Alphabet, dwaj giganci technologiczni, to również duzi gracze w branży sztucznej inteligencji, wierzący, że technologie generatywne mogą zmienić sposób, w jaki ludzie pracują. Obie firmy rozpoczęły wyścig o integrację sztucznej inteligencji z wyszukiwarkami i oprogramowaniem biurowym, dążąc do zdominowania tej branży.

Goldman Sachs szacuje, że do 2030 roku amerykańskie inwestycje w sztuczną inteligencję mogą stanowić około 1% PKB kraju.

Superkomputery wykorzystywane do przetwarzania danych i obsługi generatywnej sztucznej inteligencji (AI) opierają się na procesorach graficznych (GPU). Procesory graficzne (GPU) są zaprojektowane do wykonywania specyficznych obliczeń związanych z obliczeniami AI, znacznie wydajniej niż jednostki centralne innych producentów chipów, takich jak Intel. Na przykład, ChatGPT firmy OpenAI jest napędzany przez tysiące procesorów graficznych Nvidia.

Tymczasem Nvidia ma około 80% udziału w rynku GPU. Głównymi konkurentami Nvidii są Advanced Micro Devices oraz własne układy AI firm technologicznych, takich jak Amazon, Google i Meta Platforms.

Sekret sublimacji

Skok firmy w przyszłość był możliwy dzięki H100, układowi opartemu na nowej architekturze Nvidii o nazwie „Hopper” – nazwanej na cześć amerykańskiej pionierki programowania, Grace Hopper. Eksplozja sztucznej inteligencji sprawiła, że H100 stał się najgorętszym towarem w Dolinie Krzemowej.

Te ogromne układy scalone używane w centrach danych zawierają 80 miliardów tranzystorów, czyli pięć razy więcej krzemu niż te w najnowszych iPhone'ach. Chociaż kosztują dwa razy więcej niż ich poprzednik, A100 (wydany w 2020 roku), użytkownicy H100 twierdzą, że oferują trzykrotnie większą wydajność.

Model H100 okazał się szczególnie popularny wśród dużych firm technologicznych, takich jak Microsoft i Amazon, które budują całe centra danych skoncentrowane na obciążeniach związanych ze sztuczną inteligencją, a także wśród startupów nowej generacji zajmujących się sztuczną inteligencją, takich jak OpenAI, Anthropic, Stability AI i Inflection AI, ponieważ obiecuje wyższą wydajność, która może przyspieszyć wprowadzanie produktów na rynek lub z czasem obniżyć koszty szkoleń.

„To jedno z najrzadszych zasobów inżynieryjnych, jakie istnieją” – powiedział Brannin McBee, dyrektor ds. strategii i założyciel CoreWeave, startupu zajmującego się chmurą obliczeniową opartą na sztucznej inteligencji, który był jedną z pierwszych firm, które otrzymały dostawy H100 na początku tego roku.

Inni klienci nie mają tyle szczęścia co CoreWeave, czekając nawet sześć miesięcy na produkt, który będzie w stanie wytrenować ich ogromne modele danych. Wiele startupów zajmujących się sztuczną inteligencją obawia się, że Nvidia nie będzie w stanie sprostać zapotrzebowaniu rynku.

Elon Musk zamówił również tysiące układów Nvidia dla swojego startupu zajmującego się sztuczną inteligencją, stwierdzając, że „w tej chwili trudniej jest zdobyć procesory graficzne niż leki”.

„Koszty obliczeń gwałtownie wzrosły. Minimalna kwota wydana na sprzęt serwerowy wykorzystywany do tworzenia kreatywnej sztucznej inteligencji osiągnęła 250 milionów dolarów” – powiedział prezes Tesli.

Choć H100 jest na czasie, przełom w dziedzinie sztucznej inteligencji firmy Nvidia sięga dwóch dekad wstecz, a konkretnie innowacji w oprogramowaniu, a nie w sprzęcie. W 2006 roku firma wprowadziła oprogramowanie Cuda, które pozwala na wykorzystanie procesorów graficznych jako akceleratorów do zadań innych niż grafika.

„Nvidia dostrzegła przyszłość przed wszystkimi innymi i postawiła na programowalne procesory graficzne. Dostrzegli szansę, postawili na odważne rozwiązania i konsekwentnie wyprzedzali konkurencję” – powiedział Nathan Benaich, partner w Air Street Capital i inwestor w startupy zajmujące się sztuczną inteligencją.

(Według Reutersa, FT)

Źródło

![[Zdjęcie] Premier Pham Minh Chinh przyjmuje delegację Semiconductor Manufacturing International (SEMI)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/06/1762434628831_dsc-0219-jpg.webp)

![[Zdjęcie] Zakończenie XIV Konferencji XIII KC PZPR](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/06/1762404919012_a1-bnd-5975-5183-jpg.webp)

Komentarz (0)