GPU to mózg komputera AI

Mówiąc najprościej, jednostka przetwarzania grafiki (GPU) pełni funkcję mózgu komputera AI.

Jak zapewne wiesz, jednostka centralna (CPU) to mózg komputera. Zaletą GPU jest to, że jest to wyspecjalizowany procesor, który może wykonywać złożone obliczenia. Najszybszym sposobem na to jest wykorzystanie grup GPU do rozwiązania tego samego problemu. Jednak trenowanie modelu sztucznej inteligencji (AI) może zająć tygodnie, a nawet miesiące. Po zbudowaniu jest on umieszczany w systemie komputerowym front-end, a użytkownicy mogą zadawać pytania modelowi AI w procesie zwanym wnioskowaniem.

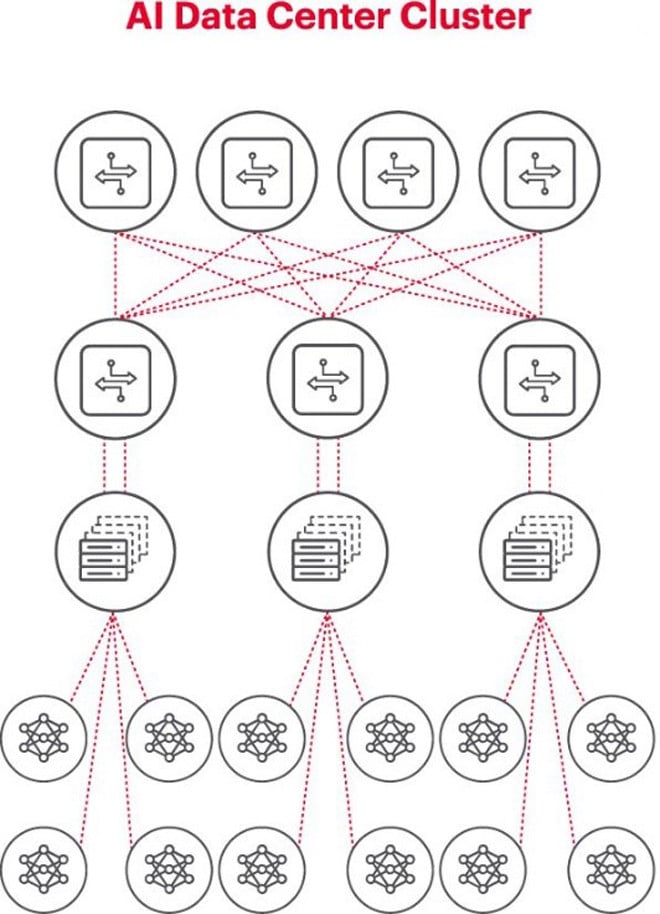

Komputer AI zawierający wiele procesorów graficznych

Najlepszą architekturą do rozwiązywania problemów związanych ze sztuczną inteligencją jest użycie klastra procesorów graficznych w szafie rack, podłączonego do przełącznika na szczycie szafy. Wiele szaf GPU można połączyć w hierarchiczną sieć. Wraz ze wzrostem złożoności problemu rosną wymagania dotyczące GPU, a niektóre projekty mogą wymagać wdrożenia klastrów składających się z tysięcy GPU.

Każdy klaster AI to mała sieć

Podczas tworzenia klastra AI konieczne jest utworzenie niewielkiej sieci komputerowej, która połączy i umożliwi procesorom GPU współpracę oraz efektywne udostępnianie danych.

Powyższy rysunek ilustruje klaster AI, w którym kółka u dołu reprezentują przepływy pracy realizowane na procesorach GPU. Procesory GPU łączą się z przełącznikami typu top-of-rack (ToR). Przełączniki ToR łączą się również z przełącznikami szkieletowymi sieci przedstawionymi powyżej, co pokazuje przejrzystą hierarchię sieci wymaganą w przypadku użycia wielu procesorów GPU.

Sieci stanowią wąskie gardło we wdrażaniu sztucznej inteligencji

Jesienią ubiegłego roku, podczas szczytu Open Computer Project (OCP), na którym delegaci pracowali nad budową infrastruktury AI nowej generacji, delegat Loi Nguyen z Marvell Technology poruszył kluczową kwestię: „sieci stanowią nowe wąskie gardło”.

Z technicznego punktu widzenia, wysokie opóźnienie pakietów lub ich utrata spowodowana przeciążeniem sieci może powodować ponowne wysyłanie pakietów, co znacznie wydłuża czas realizacji zadania (JCT). W rezultacie firmy marnują procesory graficzne warte miliony, a nawet dziesiątki milionów dolarów z powodu nieefektywnych systemów AI, co generuje straty zarówno w przychodach, jak i w czasie wprowadzania produktu na rynek.

Pomiar jest kluczowym warunkiem udanego działania sieci AI

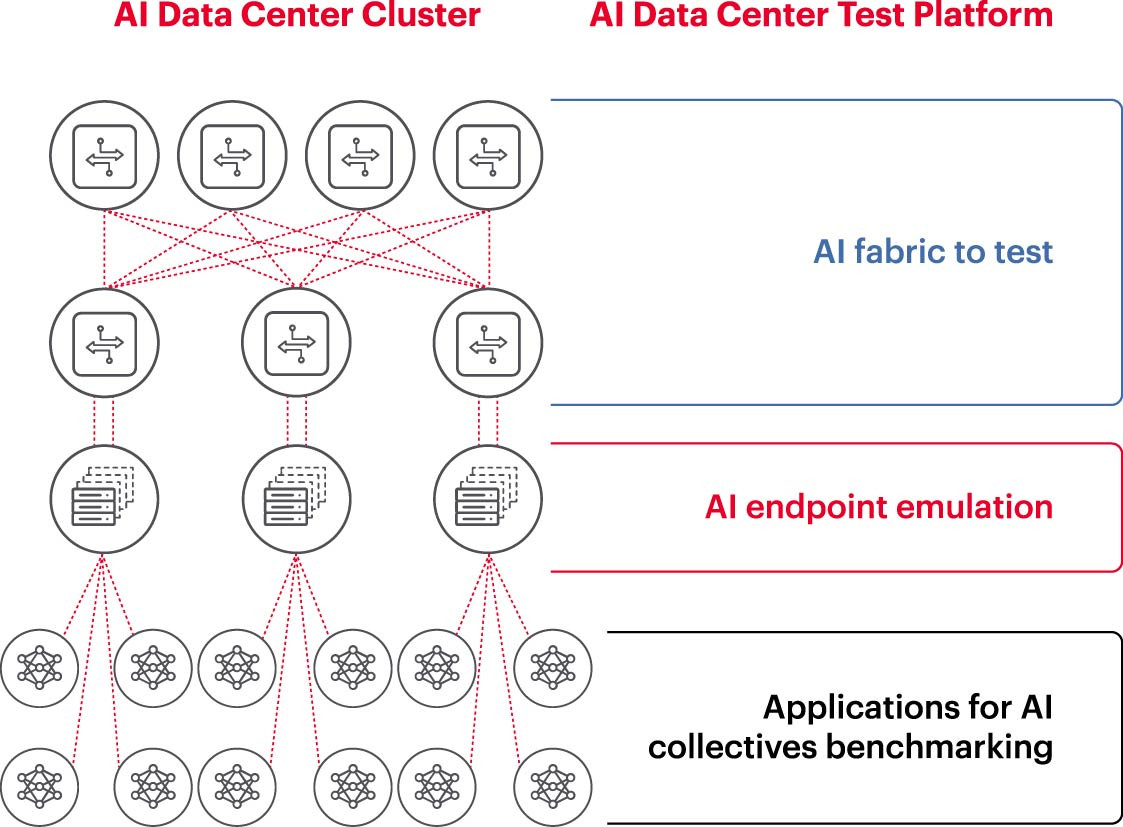

Aby skutecznie uruchomić klaster AI, konieczne jest pełne wykorzystanie mocy GPU, co skróci czas szkolenia i pozwoli na wdrożenie modelu uczenia się w celu maksymalizacji zwrotu z inwestycji. Dlatego konieczne jest testowanie i ocena wydajności klastra AI (rysunek 2). Zadanie to nie jest jednak łatwe, ponieważ z punktu widzenia architektury systemu istnieje wiele ustawień i relacji między GPU a strukturami sieciowymi, które muszą się wzajemnie uzupełniać, aby rozwiązać problem.

Stwarza to wiele wyzwań w pomiarze sieci AI:

- Trudności w odtworzeniu całych sieci produkcyjnych w laboratorium ze względu na ograniczenia kosztów, sprzętu, niedobór wykwalifikowanych inżynierów zajmujących się sztuczną inteligencją sieciową, przestrzeń, zasilanie i temperaturę.

- Pomiary w systemie produkcyjnym powodują zmniejszenie dostępnej mocy przerobowej samego systemu produkcyjnego.

- Trudności w dokładnym odtworzeniu problemów ze względu na różnice w skali i zakresie problemów.

- Złożoność zbiorowych połączeń między procesorami graficznymi.

Aby sprostać tym wyzwaniom, firmy mogą przetestować podzbiór zalecanych konfiguracji w środowisku laboratoryjnym, aby porównać kluczowe wskaźniki, takie jak czas wykonania zadania (JCT), przepustowość, jaką może osiągnąć zespół ds. sztucznej inteligencji, oraz porównać ją z wykorzystaniem platformy przełączającej i pamięci podręcznej. Takie testy porównawcze pomagają znaleźć właściwą równowagę między obciążeniem procesora graficznego/przetwarzania a projektem/konfiguracją sieci. Po uzyskaniu satysfakcjonujących rezultatów, architekci komputerowi i inżynierowie sieciowi mogą przenieść te konfiguracje do produkcji i zmierzyć nowe rezultaty.

Korporacyjne laboratoria badawcze, instytucje akademickie i uniwersytety pracują nad analizą każdego aspektu budowy i obsługi efektywnych sieci AI, aby sprostać wyzwaniom związanym z pracą w dużych sieciach, zwłaszcza w obliczu ciągłego rozwoju najlepszych praktyk. To oparte na współpracy, powtarzalne podejście to jedyny sposób, w jaki firmy mogą wykonywać powtarzalne pomiary i szybko testować scenariusze „co by było, gdyby”, które stanowią podstawę optymalizacji sieci pod kątem AI.

(Źródło: Keysight Technologies)

Źródło: https://vietnamnet.vn/ket-noi-mang-ai-5-dieu-can-biet-2321288.html

![[Zdjęcie] Zakończenie XIV Konferencji XIII KC PZPR](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/06/1762404919012_a1-bnd-5975-5183-jpg.webp)

Komentarz (0)