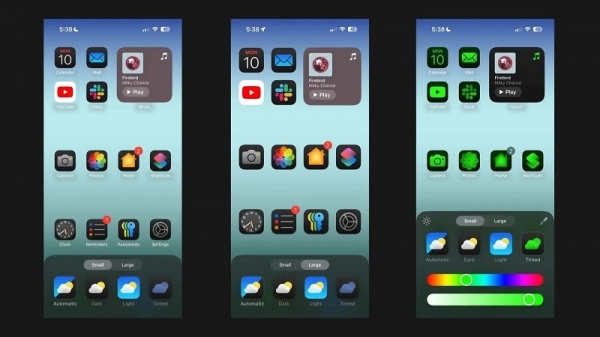

Segundo o Android Authority , um artigo de pesquisa da Apple detalha uma solução para executar grandes modelos de linguagem (LLMs) em dispositivos com memória RAM limitada. O artigo revela como a empresa pode armazenar "parâmetros do modelo" e carregar uma parte deles na RAM do dispositivo quando necessário, em vez de carregar o modelo inteiro na RAM.

A Apple pretende ajudar iPhones mais antigos com menos RAM a executar inteligência artificial geral.

O artigo afirma que esse método permite executar modelos que exigem o dobro da RAM que um iPhone pode ter, garantindo ainda velocidades de inferência de 4 a 5 vezes e de 20 a 25 vezes maiores em comparação com métodos de carregamento simples na CPU e na GPU, respectivamente.

Implementar IA sintética em um dispositivo com mais RAM seria extremamente vantajoso, pois permitiria velocidades de leitura/gravação mais rápidas. A velocidade é crucial para a IA no dispositivo, possibilitando tempos de inferência muito mais rápidos, já que os usuários não precisariam esperar dezenas de segundos (ou mais) por uma resposta ou resultado final. Tudo isso significa que um assistente de IA no dispositivo poderia potencialmente funcionar em velocidades conversacionais, gerar imagens/texto muito mais rapidamente, resumir artigos com maior agilidade, etc. A solução da Apple, no entanto, significa que os usuários não precisam necessariamente de muita RAM para acelerar a capacidade de resposta das tarefas de IA no dispositivo.

A abordagem da Apple pode permitir que iPhones, tanto antigos quanto novos, ofereçam recursos de IA sintética diretamente em seus dispositivos. Isso é importante porque os iPhones da Apple geralmente oferecem menos RAM do que os celulares Android de última geração. A série iPhone 11, por exemplo, oferece apenas 4 GB de RAM, enquanto até mesmo o iPhone 15 padrão tem apenas 6 GB.

A Apple não é a única empresa de dispositivos móveis trabalhando na miniaturização do LLM. Os chips topo de linha recentes da Qualcomm e da MediaTek suportam precisão INT4 para reduzir esses modelos. De qualquer forma, as empresas estão buscando novas maneiras de reduzir os requisitos de sistema para IA embarcada, permitindo que até mesmo celulares de baixo custo ofereçam o recurso.

Link da fonte

![[Foto] O primeiro-ministro Pham Minh Chinh presidiu uma reunião para discutir soluções para superar as consequências das inundações nas províncias centrais.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/29/1761716305524_dsc-7735-jpg.webp)

![[Foto] Hue: Por dentro da cozinha que doa milhares de refeições por dia para pessoas em áreas alagadas.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/29/1761738508516_bepcomhue-jpg.webp)

![[Foto] Inundação no lado direito do portão, entrada da Cidadela de Hue](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/28/1761660788143_ndo_br_gen-h-z7165069467254-74c71c36d0cb396744b678cec80552f0-2-jpg.webp)

![[Foto] O presidente da Assembleia Nacional, Tran Thanh Man, recebeu uma delegação do Partido Social-Democrata da Alemanha](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/28/1761652150406_ndo_br_cover-3345-jpg.webp)

![[Infográfico] Situação socioeconômica do Vietnã em 5 anos (2021-2025): Números impressionantes](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/29/1761730747150_anh-man-hinh-2025-10-29-luc-16-38-55.png)

Comentário (0)