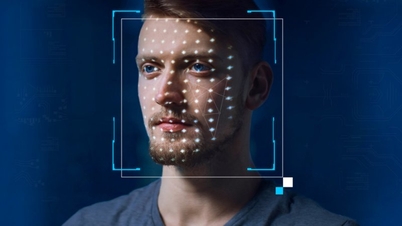

A rede social X teve que bloquear buscas por Taylor Swift após imagens pornográficas deepfake da cantora viralizarem. Ao buscar por Taylor Swift na plataforma X, os usuários verão uma mensagem de erro e uma solicitação para recarregar a página. Joe Benarroch – Diretor de Operações Comerciais da X – disse que esta é uma ação preliminar e está sendo realizada com cautela.

Imagens pornográficas de Taylor Swift geradas por IA começaram a circular no X em 24 de janeiro, levando fãs da cantora a postar uma série de fotos reais da estrela para "afogar" o deepfake. Eles também pediram ao X que tomasse medidas mais enérgicas para excluir essas fotos e denunciar contas que compartilhassem fotos falsas. O slogan "proteja Taylor Swift" também se tornou uma tendência na plataforma.

Um dia depois, as contas denunciadas foram suspensas ou restritas, mas ainda era fácil encontrar pornografia de IA no X.

Em uma declaração no fim de semana, a X afirmou que proíbe o compartilhamento de imagens gráficas sem a permissão do usuário e tem uma política de tolerância zero para esse tipo de conteúdo. A declaração não mencionou Swift nominalmente.

“Nossa equipe está removendo ativamente todas as imagens identificadas e tomando as medidas cabíveis contra as contas que as publicaram. Monitoraremos a situação de perto para garantir que quaisquer novas violações sejam tratadas imediatamente e o conteúdo seja removido”, disse X.

Os avanços na IA generativa facilitaram a falsificação de imagens pornográficas de outras pessoas. Com a X, após passar para o controle de Elon Musk em 2022, muitas regulamentações de censura foram flexibilizadas, enquanto ele demitiu milhares de funcionários para estabilizar suas finanças.

De acordo com a NBC News, não está claro de onde as imagens deepfake de Taylor Swift se originaram, mas elas continham marca d'água para indicar que vieram de um site conhecido por distribuir imagens pornográficas falsas de celebridades. O site também possui uma seção dedicada a deepfakes com IA. As fotos falsas de Swift foram visualizadas mais de 27 milhões de vezes e curtidas mais de 260.000 vezes após 19 horas de publicação.

Após o incidente, o CEO da Microsoft, Satya Nadella, pediu a implementação de mais medidas de proteção para regulamentar a IA. Em entrevista à NBC News, ele argumentou que temos a responsabilidade de monitorar essa tecnologia emergente para que mais conteúdo seguro possa ser produzido.

Respondendo a uma pergunta sobre o deepfake de Swift, o chefe da Microsoft disse: "Sim, temos que agir. Acho que todos nós nos beneficiamos de um mundo online seguro. Não acho que ninguém queira um mundo online completamente inseguro tanto para criadores quanto para consumidores de conteúdo. Então, acho que precisamos agir rapidamente sobre essa questão."

De acordo com a 404 Media, um grupo de bate-papo do Telegram afirmou ter usado a ferramenta Designer, gerada por IA da Microsoft, para falsificar a foto de Taylor. Nadella não comentou diretamente as informações da 404 Media, mas em um comunicado enviado ao site de notícias, a Microsoft informou que estava investigando a reportagem e tomaria as medidas cabíveis.

O governo do presidente dos EUA, Joe Biden, chamou a disseminação do deepfake pornográfico de Taylor Swift de "alarmante" e pediu que as empresas de mídia social examinem seu "papel vital" na aplicação de regulamentações para impedir a disseminação de informações falsas e imagens sensíveis sem consentimento.

Em outubro de 2023, o presidente Biden assinou uma ordem executiva sobre IA focada na regulamentação de tecnologias emergentes e seus riscos.

(De acordo com The Hill, WSJ)

[anúncio_2]

Fonte

![[Foto] O primeiro-ministro Pham Minh Chinh se reúne com o presidente da Assembleia Nacional Húngara, Kover Laszlo](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760970413415_dsc-8111-jpg.webp)

![[Foto] O Primeiro Ministro Pham Minh Chinh recebeu o Sr. Yamamoto Ichita, Governador da Província de Gunma (Japão)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/21/1761032833411_dsc-8867-jpg.webp)

![[Foto] Moradores de Da Nang "caçam fotos" de grandes ondas na foz do Rio Han](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/21/1761043632309_ndo_br_11-jpg.webp)

Comentário (0)