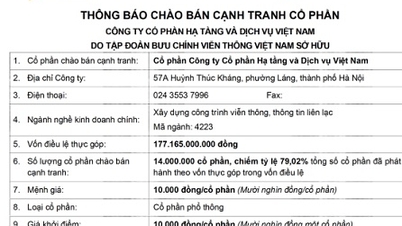

GPU-ul este creierul computerului cu inteligență artificială

Simplu spus, unitatea de procesare grafică (GPU) acționează ca creierul computerului cu inteligență artificială.

După cum știți, unitatea centrală de procesare (CPU) este creierul computerului. Avantajul unui GPU este că este un procesor specializat, care poate efectua calcule complexe. Cea mai rapidă modalitate de a face acest lucru este ca grupuri de GPU-uri să rezolve aceeași problemă. Cu toate acestea, antrenarea unui model de inteligență artificială poate dura săptămâni sau chiar luni. Odată construit, acesta este plasat într-un sistem informatic front-end, iar utilizatorii pot pune întrebări modelului de inteligență artificială, un proces numit inferență.

Un computer cu inteligență artificială care conține mai multe GPU-uri

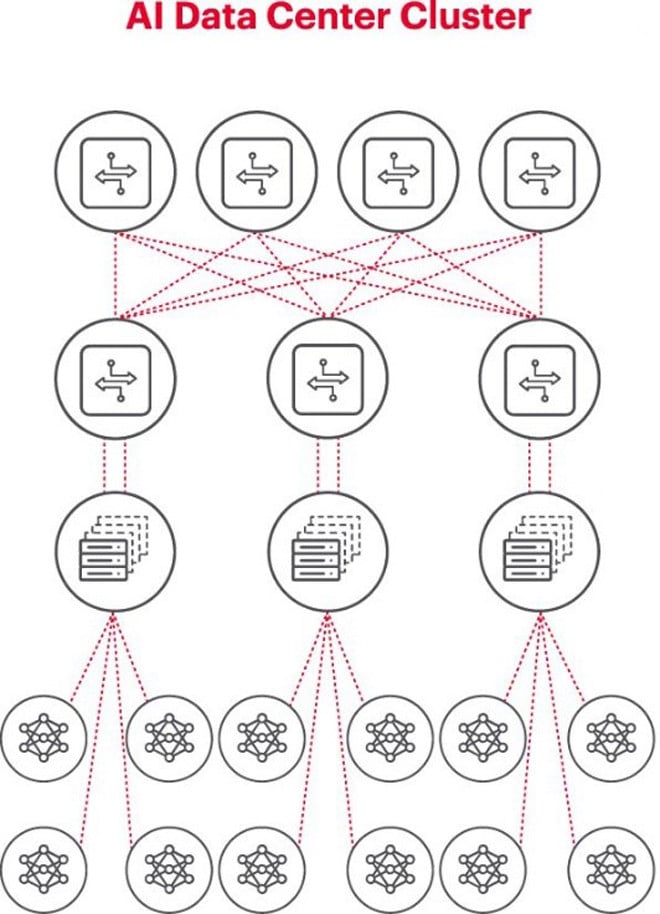

Cea mai bună arhitectură pentru problemele de inteligență artificială este utilizarea unui cluster de GPU-uri într-un rack, conectate la un switch în partea superioară a rack-ului. Mai multe rack-uri de GPU-uri pot fi conectate într-o ierarhie de rețea. Pe măsură ce problema devine mai complexă, cerințele GPU cresc, iar unele proiecte pot necesita implementarea de clustere de mii de GPU-uri.

Fiecare cluster de inteligență artificială este o rețea mică

Atunci când se construiește un cluster de inteligență artificială, este necesar să se configureze o mică rețea de calculatoare care să se conecteze și să permită GPU-urilor să lucreze împreună și să partajeze date eficient.

Figura de mai sus ilustrează un cluster AI unde cercurile din partea de jos reprezintă fluxurile de lucru care rulează pe GPU-uri. GPU-urile se conectează la switch-urile top-of-rack (ToR). Switch-urile ToR se conectează, de asemenea, la switch-urile backbone ale rețelei prezentate deasupra diagramei, demonstrând ierarhia clară a rețelei necesară atunci când sunt implicate mai multe GPU-uri.

Rețelele reprezintă un blocaj în implementarea inteligenței artificiale

Toamna trecută, la Summitul Global Open Computer Project (OCP), unde delegații lucrau la construirea următoarei generații de infrastructură de inteligență artificială, delegatul Loi Nguyen de la Marvell Technology a subliniat un aspect cheie: „rețelele reprezintă noul blocaj”.

Din punct de vedere tehnic, latența ridicată a pachetelor sau pierderea de pachete din cauza congestiei rețelei poate duce la retrimiterea acestora, crescând semnificativ timpul de finalizare a lucrărilor (JCT). Drept urmare, companiile irosesc GPU-uri în valoare de milioane sau zeci de milioane de dolari din cauza sistemelor de inteligență artificială ineficiente, ceea ce le costă atât venituri, cât și timpul de lansare pe piață.

Măsurarea este o condiție cheie pentru funcționarea cu succes a rețelelor de inteligență artificială

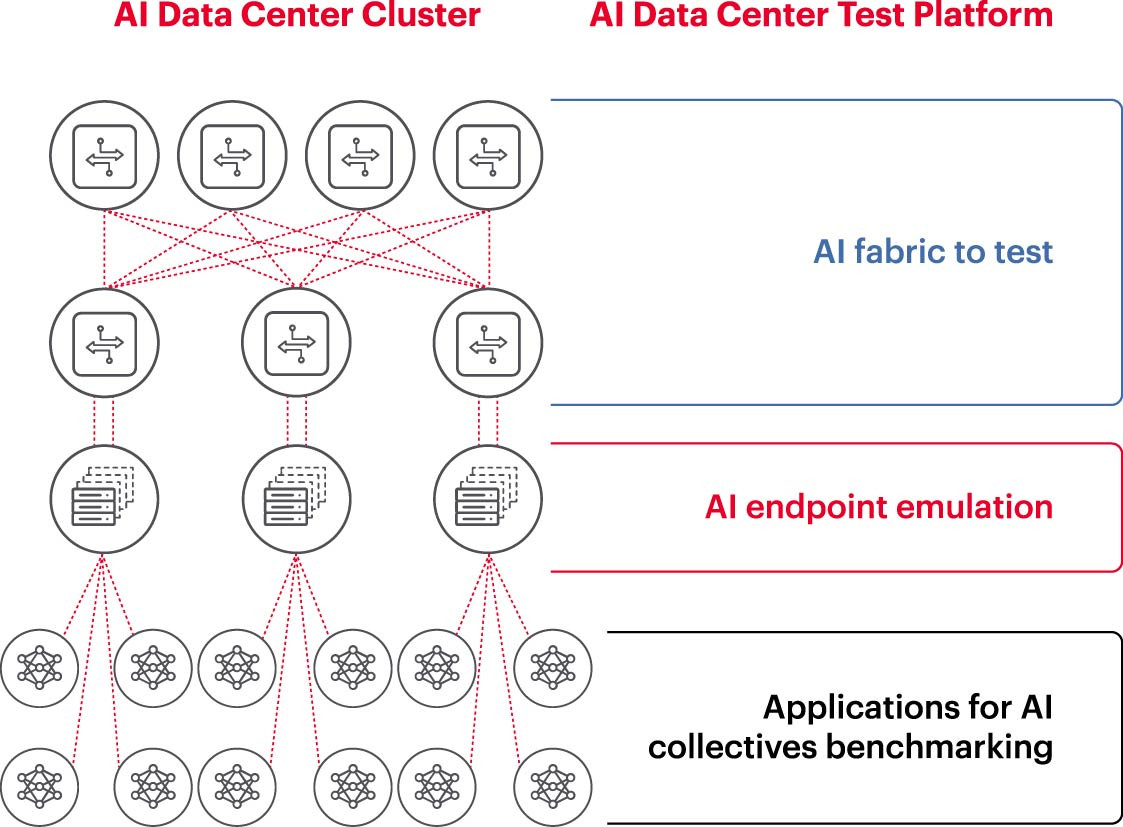

Pentru a rula eficient un cluster de inteligență artificială, GPU-urile trebuie să poată fi utilizate pe deplin pentru a scurta timpul de antrenament și a pune în funcțiune modelul de învățare pentru a maximiza rentabilitatea investiției. Prin urmare, este necesar să se testeze și să se evalueze performanța clusterului de inteligență artificială (Figura 2). Cu toate acestea, această sarcină nu este ușoară, deoarece, în ceea ce privește arhitectura sistemului, există numeroase setări și relații între GPU-uri și structurile de rețea care trebuie să se completeze reciproc pentru a rezolva problema.

Acest lucru creează numeroase provocări în măsurarea rețelelor de inteligență artificială:

- Dificultatea reproducerii unor rețele de producție complete în laborator din cauza limitărilor de cost, echipamente, lipsei de ingineri de inteligență artificială calificați în rețea, spațiului, energiei și temperaturii.

Măsurarea efectuată pe sistemul de producție reduce capacitatea de procesare disponibilă a sistemului de producție în sine.

- Dificultate în reproducerea cu acuratețe a problemelor din cauza diferențelor de scară și domeniu de aplicare al acestora.

- Complexitatea modului în care GPU-urile sunt conectate colectiv.

Pentru a aborda aceste provocări, companiile pot testa un subset al configurărilor recomandate într-un mediu de laborator pentru a evalua valori cheie, cum ar fi timpul de finalizare a lucrărilor (JCT), lățimea de bandă pe care o poate atinge echipa de inteligență artificială și pentru a compara aceste valori cu utilizarea platformelor de comutare și utilizarea memoriei cache. Această evaluare ajută la găsirea echilibrului potrivit între volumul de lucru GPU/procesare și proiectarea/configurarea rețelei. Odată mulțumiți de rezultate, arhitecții de calculatoare și inginerii de rețea pot lua aceste configurări în producție și pot măsura noile rezultate.

Laboratoarele de cercetare corporative, instituțiile academice și universitățile lucrează pentru a analiza fiecare aspect al construirii și operării unor rețele eficiente de inteligență artificială pentru a aborda provocările legate de lucrul cu rețele mari, mai ales pe măsură ce cele mai bune practici continuă să evolueze. Această abordare colaborativă și repetabilă este singura modalitate prin care companiile pot efectua măsurători repetabile și pot testa rapid scenarii ipotetice care stau la baza optimizării rețelelor pentru inteligență artificială.

(Sursa: Keysight Technologies)

Sursă: https://vietnamnet.vn/ket-noi-mang-ai-5-dieu-can-biet-2321288.html

![[Foto] Prim-ministrul Pham Minh Chinh primește delegația Semiconductor Manufacturing International (SEMI)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/06/1762434628831_dsc-0219-jpg.webp)

![[Foto] Hanoi: Locuitorii din Long Bien înfruntă ploaia pentru a merge la serviciu și la școală, în mijlocul ambuteiajelor cauzate de închiderea podurilor încă de dimineață.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/07/1762485038077_dji-0206-1506-jpg.webp)

Comentariu (0)