На самом деле, учёные уже не в первый раз предупреждают о перспективе превращения искусственного интеллекта в опасность для человечества. В 2014 году известный британский физик-теоретик Стивен Хокинг заявил: «Всестороннее развитие искусственного интеллекта может уничтожить человечество». Он также заявил, что в ближайшие 500 лет люди будут полностью заменены искусственным интеллектом, если не будут осторожны в процессе исследования и разработки этой опасной технологии. Восемь лет назад, в июле 2015 года, более 1000 экспертов в области технологий искусственного интеллекта, включая Стивена Хокинга, Илона Маска, Ноама Хомского... подписали петицию, предупреждающую о риске гонки вооружений в области военного ИИ и призывающую к полному запрету автономного оружия. Запуск OpenAI Chat GPT в ноябре 2022 года добавил ещё один тревожный звоночек к экзистенциальным угрозам искусственного интеллекта. Фактически, то, что делает Chat GPT, показывает, что ИИ, в определённой степени, гораздо опаснее, чем люди когда-то считали.

Потенциальные риски искусственного интеллекта зависят от того, как он используется. Изначально ИИ разрабатывался для помощи людям в их работе, особенно в выполнении скучных и повторяющихся задач, таких как классификация изображений, анализ информации и т. д. Однако в связи с быстрым развитием ИИ в последнее время учёные и специалисты по технологиям обеспокоены тем, что, если его разрабатывать неконтролируемо или запрограммировать для ненадлежащих целей, искусственный интеллект может привести к серьёзным последствиям для людей и общества.

Риск отсутствия безопасности

Искусственный интеллект может представлять угрозу национальной безопасности и личной безопасности. Илон Маск предупредил, что ИИ может стать грозным инструментом войны. Если страна сможет разработать мощную систему искусственного интеллекта, она сможет использовать её для нападения на другие страны. Стюарт Рассел, профессор компьютерных наук Калифорнийского университета, десятилетиями изучал искусственный интеллект. Предупреждая об угрозе безопасности, исходящей от ИИ, он заявил, что теперь мы можем производить автономное оружие нападения, интегрируя и миниатюризируя существующие технологии.

Эксперимент был проведён профессором Стюартом Расселом и Институтом будущего жизни (FLI) с использованием робота-убийцы (slaughterbot) – микроскопического летательного аппарата, оснащённого камерами, датчиками, программным обеспечением для обработки изображений, системой распознавания лиц, 3-граммовой взрывчаткой и высокоскоростным микропроцессором, что позволяет анализировать данные и реагировать в 100 раз быстрее человеческого мозга. Согласно заданным параметрам, робот-убийца непрерывно обращается к облачным данным для поиска информации о цели и поиска способа приблизиться к ней. Обнаружив цель, он на высокой скорости устремляется к ней, активирует 3-граммовую взрывчатку и глубоко просверливает череп, убивая жертву в мгновение ока.

Это всего лишь эксперимент с ИИ на самом базовом уровне. Использование ИИ для разработки новых, более сложных методов атак может также расширить возможности злоумышленников и привести к более серьёзным последствиям, чем при обычных атаках. Когда ИИ будет развит до уровня, позволяющего ему самостоятельно принимать решения об изменении окружающей среды, находить альтернативные цели или расширять диапазон целей, человечество, возможно, перестанет быть в безопасности. Многие коллеги в этой области согласны с профессором Стюартом Расселом и считают, что шанс предотвратить столь мрачное будущее всё ещё есть, но у нас осталось не так много времени.

Риск того, что ИИ станет организованным, автономным и будет контролировать систему

ИИ может быть неправильно спроектирован или неправильно «обучен» посредством машинного обучения и может выполнять нежелательные действия, нанося ущерб людям и окружающей среде. Конкретные примеры приведены ниже: С машинным обучением ИИ становится все более интеллектуальным. Когда искусственный интеллект достигает уровня интеллекта, который выходит за рамки поддержки важных систем, таких как электроснабжение, транспорт, здравоохранение , финансы и т. д., он может овладеть и контролировать все эти системы, а также принимать и выполнять решения в чрезвычайных ситуациях. Когда ИИ «оснащен» дополнительными «амбициозными» целями (неправильно спроектирован), это может вызвать множество серьезных последствий, таких как нарушение системы дорожного движения путем отключения системы светофора или отключения питания системы управления городскими поездами, вызывая серию аварий, вызывая масштабные отключения электроэнергии и т. д.

По этому сценарию снято множество голливудских и других фильмов. Однако с современными технологиями искусственного интеллекта это уже не отдалённая перспектива, а вполне может стать реальностью. Илон Маск считает, что если ИИ будет развиваться бесконтрольно, до такой степени, что он сможет автоматизировать принятие решений без вмешательства человека, это может стать угрозой для выживания человечества. Именно поэтому он и тысячи технологических экспертов подписали письмо с просьбой о временной приостановке и строгом контроле процесса разработки ИИ в условиях прозрачности. По словам Илона Маска, системы искусственного интеллекта очень сложны, трудны для понимания, и управлять ими крайне сложно. Без прозрачности использование искусственного интеллекта в неэтичных целях, наносящих вред человеку, неизбежно.

Риск потери работы, нарушения конфиденциальности

При использовании для сбора персональных данных технологии искусственного интеллекта могут использоваться для нарушения конфиденциальности, проведения дезинформационной деятельности и распространения ложной информации, влияющей на социальную и политическую стабильность. Инцидент с хакерской атакой на сетевую систему Управления кадров США (OPM) примечателен для любой страны или организации, когда в руки хакеров попали подробные и крайне конфиденциальные персональные данные 21,5 миллионов действующих и вышедших на пенсию американских чиновников, информация об их супругах, данные о людях, подавших заявления на государственные должности, такие как состояние здоровья, место жительства, работа, отпечатки пальцев и финансовая информация. Однако есть и ещё более пугающая реальность, когда ЦРУ обнаружило, что похититель данных OPM использовал технологии искусственного интеллекта для сканирования, подделки персональных данных и создания виртуальных шпионов для кражи данных. Украденная информация будет проанализирована, классифицирована и использована с помощью технологии Bigdata в определённых целях. Технологии искусственного интеллекта помогают вору информации сократить время получения информации, поскольку люди не способны обработать такой огромный объём информации за столь короткое время.

В дополнение к вышеупомянутым существующим опасностям, технология ИИ также создает другие риски, такие как: Чрезмерная зависимость от нее, приводящая к потере контроля над ситуацией и снижению способности принимать решения. Искусственный интеллект также приведет к тому, что миллионы, даже сотни миллионов людей потеряют работу, особенно в сфере чисто ручного труда с небольшим содержанием знаний. В результате серьезные социальные проблемы, такие как безработица, преступность, разрыв между богатыми и бедными ... станут глубже. Кроме того, надежность также является проблемой, которую необходимо упомянуть. Надежность решений в узкоспециализированных областях, таких как медицина, уголовное право ... чрезвычайно важна. При использовании ИИ для принятия решений в тех областях, где технология недостаточно надежна, работает на основе данных, которые имеют тенденцию благоприятствовать одному или группе людей или намеренно искажены, эти решения, вероятно, повлекут за собой серьезные последствия.

Как предотвратить?

Вышеуказанные риски стали причиной обеспокоенности Илона Маска и технологических экспертов неконтролируемым развитием ИИ и обращения к ООН с призывом строго контролировать, обеспечивать безопасность и соблюдение этических норм в разработке ИИ; укреплять международное сотрудничество для обеспечения пользы использования технологий ИИ для человека и общества. Можно выделить следующие конкретные меры:

- Контроль надежности системы: ИИ необходимо проектировать и разрабатывать так, чтобы гарантировать безопасность и надежность посредством строгих, регулярных и непрерывных методов тестирования, контроля и мониторинга качества, чтобы гарантировать, что система ИИ работает в соответствии с человеческими ожиданиями и избегает нежелательных последствий из-за ее недостаточной надежности.

Технологии искусственного интеллекта должны быть запрограммированы на работу в соответствии с этическими ценностями и социальными нормами. Эти правила и стандарты должны быть четко установлены и должны контролироваться, чтобы гарантировать, что они не причиняют вреда людям или организациям. Необходимо также регулярно проводить анализ, оценку воздействия и мониторинг работы систем искусственного интеллекта, чтобы гарантировать их корректную работу, не нарушать и не подрывать общие ценности всего общества, не оказывать негативного воздействия и обеспечивать передачу правильных знаний и ценностей.

– Приостановка «обучения» систем ИИ как минимум на шесть месяцев для полной переоценки. Эта пауза должна быть публичной, контролируемой, и в ней должны участвовать все ключевые участники обучения. При необходимости правительствам следует ввести временный мораторий. Это не означает полную остановку разработки ИИ, а лишь паузу в опасной гонке за другими моделями развития, делая системы ИИ более точными, безопасными, понятными, прозрачными, последовательными, заслуживающими доверия и лояльными. Это комплексное решение, к которому Илон Маск и его коллеги призывают в своём открытом письме, но оно не очень осуществимо. Всем независимым лабораториям очень сложно выполнить этот необязательный и межнациональный призыв.

- Укреплять сотрудничество и обмен информацией между странами и независимыми исследовательскими организациями в области ИИ для обеспечения безопасной разработки и использования ИИ в будущем. Сотрудничество и обмен информацией также являются мерами по оперативному предупреждению и предотвращению любых рисков, которые могут возникнуть в будущем.

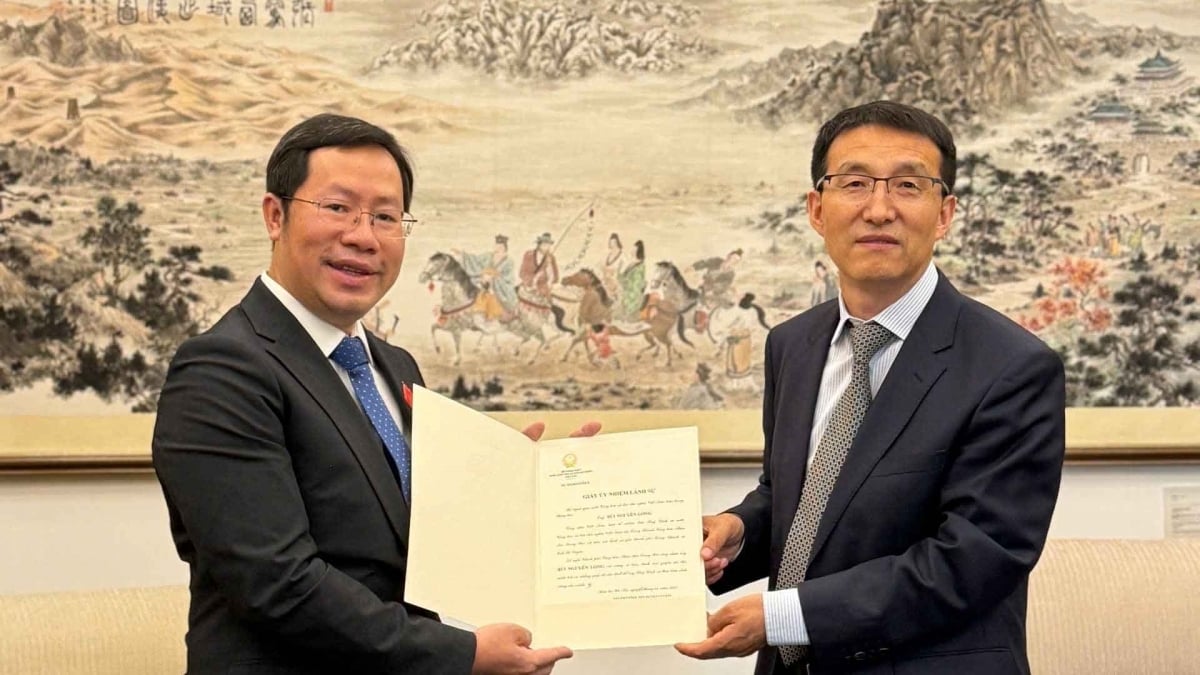

В целом, ИИ присутствует повсюду вокруг нас, и такие истории, как написание стихов, музыки, статей искусственным интеллектом , стали реальностью и больше не выдумкой. Автор этой статьи сам использовал технологии искусственного интеллекта на компьютерах и телефонах, чтобы сделать свой процесс написания более удобным и быстрым. В частности, глава этой статьи и некоторые идеи, а также все фотографии, использованные в этой статье, созданы ИИ. Технологии искусственного интеллекта очень полезны для повышения качества работы и жизни человека, но их необходимо строго контролировать, чтобы они не вышли из-под контроля и не стали риском замены людей в будущем, как предсказывал физик-теоретик Стивен Хокинг.

Статья и фотографии: HUU DUONGИсточник

![[Инфографика] В 2025 году 47 продуктов получат национальный сертификат OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/5d672398b0744db3ab920e05db8e5b7d)

Комментарий (0)