Enligt delegaten Dong Ngoc Ba kommer utfärdandet av lagen om artificiell intelligens (AI) att bidra till att skapa en enhetlig och synkron rättslig grund, både för att främja utveckling och säkerställa effektiv riskhantering inom forskning, utveckling och användning av AI, för att uppfylla kraven för socioekonomisk utveckling i den digitala tidsåldern.

Delegaten sade att den lagstiftande myndigheten har varit mycket aktiv och ansvarsfull, studerat och tagit till sig många åsikter från den granskande myndigheten och relevanta myndigheter för att färdigställa lagförslaget. Delegaten uppskattade mycket av innehållet som har tagits upp och reviderats i det nya utkastet.

Samtidigt rekommenderas att fortsätta granska och justera, särskilt för att säkerställa konsekvens och synkronisering med relaterade lagar såsom civillagen, lagen om produkt- och varukvalitet, lagen om immaterialrätt, lagen om högteknologi och lagen om standarder och tekniska föreskrifter; samt att säkerställa nytt lagstiftningstänkande och lagstiftningstekniker.

Dessutom lämnade vicepresident Dong Ngoc Ba även några specifika rekommendationer.

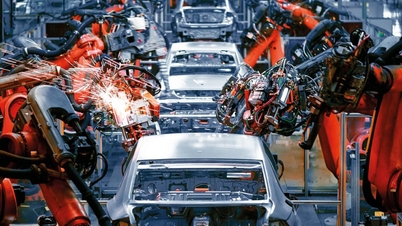

Lagförslaget om artificiell intelligens (artiklarna 7–11) föreskriver klassificering av riskhantering för AI-system i fyra nivåer: låg risk, medelhög risk, hög risk och oacceptabel risk.

Ledamot Ba sade att med tanke på AI:s natur, om AI-systemet betraktas som en typ av produkt eller vara, är bestämmelserna i lagförslaget orimliga och inkonsekventa, och inte förenliga med bestämmelserna i lagen om produkt- och varukvalitet (som delar upp produkter och varor i tre grupper: låg risk, medelhög risk och hög risk).

Därför rekommenderas det att den utarbetande myndigheten noggrant undersöker och klassificerar AI-system på ett sätt som är förenligt med lagen om produkt- och varukvalitet (3 risknivåer) för att underlätta implementeringen.

”När det gäller ett AI-system med ” oacceptabel risk” bör detta betraktas som en förbjuden aktivitet och bör specifikt regleras som ett förbud i lagförslaget. Det är nödvändigt att lägga till andra förbjudna handlingar inom forskning, utveckling och användning av AI (till exempel: att använda AI för att kränka nationell säkerhet, att använda AI för att diskriminera baserat på biometriska data etc.) för att säkerställa fullständighet och strikthet” – föreslog ledamot Ba.

Beträffande ansvaret för ersättning för skador orsakade av AI-system, föreskrivs i artikel 30 punkt a, klausul 3, i utkastet till lag om artificiell intelligens: ”För AI-system med hög risk: Vid skada som uppstår till följd av överträdelser i hanteringen och användningen av AI-system, måste den organisation eller individ som gjort överträdelsen ersätta skadan i enlighet med bestämmelserna i civilrätten.”

Enligt paragraf 1, artikel 601 i civillagen omfattar källor till extrem fara motorfordon, kraftöverföringssystem, industrianläggningar i drift, vapen, sprängämnen, brandfarliga ämnen, giftiga ämnen, radioaktiva ämnen, vilda djur och andra källor till extrem fara enligt lag.

Enligt vicepresident Dong Ngoc Ba skiljer civillagen mellan ersättning för skada orsakad av en källa till hög fara och andra fall, särskilt vad gäller vållandefaktorn vid fastställandet av ersättningsskyldighet. Med bestämmelserna i lagförslaget om artificiell intelligens i punkt a, klausul 3, artikel 30 ovan är det oklart huruvida ett "högrisk-AI-system" är en "källa till hög fara" eller inte. Samtidigt har ett högrisk-AI-system, vad gäller teknisk och teknologisk natur, karaktären av en källa till hög fara.

Därför föreslog delegaten att man skulle studera och revidera bestämmelserna i punkt a, klausul 3, artikel 30 i utkastet till lag om artificiell intelligens i riktning mot att definiera AI-system med hög risk som källor till extrem fara, i syfte att ha en grund för att tillämpa bestämmelser om ersättningsansvar för skador orsakade av AI-system i enlighet med bestämmelserna i civillagen.

Angående innovation i tänkande och lagstiftningstekniker föreslog parlamentsledamot Ba en översyn för att säkerställa att lagen om artificiell intelligens inte reglerar frågor som faller under regeringens befogenhet. Mer specifikt, i kapitel VI (inspektion, granskning och hantering av överträdelser), överväg att inte reglera specialiserade inspektioner utan låta regeringen reglera dem i enlighet med sin befogenhet. Se över kapitel VII (statlig förvaltning av AI), ta bort bestämmelser som faller under regeringens befogenhet, såsom ministeriernas statliga förvaltningsansvar... Föreslå att kapitel VI slås samman med kapitel VII, eftersom inspektion, granskning och hantering av överträdelser i huvudsak är specifikt innehåll i den statliga förvaltningen av AI.

Biträdande chef för nationalförsamlingens delegation i Gia Lai-provinsen, Siu Huong, uttryckte intresse för bestämmelserna om etik och ansvar i AI-verksamhet i kapitel 5.

Enligt delegaten Huong tränas många AI-modeller för närvarande genom att samla in data, konstverk och kreativt innehåll från internet utan upphovsmannens samtycke, och det finns ingen mekanism för att kompensera upphovsmannen. Detta utgör en potentiell risk för intrång i innehållsskaparnas immateriella rättigheter.

Därför föreslog delegaten att den utarbetande myndigheten skulle överväga att lägga till en bestämmelse i kapitel 5 om att utvecklare av AI-system måste ha en tydlig tillståndsmekanism, som gör det möjligt för innehållsägare att välja att samtycka till eller vägra att använda deras verk för AI-utbildningsändamål. Samtidigt bör forskningen bygga upp en mekanism för kompensation eller fördelning av nytta för författare när deras verk används i AI-modellutbildning.

Ledamot Nguyen Van Canh (medlem av nationalförsamlingens delegation från Gia Lai-provinsen) deltog i diskussionen och tog upp frågan ur ett perspektiv som en konsument berörs av användningen av "AI"-produkter. Om det inträffar en incident utanför kontroll som orsakar skada, vem som kommer att vara ansvarig för ersättning.

Enligt ledamot Canh förklarar inte lagförslaget om artificiell intelligens termen ”produkter som använder AI-teknik”. Konsumenter känner bara till produkten, men bara forskare och vetenskapsmän vet vad AI-teknik är.

Ledamot Canh föreslog att AI tydligt skulle skiljas åt som en insatsprodukt, ett verktyg, en halvfabrikat eller en färdig produkt. Därifrån kommer det att finnas specifika regler om leverantörens ansvar.

”Till exempel är AI bara integrerad i produkten. När skada uppstår måste säljaren av den produkten ta fullt ansvar och kan inte skylla det på AI, eftersom företaget som tillverkar AI säljer den till mig, jag har ingen kontroll över det” - analyserade biträdande vicepresident Canh.

Källa: https://baogialai.com.vn/viec-ban-hanh-luat-tri-tue-nhan-tao-la-van-de-cap-bach-post573129.html

Kommentar (0)