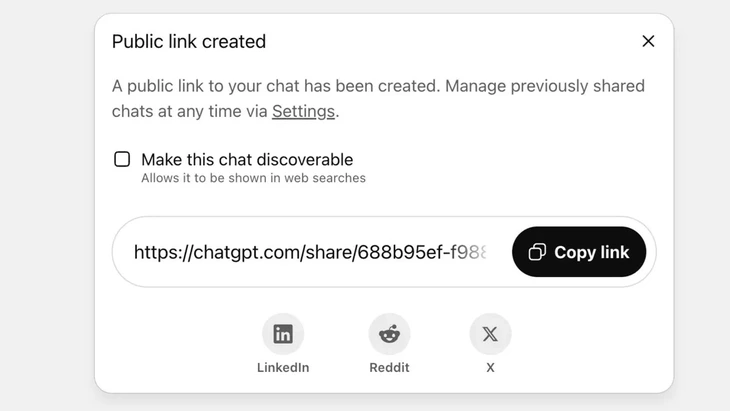

ฟีเจอร์แชร์แชทผ่านลิงก์สาธารณะบน ChatGPT - รูปภาพ: Techradar

ปัจจุบัน ChatGPT มีผู้ถูกค้นหามากกว่า 2.5 พันล้านครั้งจากผู้ใช้ทั่วโลกทุกวัน แสดงให้เห็นถึงความนิยมที่เพิ่มมากขึ้นของแชทบอทตัวนี้

อย่างไรก็ตาม เครื่องมือนี้กำลังเผชิญกับการตอบโต้อย่างรุนแรงจากผู้ใช้ เนื่องจากคุณลักษณะ "การแชร์" ทำให้การสนทนาหลายพันครั้งรั่วไหลข้อมูลที่ละเอียดอ่อนไปยัง Google และเครื่องมือค้นหาบางตัวบนอินเทอร์เน็ต

ความเสี่ยงด้านความปลอดภัยสูง

นายหวู่ หง็อก เซิน หัวหน้าแผนกเทคโนโลยีของสมาคมความปลอดภัยทางไซเบอร์แห่งชาติ (NCA) ประเมินว่าเหตุการณ์ดังกล่าวแสดงให้เห็นถึงความเสี่ยงด้านความปลอดภัยในระดับสูงสำหรับผู้ใช้ ChatGPT

“เหตุการณ์ข้างต้นไม่จำเป็นต้องเป็นข้อบกพร่องทางเทคนิคเสมอไป เพราะผู้ใช้มีความคิดริเริ่มบางอย่างในการคลิกปุ่มแชร์ อย่างไรก็ตาม อาจกล่าวได้ว่าปัญหาอยู่ที่การออกแบบผลิตภัณฑ์แชทบอท AI ซึ่งสร้างความสับสนให้กับผู้ใช้ และไม่มีมาตรการเตือนที่เข้มแข็งเพียงพอเกี่ยวกับความเสี่ยงที่ข้อมูลส่วนบุคคลจะรั่วไหลหากผู้ใช้แชร์” คุณหวู หง็อก เซิน วิเคราะห์

ใน ChatGPT ฟีเจอร์นี้จะนำมาใช้หลังจากที่ผู้ใช้เลือกที่จะแชร์การแชทผ่านลิงก์สาธารณะ เนื้อหาจะถูกเก็บไว้บนเซิร์ฟเวอร์ของ OpenAI ในรูปแบบเว็บไซต์สาธารณะ (chatgpt.com/share/...) ไม่จำเป็นต้องเข้าสู่ระบบหรือใช้รหัสผ่านเพื่อเข้าถึง

โปรแกรมรวบรวมข้อมูลของ Google จะสแกนและสร้างดัชนีหน้าเหล่านี้โดยอัตโนมัติ ทำให้ปรากฏในผลการค้นหา รวมถึงข้อความที่ละเอียดอ่อน รูปภาพ หรือข้อมูลการแชท

ผู้ใช้จำนวนมากไม่ทราบถึงความเสี่ยงนี้ โดยคิดว่ากำลังแชร์แชทกับเพื่อนหรือผู้ติดต่อ ส่งผลให้บทสนทนาหลายพันบทสนทนาถูกเปิดเผย ซึ่งในบางกรณีมีข้อมูลส่วนบุคคลที่ละเอียดอ่อน

แม้ว่า OpenAI จะลบฟีเจอร์นี้ออกไปอย่างรวดเร็วในช่วงปลายเดือนกรกฎาคม 2568 หลังจากถูกวิพากษ์วิจารณ์จากชุมชน แต่ก็ยังต้องใช้เวลาในการประสานงานกับ Google เพื่อลบดัชนีเก่าออกไป โดยเฉพาะอย่างยิ่งเมื่อระบบจัดเก็บข้อมูลที่ซับซ้อน ซึ่งรวมถึงเซิร์ฟเวอร์แคชของ Google ทำให้การดำเนินการนี้ไม่สามารถดำเนินการได้อย่างรวดเร็ว

อย่าปฏิบัติต่อแชทบอท AI เหมือนกับเป็น "กล่องดำด้านความปลอดภัย"

ผู้เชี่ยวชาญด้านความปลอดภัยข้อมูล Vu Ngoc Son หัวหน้าฝ่ายเทคโนโลยีของสมาคมความปลอดภัยทางไซเบอร์แห่งชาติ (NCA) - ภาพ: CHI HIEU

การรั่วไหลของบันทึกการแชทนับพันรายการอาจก่อให้เกิดความเสี่ยงต่อผู้ใช้ เช่น การเปิดเผยความลับส่วนตัวและทางธุรกิจ ความเสียหายต่อชื่อเสียง ความเสี่ยงทางการเงิน หรือกระทั่งอันตรายต่อความปลอดภัยอันเนื่องมาจากการเปิดเผยที่อยู่บ้าน

แชทบอทที่ใช้ AI นั้นมีประโยชน์แต่ก็ไม่ใช่ 'กล่องดำ' เนื่องจากข้อมูลที่แชร์กันสามารถคงอยู่ตลอดไปบนเว็บได้หากไม่ได้รับการตรวจสอบ

เหตุการณ์ข้างต้นถือเป็นบทเรียนสำหรับทั้งผู้ให้บริการและผู้ใช้ ผู้ให้บริการ AI รายอื่นสามารถเรียนรู้จากประสบการณ์นี้และออกแบบฟีเจอร์ต่างๆ ให้มีคำเตือนที่ชัดเจนและโปร่งใสมากขึ้น

ในขณะเดียวกัน ผู้ใช้ยังต้องจำกัดการโพสต์ข้อมูลระบุตัวตนหรือข้อมูลส่วนบุคคลที่ไม่ได้รับอนุญาตบนแพลตฟอร์ม AI อย่างจริงจังด้วย" Vu Ngoc Son ผู้เชี่ยวชาญด้านความปลอดภัยแนะนำ

ผู้เชี่ยวชาญด้านความปลอดภัยข้อมูลระบุว่า เหตุการณ์ดังกล่าวแสดงให้เห็นถึงความจำเป็นในการมีช่องทางทางกฎหมายและมาตรฐานความปลอดภัยทางไซเบอร์สำหรับ AI ซัพพลายเออร์และนักพัฒนา AI จำเป็นต้องออกแบบระบบที่รับประกันความปลอดภัย หลีกเลี่ยงความเสี่ยงจากการรั่วไหลของข้อมูล เช่น การรั่วไหลผ่านช่องโหว่ที่เป็นอันตราย ช่องโหว่ของซอฟต์แวร์ที่นำไปสู่การโจมตีฐานข้อมูล การควบคุมที่ไม่ดีซึ่งนำไปสู่การโจมตีทางไซเบอร์ และการใช้ในทางที่ผิดเพื่อตอบคำถามเท็จและบิดเบือน

ผู้ใช้ยังต้องควบคุมการแบ่งปันข้อมูลส่วนบุคคลกับ AI โดยไม่แบ่งปันข้อมูลที่ละเอียดอ่อน หากจำเป็นจริงๆ ควรใช้โหมดไม่ระบุตัวตนหรือเข้ารหัสข้อมูลอย่างจริงจัง เพื่อหลีกเลี่ยงการเชื่อมโยงข้อมูลโดยตรงกับบุคคลใดบุคคลหนึ่ง

ที่มา: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[ภาพ] ตัดเนินเขาเพื่อเปิดทางให้คนสัญจรบนเส้นทาง 14E ที่เกิดดินถล่ม](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762599969318_ndo_br_thiet-ke-chua-co-ten-2025-11-08t154639923-png.webp)

![[วิดีโอ] อนุสาวรีย์เมืองเว้เปิดต้อนรับนักท่องเที่ยวอีกครั้ง](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

การแสดงความคิดเห็น (0)