ہر زاویے سے حملہ۔

گوگل نے "جیمنی نینو کیلے" کے نام سے ایک نئی مصنوعی ذہانت (AI) پروڈکٹ لانچ کی ہے، جو کہ لکھنے اور استدلال کرنے کے قابل ایک بڑے پیمانے پر لسانی AI (LLM) نہیں ہے، بلکہ تصویر میں ترمیم کرنے میں مہارت رکھنے والا AI ہے... بہت سے صارفین اس ٹول کے بارے میں پرجوش ہیں، لیکن یہ اپنے ساتھ کئی خرابیاں بھی لاتا ہے۔

Conductify AI کے چیف سائنٹیفک آفیسر Nguyen Hong Phuc نے اپنی ذاتی رائے کا اظہار کرتے ہوئے کہا، "یہ AI ٹیکنالوجی اور اخلاقی حدود میں ایک قدم پیچھے ہٹنے کی طرح ہے۔" "جیمنی نینو کیلے میں امیج ایڈیٹنگ کی موثر صلاحیتیں ہیں۔ لیکن گوگل کی جانب سے جیمنی نینو کیلے کو سینسر کرنے سے، رکاوٹوں کو کم کرنا اور میکانزم کو محدود کرنا، اس AI کو ایسی تصاویر بنانے کی اجازت دیتا ہے جو کہ مشہور شخصیات، تجویز کردہ تصاویر، حساس تصاویر وغیرہ سے ناقابل یقین حد تک ملتی جلتی ہیں،" Phuc نے کہا۔

مسٹر Nguyen Hong Phuc کے مطابق، یہ صلاحیت جیمنی نانو کیلے کو حقیقت پسندانہ جعلی تصاویر بنانے کا ایک ٹول بناتی ہے، یہاں تک کہ AI ماہرین بھی ان میں فرق نہیں کر سکتے، جس سے دھوکہ دہی اور سائبر سیکیورٹی کے نئے خطرات پیدا ہوتے ہیں، جیسے کہ جھوٹی معلومات پھیلانے کے لیے مشہور سیاستدانوں کے ساتھ جعلی تصاویر بنانا، اور یہاں تک کہ افراد کو سوشل میڈیا پر AI-generation اور AI-generation کی تصویروں کا نشانہ بنایا جاتا ہے۔

مزید برآں، درجنوں دیگر AI فوٹو ایڈیٹنگ ٹولز نے انٹرنیٹ پر طوفان برپا کر رکھا ہے، ڈیپ فیک گھوٹالے رکنے کے کوئی آثار نہیں دکھاتے ہیں۔ سیکیورٹی اداروں کے اعداد و شمار بتاتے ہیں کہ ڈیپ فیک ٹیکنالوجی اعلیٰ قدر والے افراد، خاص طور پر کاروباری رہنماؤں کو نشانہ بنانے والی فشنگ مہمات تخلیق کرتی ہے۔ 2024 میں، عالمی سطح پر 140,000-150,000 کیسز تھے، جن میں 75% سی ای اوز اور سینئر ایگزیکٹوز کو نشانہ بنایا گیا... ڈیپ فیکس 2027 تک عالمی اقتصادی نقصانات میں 32%، تقریباً 40 بلین ڈالر سالانہ تک اضافہ کر سکتا ہے۔

حال ہی میں، AI کمپنی Anthropic نے غیر ملکی ہیکرز کی جانب سے کی جانے والی سائبر اٹیک مہم کا پتہ لگا کر اسے ناکام بنا دیا، جس نے پہلی بار خودکار حملے کی سرگرمیوں کو مربوط کرنے کے لیے AI کے استعمال کو ریکارڈ کیا۔ خاص طور پر، ہیکرز نے دخل اندازی کی کارروائیوں کی منصوبہ بندی، براہ راست، اور تعیناتی کے لیے AI سسٹمز کا استعمال کیا – ایک "پریشان کن" ترقی جس سے سائبر حملے کی مہموں کے پیمانے اور رفتار کو بڑھانے کا خطرہ ہے…

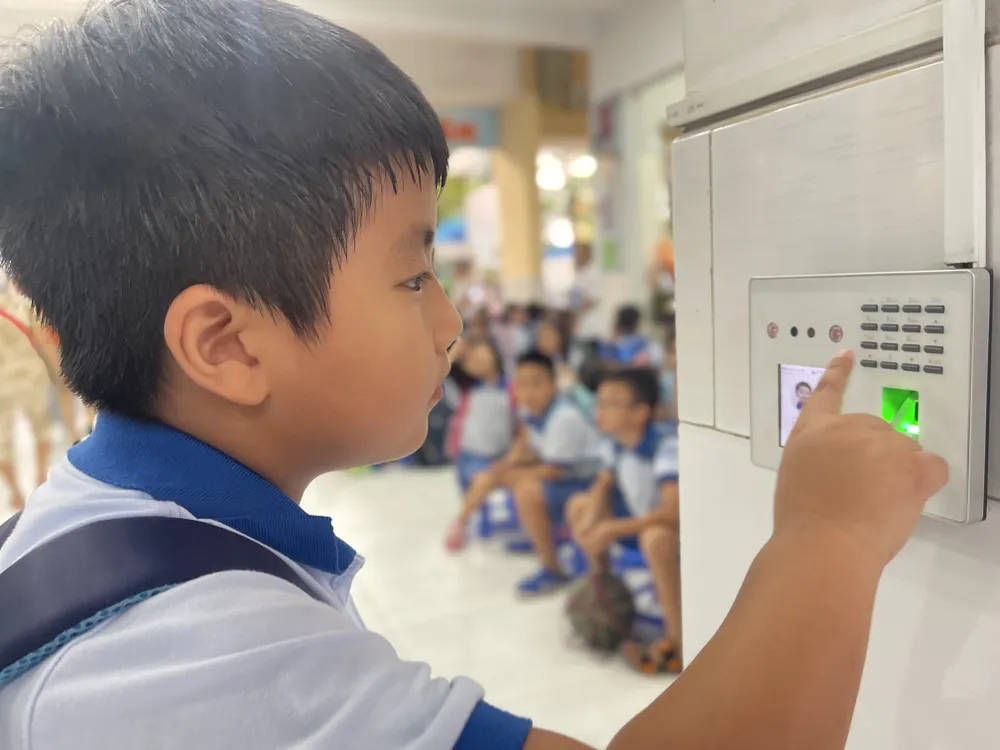

نیشنل سائبرسیکیوریٹی ایسوسی ایشن کے اینٹی فراڈ آرگنائزیشن کے ڈائریکٹر مسٹر اینگو من ہیو نے شیئر کیا کہ AI سے مربوط ٹولز دھوکہ دہی کی رفتار کو حقیقی لوگوں کے استعمال کے مقابلے میں 20 گنا بڑھا دیتے ہیں۔ فراڈ کرنے والے AI کو تجزیہ کے لیے فراڈ کا منظرنامہ فراہم کرتے ہیں، اور سسٹم فوری طور پر خود بخود متاثرین کے ساتھ چیٹ کرتا ہے۔ ابتدائی اعداد و شمار سے، AI سمجھ سکتا ہے کہ شکار کیا چاہتا ہے اور حقیقی وقت میں ان کے ساتھ بات چیت کر سکتا ہے۔ سب سے نفیس حربہ "مین-ان-دی-مڈل" حملہ ہے، جہاں جب کوئی صارف ویڈیو کی تصدیق کرتا ہے (جیسے کہ اپنے چہرے کو ریکارڈ کرنا یا کمانڈ دینا) تو ہیکر منتقل شدہ ڈیٹا میں مداخلت کرنے کے لیے مداخلت کرتا ہے۔ اس کے بعد سائبر کرائمین پہلے سے تیار ڈیپ فیک ویڈیوز داخل کرتے ہیں، صارف کے اصلی ڈیٹا اسٹریم کو تبدیل کرتے ہوئے تصدیق کے عمل کو نظرانداز کرتے ہیں۔ اس طریقہ کار سے بینکوں اور مالیاتی اداروں کے سیکیورٹی سسٹم کو بھی دھوکہ دہی کا خطرہ ہے۔

بہتر ڈیٹا مینجمنٹ

جیسے جیسے AI تیزی سے پھیل رہا ہے، سیکورٹی اور رازداری کے خطرات بھی نمایاں طور پر بڑھ رہے ہیں۔ ریموٹ سرورز پر ذخیرہ شدہ اور پراسیس شدہ ڈیٹا ہیکرز اور سائبر کرائمینلز کے لیے ایک پرکشش ہدف بن جائے گا۔ نیشنل سائبر سیکیورٹی ایسوسی ایشن کے اعداد و شمار کے مطابق، صرف 2025 کی دوسری سہ ماہی میں، AI سے چلنے والے سائبر حملوں کی تعداد میں 62 فیصد اضافہ ہوا، جس سے عالمی سطح پر 18 ارب ڈالر تک کا نقصان ہوا...

ماہرین کا خیال ہے کہ ڈیٹا کی حفاظت بہت ضروری ہے۔ تاہم، بہت سے "بلیک مارکیٹ" پلیٹ فارمز پر ڈیٹا کی جمع اور فروخت کھلے عام جاری ہے، ہر ماہ $20 تک۔ سائبر جرائم پیشہ افراد ایسے اوزار استعمال کر سکتے ہیں جو زبان کے ماڈلز کی نقل کرتے ہیں لیکن مجرمانہ مقاصد کے لیے اپنی مرضی کے مطابق بنائے گئے ہیں۔ یہ ٹولز میلویئر پیدا کرنے اور اینٹی وائرس سافٹ ویئر کو نظرانداز کرنے کی صلاحیت رکھتے ہیں۔

ویتنام میں، فرمان نمبر 13/2023/ND-CP (17 اپریل 2023 سے مؤثر) ذاتی ڈیٹا کے تحفظ کو منظم کرتا ہے۔ مزید برآں، پرسنل ڈیٹا پروٹیکشن کا قانون، جس کے 1 جنوری 2026 سے نافذ ہونے کی توقع ہے، ذاتی ڈیٹا لیک ہونے اور غلط استعمال کے خطرے سے نمٹنے کے لیے ایک مضبوط قانونی طریقہ کار کھولے گا۔ تاہم، نیشنل سائبرسیکیوریٹی ایسوسی ایشن کے مطابق، نفاذ کی تاثیر کو اب بھی تین ستونوں میں مضبوط کرنے کی ضرورت ہے: عوامی بیداری میں اضافہ، کارپوریٹ ذمہ داری میں اضافہ، اور ریگولیٹری ایجنسیوں کی پروسیسنگ کی صلاحیت کو بہتر بنانا۔ تکنیکی اقدامات سے ہٹ کر، ہر فرد کو غیر معمولی اور مشکوک علامات کی نشاندہی کرنے اور خطرناک ڈیجیٹل تعاملات سے خود کو فعال طور پر بچانے کی صلاحیت پیدا کرنے کی ضرورت ہے…

کاسپرسکی نے ڈارک AI کے استحصال کے بارے میں خبردار کیا ہے (ایک اصطلاح جو بڑے لینگویج ماڈلز (LLMs) کی تعیناتی کا حوالہ دیتی ہے جو معیاری سیکیورٹی کنٹرول سے باہر کام کرتی ہے، اکثر ایسی کارروائیوں کو فعال کرتی ہے جیسے کہ فشنگ، ہیرا پھیری، سائبرٹیکس، یا ڈیٹا کا غلط استعمال)۔ تنظیموں اور افراد کو ایشیا پیسیفک خطے میں ڈارک AI کے عروج کی وجہ سے بڑھتے ہوئے جدید ترین اور مشکل سے پتہ لگانے والے سائبر حملوں کا سامنا کرنے کے لیے تیاری کرنے کی ضرورت ہے۔

کاسپرسکی میں مشرق وسطیٰ، ترکی، افریقہ، اور ایشیا پیسیفک علاقوں کے لیے گلوبل ریسرچ اینڈ اینالیسس ٹیم (GReAT) کے سربراہ سرگئی لوزکن نے اشتراک کیا کہ موجودہ AI کے غلط استعمال کا ایک مظہر بلیک ہیٹ GPT ماڈلز کا ابھرنا ہے۔ یہ AI ماڈلز ہیں جو خاص طور پر غیر اخلاقی اور غیر قانونی مقاصد کو پورا کرنے کے لیے تیار یا تبدیل کیے گئے ہیں، جیسے کہ مالویئر بنانا، بڑے پیمانے پر حملوں کے لیے روانی اور قائل کرنے والی فشنگ ای میلز تیار کرنا، گہری جعلی آوازیں اور ویڈیوز بنانا، اور یہاں تک کہ نقلی حملوں کی حمایت کرنا۔

Kaspersky ماہرین تجویز کرتے ہیں کہ افراد اور کاروبار AI سے تیار کردہ میلویئر کا پتہ لگانے کے لیے اگلی نسل کے سیکیورٹی حل استعمال کریں، جبکہ ڈیٹا کے تحفظ کو بھی ترجیح دیں۔ کاروباری اداروں کو AI سے چلنے والے خطرے کے استحصال کو ٹریک کرنے کے لیے ریئل ٹائم مانیٹرنگ ٹولز کا نفاذ کرنا چاہیے۔ ڈارک زون میں AI کو محدود کرنے اور ڈیٹا لیک ہونے کے خطرے کو محدود کرنے کے لیے رسائی کنٹرول اور ملازمین کی تربیت کو مضبوط بنانا؛ اور خطرات کی نگرانی اور واقعات کا فوری جواب دینے کے لیے سائبرسیکیوریٹی آپریشن سینٹر قائم کریں۔

ماخذ: https://www.sggp.org.vn/bao-mat-du-lieu-thoi-ai-post824210.html

![[تصویر] پتوں کے بدلتے موسم کے دوران پرنپاتی جنگل سے سحر زدہ۔](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2026%2F02%2F04%2F1770196861704_2066642_8ffd5f25c3c9433be0e644abe71613ae.jpeg&w=3840&q=75)

![[تصویر] وزیر اعظم فام من چن جنوری 2026 میں باقاعدہ حکومتی اجلاس کی صدارت کر رہے ہیں۔](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F402x226%2Fvietnam%2Fresource%2FIMAGE%2F2026%2F02%2F04%2F1770209446450_hopcp-jpg.webp&w=3840&q=75)

تبصرہ (0)