آن لائن فراڈ کرنے والے نہ صرف رشتہ داروں، پولیس افسران وغیرہ کی نقالی کرتے ہیں بلکہ مصنوعی ذہانت (AI) ٹولز سے بھی ہیرا پھیری کرتے ہیں تاکہ صارفین پر حملہ کرنے کے لیے سینکڑوں اسکام کے منظرنامے تیار کر سکیں۔

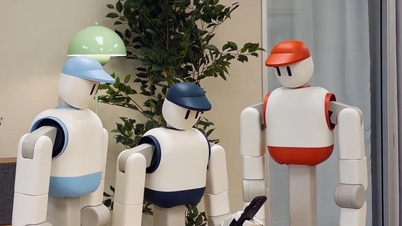

سائبرسیکیوریٹی کے ماہر Ngo Minh Hieu نے کہا کہ دھوکہ دہی کرنے والے AI میں ہیرا پھیری کرتے ہیں، منٹوں میں سینکڑوں گھوٹالے کے منظرنامے بناتے ہیں - تصویر: VU TUAN

سوشل انٹرپرائز Chongluadao.vn کے مطابق، دھوکہ بازوں نے AI کا استعمال میلویئر بنانے، اسکیم اسکرپٹ لکھنے، اور ڈیپ فیک کے ذریعے آوازوں اور تصاویر کو تبدیل کرنے کے لیے کیا ہے۔

سائبرسیکیوریٹی ماہر Ngo Minh Hieu (Hieu PC) - Chongluadao.vn کے نمائندے کے مطابق، ایک خطرناک چال یہ ہے کہ مالویئر لوڈ کرنے میں AI کو "چال" کرنا ہے۔ Hieu PC نے کہا کہ "وہ جعلی آڈیو یا امیج فائلز بناتے ہیں، میلویئر کو سرایت کرتے ہیں جسے AI نہیں پہچانتا۔ جب AI سسٹم اس پر کارروائی کرتا ہے تو میلویئر متحرک ہو جاتا ہے اور کنٹرول حاصل کر لیتا ہے،" Hieu PC نے کہا۔

مثال کے طور پر، اس نے AI کا استعمال FaceTime کے ذریعے رشتہ داروں کی جعلی آوازوں اور تصاویر کے لیے لوگوں کو پیسے کی منتقلی کے لیے دھوکہ دینے کے لیے کیا۔

حال ہی میں، اے آئی ٹولز کی مدد کی بدولت فراڈ کی فریکوئنسی میں نمایاں اضافہ ہوا ہے۔ AI کو کنٹرول کرنا، دھوکہ دہی کے لیے AI کا استعمال کرتے ہوئے، فراڈ کرنے والے تمام زبان اور جغرافیائی رکاوٹوں کو عبور کرتے ہیں۔ دھوکہ دہی کی شکلیں زیادہ نفیس اور خطرناک ہوتی جا رہی ہیں۔

پی سی کے ماہر ہیو نے تجزیہ کیا کہ اس بات سے کوئی فرق نہیں پڑتا ہے کہ دھوکہ دہی کے لیے کوئی بھی ٹول استعمال کیا جاتا ہے، سائبر مجرموں کے پاس ہمیشہ ایک منظر ہوتا ہے۔ یہ وہ معلومات ہے جو اس کے ساتھیوں کی ٹیم نے سینکڑوں آن لائن فراڈ کی رپورٹس موصول کرنے اور اس پر کارروائی کرتے وقت کھینچی ہے۔

دھوکہ دہی کی عام شکلیں رشتہ داروں کی نقالی کرنا، ریاستی ایجنسیوں، پولیس، بجلی کمپنیوں کے ملازمین کی نقالی کرنا... مزید نفیس منظرنامے ہیں جو متاثرین کو سرمایہ کاری کے جال میں پھنساتے ہیں، کام انجام دیتے ہیں یا ڈیٹنگ کرتے ہیں...

سائبر سیکیورٹی ماہرین کا کہنا ہے کہ اپنی تصویر کو جعلی ہونے سے بچانے کے لیے سب سے پہلا کام یہ ہے کہ سوشل نیٹ ورک پر اپنی ذاتی تصویر کو پبلک موڈ میں شیئر نہ کریں۔ رقم کی منتقلی، لنکس پر کلک کرنے، یا OTP کوڈ فراہم کرنے کے لیے کالز اور پیغامات 99% گھوٹالے ہیں۔

AI پر حملہ کرنے کے لیے ہیکرز کی چالیں۔

سائبرسیکیوریٹی ماہرین کے مطابق، "مخالفانہ حملہ" ایک ایسی چال ہے جسے ہیکرز AI کو "ٹرک" کرنے کے لیے استعمال کرتے ہیں۔ یہ جعلی معلومات کی ایک شکل ہے جو AI کو غلط فہمی میں مبتلا کرتی ہے یا اس کا استحصال کیا جاتا ہے۔ نتیجے کے طور پر، AI نظام میں بدنیتی پر مبنی کوڈ داخل کرتا ہے یا جعلساز کی طرف سے دیے گئے احکامات پر عمل کرتا ہے۔

دھوکہ باز اس کمزوری کا فائدہ اٹھاتے ہوئے AI، خاص طور پر AI پروٹیکشن سسٹمز (جیسے اینٹی وائرس سافٹ ویئر، آواز کی شناخت، یا بینک ٹرانزیکشن چیک) کو نظرانداز کرتے ہیں۔

ماخذ: https://tuoitre.vn/lua-dao-mang-lua-ca-ai-tao-kich-ban-thao-tung-tam-ly-20250228163856719.htm

![[تصویر] کیٹ با - گرین جزیرے کی جنت](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F04%2F1764821844074_ndo_br_1-dcbthienduongxanh638-jpg.webp&w=3840&q=75)

![[VIMC بجلی کی رفتار کے 40 دن] دا نانگ پورٹ: اتحاد - بجلی کی رفتار - ختم لائن تک پیش رفت](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764833540882_cdn_4-12-25.jpeg)

تبصرہ (0)