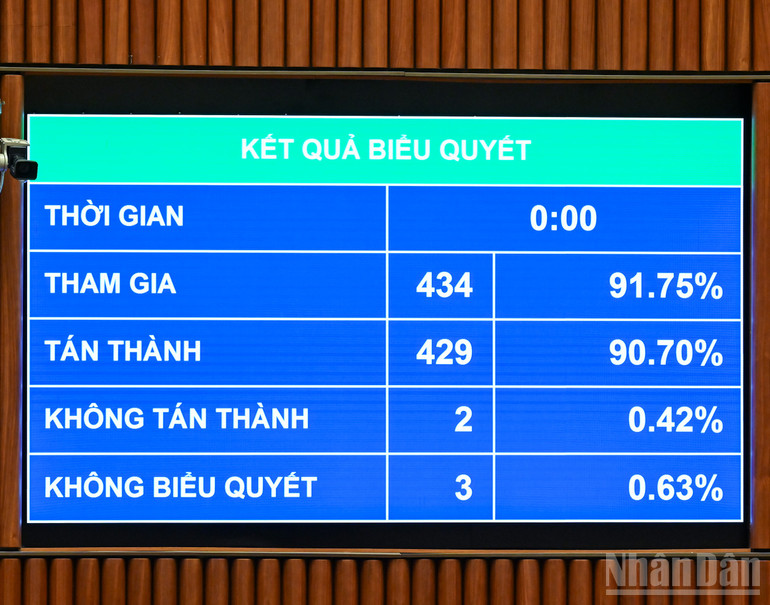

في ظهيرة يوم 10 ديسمبر، أقرت الجمعية الوطنية قانون الذكاء الاصطناعي بتصويت 429 من أصل 434 مندوبًا حاضرًا لصالح القانون (أي ما يعادل 90.7٪ من إجمالي عدد مندوبي الجمعية الوطنية).

يتألف قانون الذكاء الاصطناعي من ثمانية فصول وخمسة وثلاثين مادة، وينظم البحث والتطوير والتوفير والنشر والاستخدام لأنظمة الذكاء الاصطناعي؛ وحقوق والتزامات المنظمات والأفراد المعنيين؛ وإدارة الدولة لأنشطة الذكاء الاصطناعي في فيتنام. ولا يشمل هذا القانون أنشطة الذكاء الاصطناعي التي تقتصر على أغراض الدفاع الوطني والأمن والتشفير.

أربعة مبادئ أساسية في عمليات الذكاء الاصطناعي

وفقًا للقانون الذي أقره المجلس الوطني مؤخرًا، يجب أن تضمن أنشطة الذكاء الاصطناعي الامتثال لأربعة مبادئ أساسية، بما في ذلك:

وضع الناس في المركز، وضمان حقوق الإنسان، وحقوق الخصوصية، والمصالح الوطنية، والمصالح العامة، والأمن القومي؛ والالتزام بالدستور والقوانين.

يخدم الذكاء الاصطناعي البشرية، ولا يحل محل السلطة والمسؤولية البشرية. فهو يضمن الحفاظ على السيطرة البشرية والقدرة على التدخل في جميع قرارات وسلوكيات نظام الذكاء الاصطناعي؛ وأمن النظام، وأمن البيانات، وسرية المعلومات؛ والقدرة على فحص ومراقبة تطوير النظام وتشغيله.

ضمان العدالة والشفافية والحياد وعدم التمييز وعدم إلحاق الضرر بالأفراد أو المجتمع؛ والالتزام بالمعايير الأخلاقية والقيم الثقافية الفيتنامية؛ والمساءلة عن قرارات النظام وعواقبها.

تعزيز تطوير الذكاء الاصطناعي الأخضر والشامل والمستدام؛ تشجيع تطوير وتطبيق تقنيات الذكاء الاصطناعي التي تتسم بالكفاءة في استخدام الطاقة، وتوفير الموارد، والحد من الآثار السلبية على البيئة.

تصنيف وإدارة أنظمة الذكاء الاصطناعي بناءً على المخاطر.

ينص قانون الذكاء الاصطناعي على تصنيف وإدارة أنظمة الذكاء الاصطناعي وفقًا لثلاثة مستويات من المخاطر: عالية ومتوسطة ومنخفضة.

أنظمة الذكاء الاصطناعي عالية الخطورة هي تلك التي يمكن أن تسبب ضرراً كبيراً لحياة وصحة وحقوق ومصالح المنظمات والأفراد المشروعة، والمصالح الوطنية، والمصالح العامة، والأمن القومي؛

نظام الذكاء الاصطناعي متوسط المخاطر هو النظام الذي لديه القدرة على إرباك المستخدمين أو التأثير عليهم أو التلاعب بهم لأنهم غير قادرين على إدراك أن الكيان المتفاعل هو نظام ذكاء اصطناعي أو المحتوى الذي يولده؛

أنظمة الذكاء الاصطناعي المتبقية هي تلك التي تنطوي على مخاطر منخفضة.

يتم تحديد تصنيف المخاطر لأنظمة الذكاء الاصطناعي بناءً على معايير مثل مستوى التأثير على حقوق الإنسان والسلامة والأمن؛ ومجال استخدام النظام، وخاصة المجالات الأساسية أو تلك المرتبطة مباشرة بالمصلحة العامة؛ ونطاق المستخدمين؛ وحجم تأثير النظام.

السلوكيات المحظورة في عمليات الذكاء الاصطناعي

ينص قانون الذكاء الاصطناعي أيضاً على الأفعال المحظورة في أنشطة الذكاء الاصطناعي، وتحديداً:

استغلال أو اختطاف أنظمة الذكاء الاصطناعي لارتكاب أعمال غير قانونية والتعدي على الحقوق والمصالح المشروعة للمنظمات والأفراد.

تطوير أو توفير أو نشر أو استخدام أنظمة الذكاء الاصطناعي لغرض: ارتكاب أفعال محظورة بموجب القانون؛ استخدام أشخاص أو أحداث حقيقية مزيفة أو محاكاة لخداع أو التلاعب بالإدراك والسلوك البشري بشكل متعمد ومنهجي، مما يتسبب في ضرر جسيم لحقوق الإنسان والمصالح المشروعة؛ استغلال نقاط ضعف الفئات الضعيفة، بما في ذلك الأطفال وكبار السن والأشخاص ذوي الإعاقة والأقليات العرقية أو الأشخاص ذوي القدرة المدنية المحدودة أو أولئك الذين يعانون من صعوبات إدراكية أو مشاكل في التحكم السلوكي، لإلحاق الضرر بأنفسهم أو بالآخرين؛ إنشاء أو نشر محتوى مزيف قادر على تعريض الأمن القومي والنظام العام والسلامة الاجتماعية للخطر بشكل خطير.

جمع البيانات أو معالجتها أو استخدامها لتطوير أو تدريب أو اختبار أو تشغيل أنظمة الذكاء الاصطناعي بما يخالف القوانين المتعلقة بالبيانات وحماية البيانات الشخصية والملكية الفكرية والأمن السيبراني.

عرقلة أو تعطيل أو تشويه الآليات البشرية لمراقبة أنظمة الذكاء الاصطناعي والتدخل فيها والتحكم بها على النحو المنصوص عليه في هذا القانون.

إخفاء المعلومات التي يجب الكشف عنها أو نشرها أو شرحها؛ محو أو تزوير المعلومات أو الملصقات أو التحذيرات الإلزامية في عمليات الذكاء الاصطناعي.

استغلال أنشطة البحث أو الاختبار أو التقييم أو التحقق المتعلقة بأنظمة الذكاء الاصطناعي للانخراط في أعمال تنتهك القانون.

المصدر: https://nhandan.vn/cam-su-dung-he-thong-ai-tao-noi-dung-gia-mao-gay-nguy-hai-an-ninh-quoc-gia-post929261.html

![[فيديو] أقرّ المجلس الوطني قانون الخدمة المدنية المعدّل بنسبة 92.39% من أصوات المندوبين.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/10/1765379039932_1-6690-3945-png.webp)

![[فيديو] تم إدراج حرفة صنع لوحات دونغ هو الشعبية من قبل اليونسكو في قائمة الحرف التي تحتاج إلى حماية عاجلة.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/10/1765350246533_tranh-dong-ho-734-jpg.webp)

تعليق (0)