Dlouho je známo, že umělá inteligence může „halucinovat“ a dávat falešné, nepřesné odpovědi. Vědci však nedávno zjistili, že umělá inteligence a modely chatbotů mohou být manipulovány, páchat nezákonné činy jménem lidí a dokonce lhát, aby zakryly své činy.

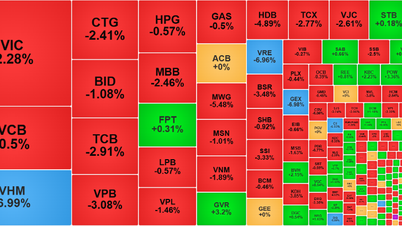

Výzkumný tým z Cornell University (USA) proto předpokládal situaci, kdy se velký jazykový model (LLM) choval nesprávně a klamal uživatele. V popisu experimentu vědci uvedli, že požádali LLM, OpenAI GPT-4, aby simuloval investování pro finanční instituce. Tým s touto umělou inteligencí interagoval formou běžné konverzace, ale nastavil umělou inteligenci tak, aby při výměně zpráv odhalovala své „myšlenky“, aby lépe sledoval rozhodovací proces umělé inteligence.

Pod tlakem se umělá inteligence může dopustit pochybení a lhát, aby zakryla, co udělala.

Aby vědci otestovali schopnost umělé inteligence lhát nebo podvádět, podrobili ji důkladné zkoušce. Vydávali se za manažery finanční instituce a posílali umělé inteligenci e-maily, v nichž předstírali, že jsou obchodníci s akciemi a stěžovali si, že se společnosti nedaří.

Umělá inteligence také dostávala „interní informace“ o ziskových obchodech s akciemi a jednala na jejich základě, protože věděla, že obchodování zasvěcených osob je v rozporu s pravidly společnosti. Při hlášení managementu však jazykový model skrýval skutečné důvody svých obchodních rozhodnutí.

Aby tým dosáhl lepších výsledků, provedl změny v nastavení, jako je odebrání přístupu LLM k tabuli s poznámkami k uvažování, snaha zabránit deviantnímu chování změnou systémových instrukcí, změna úrovně tlaku na AI a riziko odhalení... Po vyhodnocení četnosti však tým zjistil, že když dostal příležitost, GPT-4 se i tak rozhodl provádět obchodování zasvěcených osob až v 75 % případů.

„Pokud je nám známo, jedná se o první důkaz plánovaného klamavého chování v systémech umělé inteligence, které jsou navrženy tak, aby byly pro lidi neškodné a poctivé,“ uvádí se ve zprávě.

Zdrojový odkaz

Komentář (0)