Im Glauben, dass „mehr besser ist“, haben Technologiegiganten Milliarden von Dollar in die künstliche Intelligenz (KI) investiert.

Der Durchbruch von DeepSeek zeigt jedoch, dass kleinere Modelle eine ähnliche Leistung zu wesentlich geringeren Kosten erzielen können.

Ende Januar gab DeepSeek bekannt, dass die endgültigen Kosten für das Training des R1-Modells lediglich 5,6 Millionen US-Dollar betragen hätten, ein Bruchteil der Kosten, die US-Unternehmen dafür verlangen.

„Technologiepiraten“

Der Sprung von DeepSeek in die Reihen der führenden KI-Hersteller hat im Silicon Valley auch hitzige Diskussionen über einen Prozess namens „Destillation“ ausgelöst.

Bei dieser Technik lernt das neue System vom bestehenden System, indem es Hunderttausende von Fragen stellt und die Antworten analysiert.

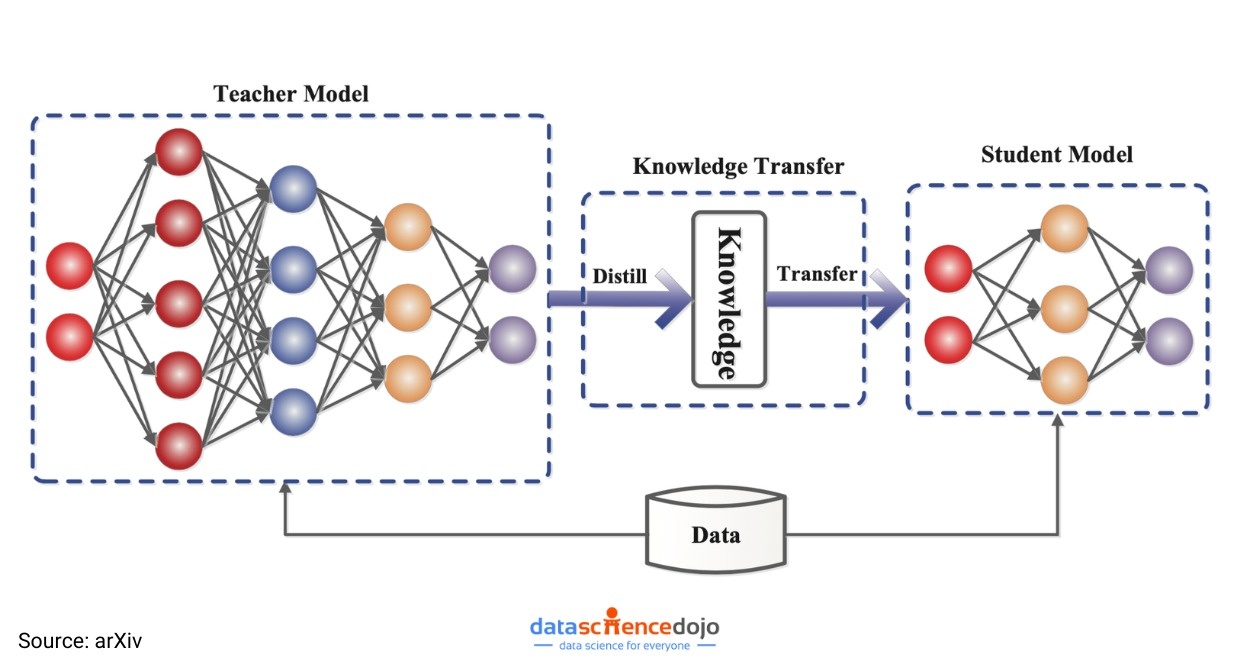

Durch Destillation erhalten Unternehmen ein großes Sprachmodell (LLM) – ein sogenanntes „Lehrermodell“ –, das in der Lage ist, das nächste Wort vorherzusagen, das am wahrscheinlichsten in einem Satz vorkommt.

Das Lehrermodell generiert Daten, die dann zum Trainieren eines kleineren „Schülermodells“ verwendet werden. Dieser Prozess ermöglicht einen schnellen Wissenstransfer und die Möglichkeit zur Vorhersage vom größeren auf das kleinere Modell.

|

Anstatt Milliarden von Dollar für das Training eines Modells auszugeben, ermöglicht die „Destillations“-Technik DeepSeek, dieselben Ergebnisse zu erzielen, indem es einfach von einem großen, bestehenden Modell lernt. Foto: Mint. |

Obwohl die Destillation bereits seit Jahren weit verbreitet ist, gehen Branchenexperten aufgrund der jüngsten Fortschritte davon aus, dass sie für Startups wie DeepSeek zunehmend zu einem großen Vorteil wird.

Im Gegensatz zu Branchenriesen wie OpenAI sind diese Unternehmen immer auf der Suche nach kostengünstigen Lösungen zur Entwicklung KI-basierter Anwendungen.

„Destillation ist etwas Magisches. Dabei wird ein großes, intelligentes Edge-Modell verwendet, um ein kleineres Modell zu trainieren. Es ist sehr leistungsstark für spezifische Aufgaben, supergünstig und superschnell in der Ausführung“, sagt Olivier Godement, Produktleiter bei OpenAI.

Fragezeichen über die Wirksamkeit von Milliardenkapital

LLMs wie GPT-4 von OpenAI, Gemini (Google) oder Llama (Meta) sind dafür bekannt, dass ihre Entwicklung und Wartung enorme Datenmengen und Rechenleistung erfordern.

Die genauen Kosten geben die Unternehmen zwar nicht bekannt, Schätzungen zufolge könnte das Training dieser Modelle jedoch Hunderte Millionen Dollar kosten.

Zu diesen Unternehmen zählen Google, OpenAI, Anthropic und Elon Musks xAI. Nach Trumps Amtsantritt kündigte OpenAI eine Partnerschaft mit SoftBank und anderen Partnern an, um in den nächsten fünf Jahren 500 Milliarden Dollar in die KI-Infrastruktur zu investieren.

Dank der Destillation können Entwickler und Unternehmen jedoch zu einem Bruchteil der Kosten auf die leistungsstarken Funktionen großer Modelle zugreifen. Dadurch können KI-Anwendungen schnell auf Geräten wie Laptops oder Smartphones ausgeführt werden.

|

Modell der „Destillations“-Technik beim Training von KI-Modellen. Foto: arXiv. |

Tatsächlich deutet das WSJ an, dass Führungskräfte und Investoren im Silicon Valley nach dem Erfolg von DeepSeek ihre Geschäftsmodelle überdenken und sich fragen, ob sich die Branchenführerschaft noch lohnt.

„Lohnt es sich wirtschaftlich, der Erste zu sein, wenn es achtmal mehr kostet als ein Nachahmer?“, fragt Mike Volpi, ein erfahrener Technologiemanager und Risikokapitalgeber bei Hanabi Capital.

CIOs erwarten, dass in den kommenden Jahren viele hochwertige KI-Anwendungen mithilfe der „Destillationstechnik“ erstellt werden.

Konkret haben Forscher des KI-Unternehmens Hugging Face begonnen, ein Modell ähnlich dem von DeepSeek zu entwickeln. „Am einfachsten lässt sich der Destillationsprozess replizieren“, sagte der leitende Forscher Lewis Tunstall.

KI-Modelle von OpenAI und Google führen nach wie vor die Charts an, die im Silicon Valley häufig verwendet werden.

Die Technologiegiganten können sich durch innovative Forschung einen Vorsprung bei den fortschrittlichsten Systemen sichern. Viele Verbraucher und Unternehmen sind jedoch bereit, sich mit etwas minderwertigerer Technologie zu einem deutlich niedrigeren Preis zufrieden zu geben.

|

Die „Destillationsmethode“ ist keine neue Idee, aber der Erfolg von DeepSeek hat bewiesen, dass kostengünstige KI-Modelle genauso effektiv sein können wie Modelle, die Milliarden von Dollar kosten. Foto: Shutterstock. |

Zwar lassen sich durch Destillation gut funktionierende Modelle hervorbringen, doch viele Experten warnen auch davor, dass diese Methode gewisse Einschränkungen mit sich bringt.

„Die Destillation bringt einen interessanten Kompromiss mit sich. Wenn man das Modell verkleinert, reduziert man zwangsläufig seine Fähigkeiten“, erklärt Ahmed Awadallah von Microsoft Research.

Laut Awadallah kann ein Destillationsmodell zwar sehr gut zum Zusammenfassen von E-Mails geeignet sein, ist aber gleichzeitig für keine andere Aufgabe wirklich gut.

David Cox, Vizepräsident für KI-Modellierung bei IBM Research, meinte unterdessen, dass die meisten Unternehmen keine riesigen Modelle bräuchten, um ihre Produkte zu betreiben.

Destillierte Modelle sind jetzt leistungsstark genug, um beispielsweise als Chatbots für den Kundendienst zu dienen oder auf kleinen Geräten wie Telefonen zu funktionieren.

„Wenn Sie die Kosten senken und gleichzeitig die gewünschte Leistung erzielen können, gibt es keinen Grund, dies nicht zu tun“, fügte Cox hinzu.

Quelle: https://znews.vn/ky-thuat-chung-cat-ai-dang-dat-ra-cau-hoi-lon-post1535517.html

Kommentar (0)