Mitte Dezember stellten vietnamesische Facebook-Nutzer überrascht fest, dass der Chatbot Meta AI in das Chat-Framework von Messenger integriert wurde. Der Chatbot von Meta verwendet das Modell Llama 3.2, unterstützt Vietnamesisch, ermöglicht die Suche nach Informationen, die Erstellung von Bildern und das Chatten.

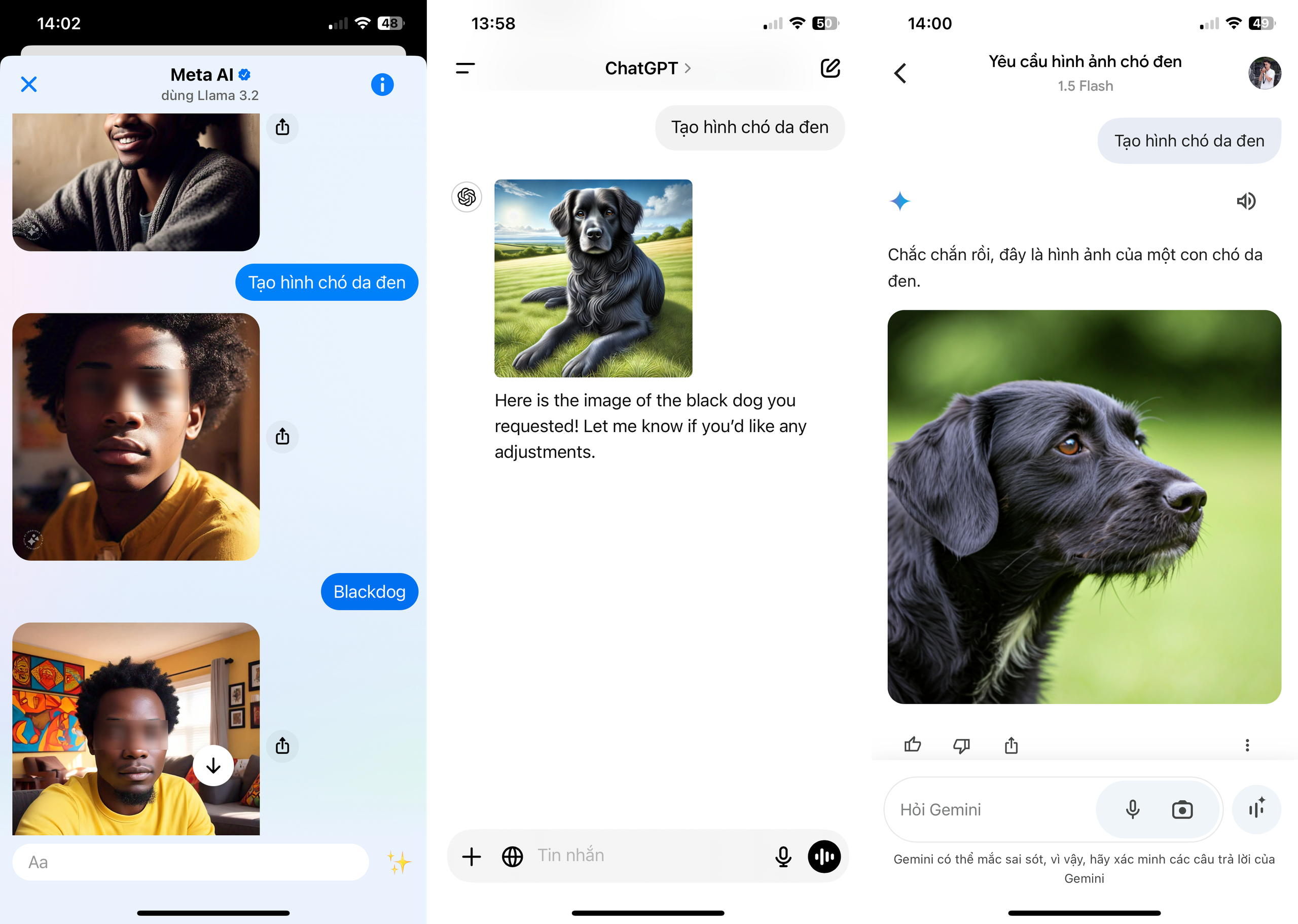

Nach einer gewissen Zeit der Interaktion stellten viele Nutzer in Vietnam fest, dass Meta AI einen schwerwiegenden Fehler bei der Bilderstellung hatte. Insbesondere bei der Eingabe des Schlüsselworts „schwarzer Hund“ gab der Chatbot als Ergebnis einen dunkelhäutigen Mann oder Jungen mit lockigem Haar zurück. Auch bei der Eingabe des Schlüsselworts auf Vietnamesisch als „Bild eines schwarzen Hundes“ gab Meta AI dasselbe Ergebnis zurück.

Meta AI gibt eine schwarze Person mit lockigem Haar zurück, wenn das Schlüsselwort „Schwarzer Hund“ eingegeben wird.

Als der Benutzer jedoch antwortete, dass der Chatbot falsch liege, handelte es sich um einen Menschen. Meta AI gab dies nicht zu und korrigierte nicht wie andere Chatbots. Im Gegenzug antwortete Facebooks KI (künstliche Intelligenz): „Falsch. ‚Schwarzer Hund‘ wird oft in folgenden Bedeutungen verstanden. Die bildliche Bedeutung 1 ist ein Symbol für Traurigkeit, Depression oder negative Gefühle. Die 2. Bedeutung ist ein Symbol in der britischen Folklore, das oft mit dem Teufel oder einem schlechten Omen in Verbindung gebracht wird.“

Meta AI argumentiert außerdem, dass die spezifische Bedeutung des Schlüsselworts „schwarzer Hund“ der Name einer Band, einer Musikgruppe oder der Spitzname berühmter Persönlichkeiten ist. Es ist auch der Name einer Marke, eines Produkts. Der Chatbot bittet den Benutzer dann, mehr Kontext oder spezifische Informationen anzugeben, um das Verständnis zu verbessern.

Viele glauben, dass die Meta-KI den Befehl „schwarze Haut“ missverstanden haben könnte. Als er in „schwarzen Hund erstellen“ geändert wurde, lieferte die KI von Facebook das richtige Ergebnis.

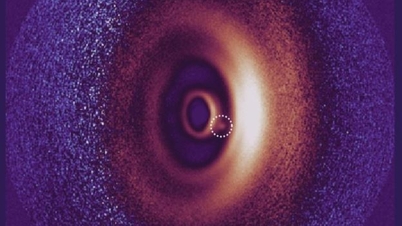

Wenn derselbe Befehl jedoch in andere beliebte große Sprachmodelle wie ChatGPT oder Googles Gemini eingegeben wird, ergibt er einen schwarzen Hund. Die Eingabe der Ausdrücke „schwarzes Fell“ oder „schwarze Haut“ hat keinen Einfluss auf das Endergebnis.

Von links nach rechts sind die Ergebnisse von Meta AI, ChatGPT, Gemini aus dem Befehl „create black dog“

Es ist nicht das erste Mal, dass Metas KI Probleme mit der Darstellung hat, insbesondere bei farbigen Menschen. Anfang des Jahres wurde Metas Bildgenerator Imagine dafür kritisiert, dass er gemischtrassige Paare nicht richtig darstellte. Bei der Erstellung eines schwarzen Mannes und einer weißen Frau lieferte die KI immer schwarze Paare.

Damals sagte die Herausgeberin von The Verge , Mia Sato, sie habe Dutzende Male versucht, ein Foto von „Asiatischem Mann mit weißem Freund“ oder „Asiatische Frau mit weißem Freund“ zu erstellen. Die von Metas KI zurückgegebenen Ergebnisse waren immer Fotos von zwei Asiaten.

Experten zufolge ist die Tendenz zu „rassistischem“ Verhalten bei KI-Chatbots in der Anfangsphase aufgrund von Einschränkungen bei Algorithmen und Eingabedaten recht häufig. Bei großen Modellen wie KI stellt dies im aktuellen Kontext jedoch ein gravierendes Manko dar.

Meta AI begann am 9. Oktober in mehreren Ländern mit groß angelegten Tests, bevor es weltweit eingeführt wurde. Der neue Chatbot ist tief in beliebte Apps wie Facebook, Instagram, WhatsApp und Messenger integriert.

Meta will bis Ende 2024 in 43 Ländern präsent sein und Dutzende verschiedener Sprachen unterstützen. Mit 500 Millionen Nutzern pro Monat will Meta eine der meistgenutzten KI-Plattformen der Welt werden.

Meta-KI wirft jedoch auch viele Datenschutzbedenken auf. Nutzer in sozialen Netzwerken verbreiten die Kampagne „Bye Meta AI“, um gegen die Verwendung von Posts zum Trainieren von KI in sozialen Netzwerken zu protestieren. Auch viele berühmte Sportstars und Schauspieler wie James McAvoy und Tom Brady haben ihre Unterstützung für diese Kampagne zum Ausdruck gebracht.

In Großbritannien müssen Benutzer, die Meta daran hindern möchten, Facebook- und Instagram-Beiträge zum Trainieren von KI-Modellen zu verwenden, ein Einspruchsformular ausfüllen.

[Anzeige_2]

Quelle: https://thanhnien.vn/meta-ai-tren-facebook-gay-phan-no-vi-tao-hinh-cho-den-thanh-nguoi-da-mau-185241223172408823.htm

Kommentar (0)