Si alguna vez has navegado por redes sociales, es probable que te hayas encontrado con imágenes o vídeos creados por IA. Mucha gente ha sido engañada, como el vídeo viral de conejos saltando en un trampolín. Pero Sora, una aplicación hermana de ChatGPT desarrollada por OpenAI, está llevando los vídeos de IA a un nuevo nivel, haciendo que la detección de contenido falso sea cada vez más urgente.

Las herramientas de video con IA dificultan más que nunca la identificación de videos auténticos. (Fuente: CNET)

Lanzada en 2024 y actualizada recientemente con Sora 2, esta app tiene una interfaz similar a la de TikTok, donde todos los videos son generados por IA. La función "cameo" permite insertar personas reales en secuencias simuladas, creando videos de un realismo aterrador.

Por lo tanto, muchos expertos temen que Sora provoque la propagación de deepfakes, distorsionando la información y difuminando la línea entre la realidad y la falsificación. Las celebridades son particularmente vulnerables, lo que ha llevado a organizaciones como SAG-AFTRA a solicitar a OpenAI que refuerce su protección.

Identificar contenido generado por IA es un gran desafío tanto para las empresas tecnológicas, las plataformas de redes sociales como para los usuarios. Sin embargo, existen maneras de reconocer videos creados con Sora.

Encuentra la marca de agua de Sora

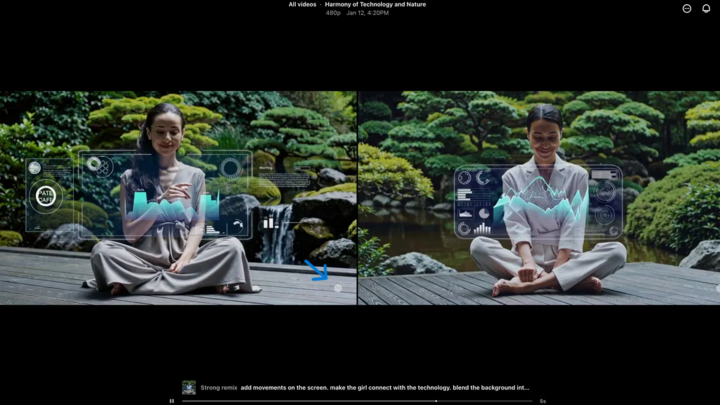

La marca de agua de Sora (indicada por la flecha azul) es un marcador que identifica la herramienta utilizada para crear el video. (Fuente: CNET)

Cada video creado en la aplicación Sora iOS tiene una marca de agua cuando se descarga: el logotipo blanco de Sora (ícono de nube) se mueve por los bordes del video, similar a la marca de agua de TikTok.

Esta es una forma visual de identificar contenido generado por IA. Por ejemplo, el modelo "nano-banana" Gemini de Google también añade automáticamente una marca de agua a las imágenes. Sin embargo, las marcas de agua no siempre son fiables. Si la marca de agua es estática, se puede recortar fácilmente. Incluso las marcas de agua dinámicas, como las de Sora, se pueden eliminar con aplicaciones especializadas.

Al ser preguntado sobre esto, Sam Altman, director ejecutivo de OpenAI, argumentó que la sociedad necesita adaptarse a la realidad de que cualquiera puede crear videos falsos. Antes de Sora, nunca había existido una herramienta tan popular, accesible y sin necesidad de habilidades para crear tales videos. Su perspectiva destaca la necesidad de recurrir a métodos de verificación alternativos.

Comprobar metadatos

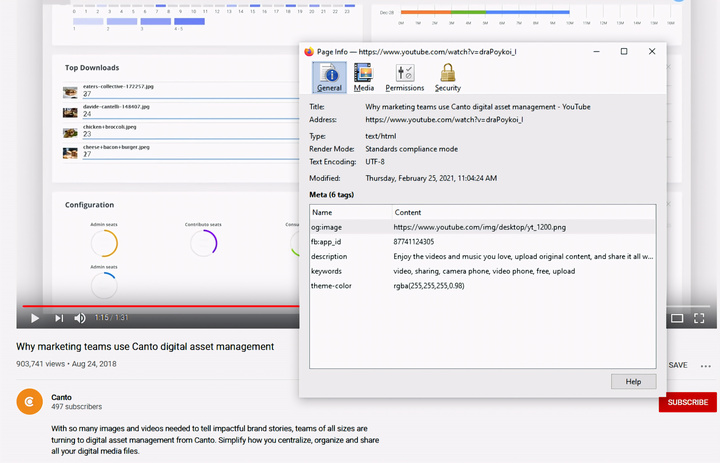

Verificar metadatos: un paso crucial para determinar si un video fue creado por IA, como Sora. (Fuente: Canto)

Podrías pensar que verificar metadatos es demasiado complicado, pero en realidad es bastante simple y muy efectivo.

Los metadatos son un conjunto de información que se adjunta automáticamente al contenido al crearse, como el tipo de cámara, la ubicación, la hora de grabación y el nombre del archivo. Ya sea generado por personas o por IA, el contenido contiene metadatos. En el caso del contenido generado por IA, los metadatos suelen incluir información sobre la atribución de la fuente.

OpenAI es miembro de la Coalición para el Origen y la Autenticidad del Contenido (C2PA), por lo que los vídeos de Sora contendrán metadatos de C2PA. Puede verificarlo utilizando la herramienta de verificación de la iniciativa de autenticidad del contenido:

Cómo comprobar los metadatos:

- Visita verify.contentauthenticity.org

- Sube el archivo a revisar.

- Presione “Abrir”

- Vea la información en la tabla de la derecha.

Si el video fue creado por IA, el resumen lo indicará claramente. Al revisar los videos de Sora, verá la línea "Publicado por OpenAI" e información que confirma que el video fue creado con IA. Todos los videos de Sora deben incluir esta información para verificar su origen.

Fuente: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Imagen] La Oficina Central del Partido resume el trabajo en 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F18%2F1766065572073_vptw-hoi-nghi-tong-ket-89-1204-jpg.webp&w=3840&q=75)

Kommentar (0)