La Fuerza Aérea de Estados Unidos negó el 2 de junio los informes de que había realizado una simulación en la que un vehículo aéreo no tripulado (UAV) bajo inteligencia artificial (IA) decidió “matar” a su operador humano para evitar que interfiriera con su misión, según USA Today.

Las especulaciones comenzaron el mes pasado cuando, en una conferencia en Londres, el coronel Tucker Hamilton dijo que un UAV controlado por IA utilizó “estrategias extremadamente inesperadas para lograr sus objetivos”.

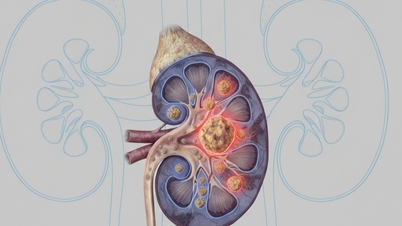

Un dron MQ-9 Reaper de la Fuerza Aérea de EE. UU. en la base aérea de Kandahar, en Afganistán, en 2018.

Según él, la prueba simuló un UAV operado por IA al que se le ordenó destruir el sistema de defensa aérea de un oponente. Luego, cuando el operador le ordenó ignorar el objetivo, el UAV atacó y mató al operador porque este interfirió con su objetivo principal.

Sin embargo, nadie fue atacado de esa manera. En una entrevista con Business Insider , la portavoz de la Fuerza Aérea de EE. UU., Ann Stefanek, afirmó que no se realizó tal simulación.

La aterradora advertencia del exdirector de Google: la IA tiene la capacidad de "expulsar" a la humanidad

“La Fuerza Aérea no ha llevado a cabo ninguna de tales actividades y sigue comprometida con el uso ético y responsable de la tecnología de IA”, dijo el portavoz, señalando que “parece que los comentarios del coronel fueron sacados de contexto”.

Tras la declaración de la Fuerza Aérea de EE. UU., el Sr. Hamilton aclaró que se había equivocado al hablar en su presentación en Londres. Según él, la simulación era solo un experimento hipotético. La Real Sociedad Aeronáutica (Reino Unido), organizadora de la conferencia, no respondió a las solicitudes de comentarios.

[anuncio_2]

Enlace de origen

![[Foto] El Secretario General To Lam recibe al Director de la Academia de Administración Pública y Economía Nacional bajo la presidencia de la Federación Rusa.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F08%2F1765200203892_a1-bnd-0933-4198-jpg.webp&w=3840&q=75)

Kommentar (0)