بر این اساس، عکسی از انفجاری در نزدیکی پنتاگون که توسط هوش مصنوعی (AI) ایجاد شده بود، در ۲۲ مه در شبکههای اجتماعی آمریکا به اشتراک گذاشته شد و باعث سقوط بازار سهام در مدت کوتاهی شد و در نتیجه نگرانیهایی را در مورد اخبار جعلی ناشی از هوش مصنوعی ایجاد کرد.

|

| عکس جعلی ساخته شده توسط هوش مصنوعی از انفجار در نزدیکی پنتاگون. |

نیک واترز از Bellingcat، یک گروه بررسی واقعیت آنلاین، به سرعت به مشکلات قابل توجه عکس اشاره کرد. اول اینکه، هیچ شاهد عینی برای تأیید این حادثه وجود ندارد. ساختمان موجود در عکس نیز شبیه پنتاگون نیست. برخی جزئیات غیرمعمول، مانند تیرهای چراغ برق برجسته و ستونهای سیاه بیرون زده از پیادهرو، نشانههایی از واقعی نبودن عکس هستند.

ابزارهای بازسازی هوش مصنوعی (AI) زیادی مانند Midjourney، Dall-e 2 و Stable Diffusion وجود دارند که میتوانند تصاویر واقعی ایجاد کنند. با این حال، این ابزارها در صورت کمبود دادهها، شکافها را پر میکنند.

الجزیره برای تمایز قائل شدن بین تصاویر تولید شده توسط هوش مصنوعی و عکسهای واقعی از رویدادهای مهم، هنگام انتشار در اینترنت، اقداماتی را به شرح زیر انجام داده است:

- در صورت وقوع انفجار یا رویدادی بزرگ، معمولاً اطلاعات واقعی از افراد مختلف و از دیدگاههای مختلف وجود خواهد داشت.

- چه کسی محتوا را منتشر میکند؟ آنها کجا هستند و رویداد در کجا برگزار میشود؟ چه حسابهایی را دنبال میکنند و چه کسی آنها را دنبال میکند. آیا میتوانید با آنها تماس بگیرید یا صحبت کنید؟

- تصاویر و محیط اطراف را تجزیه و تحلیل کنید: به دنبال سرنخهایی در تصویر مانند مکانهای نزدیک، علائم راهنمایی و رانندگی و غیره باشید تا به شما در تعیین محل یا زمان وقوع یک رویداد کمک کند.

- برای تصاویر افراد، به چشمها، دستها و حالت کلی بدن آنها توجه کنید. ویدیوهای تولید شده توسط هوش مصنوعی که از انسانها تقلید میکنند و به آنها دیپ فیک میگویند، معمولاً در پلک زدن مشکل دارند زیرا اکثر مجموعه دادههای آموزشی حاوی چهرههای با چشم بسته نیستند. دستها اشیاء را به درستی نمیگیرند.

- پوست افراد در تصاویر تولید شده توسط هوش مصنوعی اغلب صاف خواهد بود و حتی مو و دندانهای آنها نیز به طرز شگفتآوری بینقص خواهد بود.

منبع

![[عکس] از جشنواره آتشبازی لیویانگ در هونان، چین لذت ببرید](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761463428882_ndo_br_02-1-my-1-jpg.webp)

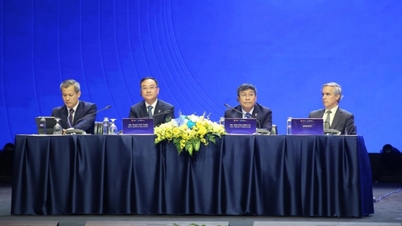

![[عکس] دبیرکل، تو لام، از هیئت شرکتکننده در کنفرانس بینالمللی مطالعات ویتنام استقبال کرد](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761456527874_a1-bnd-5260-7947-jpg.webp)

![[عکس] روزنامه نهان دان پیشنویس اسناد چهاردهمین کنگره ملی حزب را به نمایش گذاشته و نظرات کاربران را در مورد آن جویا شده است](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761470328996_ndo_br_bao-long-171-8916-jpg.webp)

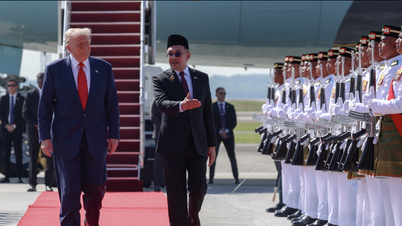

![[عکس] نخست وزیر فام مین چین در افتتاحیه چهل و هفتمین اجلاس آسه آن شرکت کرد](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761452925332_c2a-jpg.webp)

نظر (0)