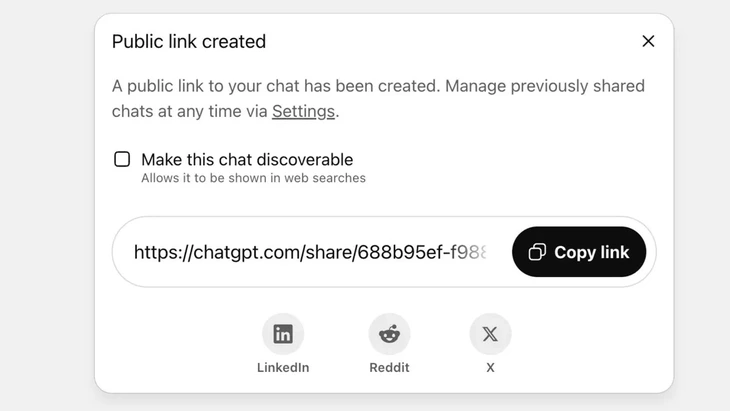

قابلیت اشتراکگذاری چتها از طریق لینک عمومی در ChatGPT - عکس: Techradar

ChatGPT اکنون روزانه به بیش از ۲.۵ میلیارد درخواست از کاربران جهانی میرسد که نشاندهنده محبوبیت روزافزون این چتبات است.

با این حال، این ابزار با واکنش شدید کاربران مواجه شده است، زیرا ویژگی «اشتراکگذاری» باعث شده است که هزاران مکالمه، اطلاعات حساس را به گوگل و برخی موتورهای جستجو در اینترنت نشت دهند.

ریسک امنیتی بالا

آقای وو نگوک سون - رئیس بخش فناوری انجمن ملی امنیت سایبری (NCA) - ارزیابی کرد که حادثه فوق نشاندهنده سطح بالایی از خطر امنیتی برای کاربران ChatGPT است.

آقای وو نگوک سان تحلیل کرد: «حادثه فوق لزوماً یک نقص فنی نیست، زیرا ابتکار عمل خاصی از کاربر در کلیک روی دکمه اشتراکگذاری وجود دارد. با این حال، میتوان گفت که مشکل در طراحی محصول چتبات هوش مصنوعی نهفته است، زمانی که کاربران را گیج کرده و اقدامات هشداردهنده کافی در مورد خطر نشت اطلاعات شخصی در صورت اشتراکگذاری توسط کاربران وجود ندارد.»

در ChatGPT، این ویژگی پس از اینکه کاربر تصمیم به اشتراکگذاری چت از طریق یک لینک عمومی میگیرد، پیادهسازی میشود. محتوا به عنوان یک وبسایت عمومی (chatgpt.com/share/...) در سرور OpenAI ذخیره میشود و برای دسترسی به آن نیازی به نام کاربری یا رمز عبور نیست.

خزندههای گوگل بهطور خودکار این صفحات را اسکن و فهرستبندی میکنند و باعث میشوند که آنها در نتایج جستجو، از جمله متنهای حساس، تصاویر یا دادههای چت، ظاهر شوند.

بسیاری از کاربران از این خطر بیاطلاع بودند و فکر میکردند که چت را با دوستان یا مخاطبین خود به اشتراک میگذارند. این امر منجر به افشای هزاران مکالمه شد که در برخی موارد حاوی اطلاعات شخصی حساس بود.

اگرچه OpenAI پس از واکنش شدید جامعه، این ویژگی را در اواخر ژوئیه ۲۰۲۵ به سرعت حذف کرد، اما هنوز هماهنگی با گوگل برای حذف ایندکسهای قدیمی زمان میبرد. به خصوص با سیستم ذخیرهسازی پیچیده، که شامل سرورهای حافظه پنهان گوگل نیز میشود، این کار را نمیتوان به سرعت انجام داد.

با چتباتهای هوش مصنوعی به عنوان یک «جعبه سیاه ایمنی» رفتار نکنید

وو نگوک سون، متخصص امنیت دادهها - رئیس فناوری انجمن ملی امنیت سایبری (NCA) - عکس: CHI HIEU

نشت هزاران لاگ چت میتواند خطراتی مانند افشای اسرار شخصی و تجاری، آسیب به اعتبار، خطرات مالی یا حتی خطرات امنیتی به دلیل افشای آدرس منزل را برای کاربران ایجاد کند.

«چتباتهای مجهز به هوش مصنوعی مفید هستند اما یک «جعبه سیاه» نیستند، زیرا دادههای به اشتراک گذاشته شده در صورت عدم کنترل میتوانند برای همیشه در وب وجود داشته باشند.»

حادثه فوق مطمئناً درسی برای ارائه دهندگان و کاربران است. سایر ارائه دهندگان خدمات هوش مصنوعی میتوانند از این تجربه درس بگیرند و ویژگیهایی را با هشدارهای واضحتر و شفافتر طراحی کنند.

وو نگوک سان، متخصص امنیت، توصیه کرد: «در عین حال، کاربران باید به طور پیشگیرانه انتشار کنترلنشدهی اطلاعات هویتی یا شخصی خود را در پلتفرمهای هوش مصنوعی محدود کنند.»

به گفته کارشناسان امنیت دادهها، حادثه فوق نیاز به راهروهای قانونی و استانداردهای امنیت سایبری برای هوش مصنوعی را نشان میدهد. تأمینکنندگان و توسعهدهندگان هوش مصنوعی همچنین باید سیستمهایی را طراحی کنند که امنیت را تضمین کنند و از خطر نشت دادهها مانند موارد زیر جلوگیری کنند: نشت از طریق آسیبپذیریهای بد؛ آسیبپذیریهای نرمافزاری منجر به حملات پایگاه داده؛ کنترل ضعیف منجر به مسمومیت، سوءاستفاده برای پاسخ به سوالات نادرست و تحریفشده.

کاربران همچنین باید اشتراکگذاری اطلاعات شخصی با هوش مصنوعی را کنترل کنند، نه اطلاعات حساس را. در صورت نیاز واقعی، توصیه میشود از حالت ناشناس استفاده کنید یا اطلاعات را به طور فعال رمزگذاری کنید تا از ارتباط مستقیم دادهها با افراد خاص جلوگیری شود.

منبع: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[عکس] «قبرستان کشتیها» در خلیج شوان دای](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[ویدئو] بناهای تاریخی هوئه برای استقبال از بازدیدکنندگان بازگشایی شدند](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

نظر (0)