پس از آنکه شرکت نوپای OpenAI اولین اپلیکیشن هوش مصنوعی خود، ChatGPT، را در اواخر سال 2022 عرضه کرد، موجی از توسعه اپلیکیشنهای هوش مصنوعی، به ویژه هوش مصنوعی مولد، آغاز شد که مزایای زیادی را برای همه جنبههای زندگی به ارمغان آورد. با این حال، این امر خطرات زیادی را نیز به همراه دارد.

تجاوز به حریم خصوصی

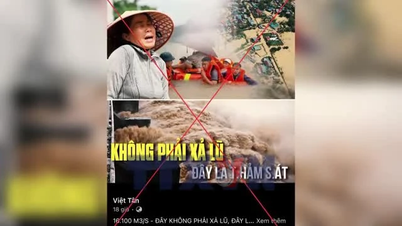

در سالهای اخیر، بسیاری از سازمانها و افراد متحمل خسارات قابل توجهی شدهاند، زیرا مجرمان سایبری از هوش مصنوعی برای ایجاد کلیپهای ویدیویی جعلی که تصاویر و صدای افراد واقعی را تقلید میکنند، استفاده کردهاند. نمونه بارز این کلاهبرداری، کلاهبرداری دیپفیک است که شامل فریب دادن فرد واقعی برای باور کردن واقعی بودن اوست.

طبق گزارش کلاهبرداری هویتی که توسط سامساب در اواخر نوامبر ۲۰۲۳ منتشر شد، کلاهبرداریهای دیپفیک در سطح جهانی در دو سال بین ۲۰۲۲ تا ۲۰۲۳ ده برابر افزایش یافته است. این همچنین دورهای بود که برنامههای تولید شده توسط هوش مصنوعی در سراسر جهان به طور انفجاری گسترش یافتند.

Status Labs خاطرنشان میکند که فناوری دیپفیک تأثیر قابلتوجهی بر فرهنگ، حریم خصوصی و اعتبار شخصی داشته است. بخش عمدهای از اخبار و توجهات پیرامون دیپفیک بر پورنوگرافی افراد مشهور، محتوای انتقامجویانه، اطلاعات نادرست، اخبار جعلی، باجگیری و کلاهبرداری متمرکز شده است. به عنوان مثال، در سال ۲۰۱۹، یک شرکت انرژی آمریکایی توسط هکرها که خود را جای رهبران شرکت و صدای آنها جا زده بودند و از کارمندان میخواستند پول را به شرکا منتقل کنند، ۲۴۳۰۰۰ دلار کلاهبرداری شد.

رویترز گزارش داد که در سال ۲۰۲۳، تقریباً ۵۰۰۰۰۰ فایل ویدیویی و صوتی دیپفیک در رسانههای اجتماعی در سراسر جهان به اشتراک گذاشته شد. علاوه بر دیپفیکهایی که برای سرگرمی ساخته شدهاند، کلاهبرداریهایی نیز وجود دارد که توسط بازیگران مخرب برای فریب مردم طراحی شدهاند. برخی منابع نشان میدهند که در سال ۲۰۲۲، کلاهبرداریهای دیپفیک در سراسر جهان حدود ۱۱ میلیون دلار ضرر ایجاد کرده است.

بسیاری از کارشناسان فناوری در مورد جنبههای منفی هوش مصنوعی، از جمله مسائل مربوط به حقوق مالکیت معنوی و اصالت، و علاوه بر آن، اختلافات مربوط به مالکیت معنوی بین «آثار» خلق شده توسط هوش مصنوعی هشدار دادهاند. به عنوان مثال، ممکن است کسی از هوش مصنوعی برای نقاشی روی یک موضوع خاص استفاده کند و شخص دیگری نیز ممکن است از هوش مصنوعی برای انجام همین کار استفاده کند و در نتیجه نقاشیهایی با شباهتهای زیادی ایجاد شود.

این امر به راحتی منجر به اختلافات مالکیت میشود. با این حال، تا به امروز، جهان هنوز در مورد به رسمیت شناختن حق چاپ برای محتوای تولید شده توسط هوش مصنوعی (به رسمیت شناختن حق چاپ برای افرادی که سفارش ساخت هوش مصنوعی را میدهند یا برای شرکتهایی که برنامههای هوش مصنوعی را توسعه میدهند) تصمیمی نگرفته است.

تصویری که توسط یک برنامه هوش مصنوعی ایجاد شده است.

تشخیص اصل و تقلبی بودنش سخته.

بنابراین، آیا محتوای تولید شده توسط هوش مصنوعی میتواند حق چاپ را نقض کند؟ از نظر فنی، محتوای تولید شده توسط هوش مصنوعی توسط الگوریتمهایی از دادههایی که بر اساس آنها آموزش دیدهاند، سنتز میشود. این پایگاههای داده توسط توسعهدهندگان برنامههای هوش مصنوعی از منابع مختلف، در درجه اول از پایگاه دانش گسترده در اینترنت، جمعآوری میشوند. بسیاری از این آثار در حال حاضر دارای حق چاپ برای صاحبان خود هستند.

در ۲۷ دسامبر ۲۰۲۳، نیویورک تایمز علیه OpenAI (به همراه ChatGPT) و مایکروسافت شکایتی تنظیم کرد و مدعی شد که میلیونها مقاله آن برای آموزش چتباتهای هوش مصنوعی و پلتفرمهای هوش مصنوعی این دو شرکت استفاده شده است. شواهد ارائه شده شامل محتوایی بود که به درخواست کاربر توسط چتباتها تولید شده و مشابه یا کاملاً مشابه محتوای مقالات بود. این روزنامه نمیتوانست این واقعیت را نادیده بگیرد که مالکیت معنوی آن توسط این شرکتها برای سودآوری مورد استفاده قرار میگیرد.

نیویورک تایمز اولین روزنامه بزرگ آمریکایی است که دادخواستی در مورد حق چاپ مربوط به هوش مصنوعی ارائه داده است. این احتمال وجود دارد که روزنامههای دیگر نیز در آینده، به ویژه پس از پرونده موفقیتآمیز نیویورک تایمز، شکایت کنند.

پیش از این، OpenAI در ژوئیه ۲۰۲۳ با آسوشیتدپرس و در دسامبر ۲۰۲۳ با اکسل اشپرینگر - ناشر آلمانی که مالک Politico و Business Insider است - به توافقنامههای صدور مجوز دست یافته بود.

سارا سیلورمن، بازیگر، نیز در ژوئیه ۲۰۲۳ درگیر چندین دعوی حقوقی شد و ادعا کرد که متا و OpenAI از خاطرات او به عنوان مطالب آموزشی برای برنامههای هوش مصنوعی استفاده کردهاند. بسیاری از نویسندگان نیز پس از افشاگریهایی مبنی بر اینکه سیستمهای هوش مصنوعی دهها هزار کتاب را در پایگاههای داده خود جذب کردهاند، ابراز نگرانی کردهاند و این امر منجر به طرح دعوی از سوی نویسندگانی مانند جاناتان فرانزن و جان گریشام شده است.

در همین حال، گتی ایمیجز، یک شرکت خدمات عکس، از یک شرکت هوش مصنوعی به دلیل ایجاد تصاویر بر اساس پیامهای متنی، که گفته میشود از طریق استفاده غیرمجاز از مطالب تصویری دارای حق چاپ این شرکت انجام شده، شکایت کرده است.

کاربران ممکن است هنگام استفاده «بیدقت» از «آثاری» که به ابزارهای هوش مصنوعی سفارش دادهاند، با مشکلات حق نشر مواجه شوند. کارشناسان همیشه توصیه میکنند از ابزارهای هوش مصنوعی فقط برای تحقیق، جمعآوری دادهها و پیشنهادهایی برای اهداف مرجع استفاده شود.

از سوی دیگر، برنامههای هوش مصنوعی با دشوار کردن تشخیص محتوای واقعی از جعلی، کاربران را گیج میکنند. ناشران و اتاقهای خبر ممکن است هنگام دریافت نسخههای خطی سردرگم شوند. معلمان نیز در تشخیص اینکه آیا در کار دانشآموزان از هوش مصنوعی استفاده شده است یا خیر، با مشکل مواجه میشوند.

اکنون جامعه باید هوشیارتر باشد زیرا تشخیص محتوای واقعی از جعلی دشوار است. به عنوان مثال، برای یک فرد عادی تشخیص اینکه آیا یک عکس توسط هوش مصنوعی دستکاری یا ویرایش شده است، دشوار خواهد بود.

مقررات قانونی در مورد استفاده از هوش مصنوعی مورد نیاز است.

در حالی که منتظر توسعه ابزارهایی هستیم که قادر به تشخیص تداخل هوش مصنوعی هستند، نهادهای نظارتی باید مقررات قانونی واضح و مشخصی را در مورد استفاده از این فناوری برای ایجاد محتوای اصلی وضع کنند. این مقررات باید به وضوح به عموم نشان دهند که کدام محتوا یا آثار توسط هوش مصنوعی دستکاری شدهاند، به عنوان مثال، به طور پیشفرض یک علامت آبی به تصاویری که توسط هوش مصنوعی پردازش شدهاند، اضافه شود.

منبع: https://nld.com.vn/mat-trai-cua-ung-dung-tri-tue-nhan-tao-196240227204333618.htm

![[عکس] نخست وزیر فام مین چین در کنفرانس اجرای وظایف بخش صنعت و تجارت برای سال 2026 شرکت میکند](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766159500458_ndo_br_shared31-jpg.webp&w=3840&q=75)

نظر (0)