DeepSeek, la startup chinoise qui a fait le plus parler d'elle ces derniers jours, a suscité des doutes quant à son affirmation de créer une IA équivalente à OpenAI avec seulement 5 millions de dollars.

DeepSeek a bénéficié d'une importante couverture médiatique, tant sur le plan des médias traditionnels que sur les réseaux sociaux, au début de l'année du Serpent, provoquant des secousses importantes sur les marchés boursiers mondiaux.

Cependant, un récent rapport du cabinet de conseil financier Bernstein avertit que, malgré des résultats impressionnants, l'affirmation selon laquelle il serait possible de créer un système d'IA comparable à celui d'OpenAI pour seulement 5 millions de dollars est inexacte.

Selon Bernstein, la déclaration de DeepSeek est trompeuse et ne reflète pas la situation dans son ensemble.

« Nous pensons que DeepSeek n’a pas “créé OpenAI avec 5 millions de dollars” ; les modèles sont fantastiques, mais nous ne pensons pas qu’il s’agisse de miracles ; et la panique du week-end semble avoir été exagérée », indique le rapport.

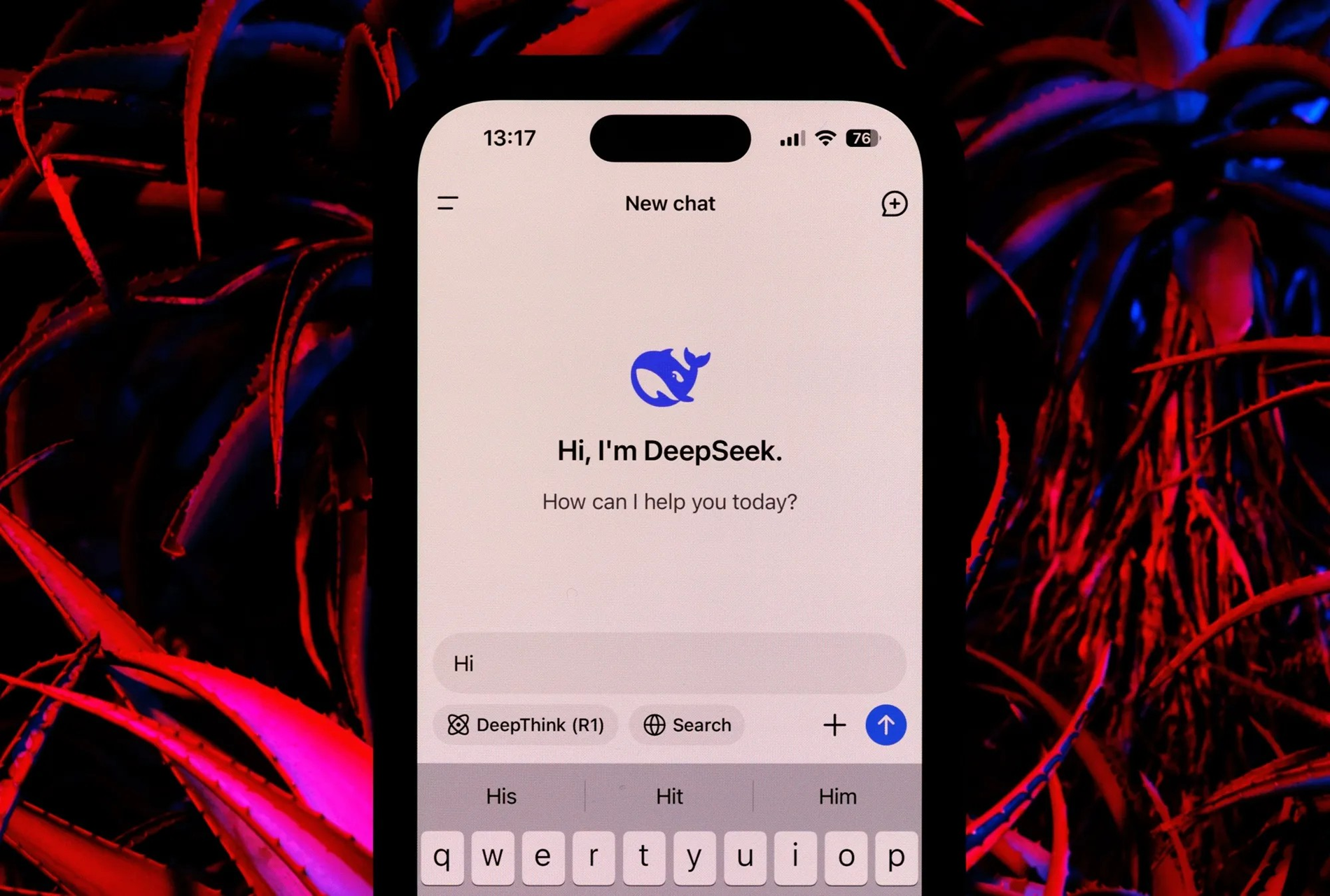

DeepSeek développe deux principaux modèles d'IA : DeepSeek-V3 et DeepSeek R1. Le modèle de langage V3 à grande échelle exploite l'architecture MOE, combinant des modèles plus petits pour obtenir des performances élevées tout en utilisant moins de ressources de calcul que les modèles traditionnels.

En revanche, le modèle V3 compte 671 milliards de paramètres, dont 37 milliards sont actifs à tout moment, intégrant des innovations telles que MHLA pour réduire l'utilisation de la mémoire et utilisant FP8 pour une plus grande efficacité.

L'entraînement du modèle V3 a nécessité un cluster de 2 048 GPU Nvidia H800 pendant deux mois, soit l'équivalent de 5,5 millions d'heures de calcul. Si certaines estimations évaluent le coût de l'entraînement à environ 5 millions de dollars, le rapport de Bernstein souligne que ce chiffre ne couvre que les ressources de calcul et ne prend pas en compte les coûts importants liés à la recherche, aux tests et aux autres dépenses de développement.

Le modèle DeepSeek R1 s'appuie sur les fondements de V3 en utilisant l'apprentissage par renforcement (RL) et d'autres techniques pour garantir la capacité d'inférence.

Le modèle R1 peut rivaliser avec les modèles d'OpenAI dans les tâches de raisonnement. Cependant, Bernstein souligne que son développement exige des ressources considérables, bien que celles-ci ne soient pas détaillées dans le rapport de DeepSeek.

À propos de DeepSeek, Bernstein a salué les performances impressionnantes des modèles. Il a notamment cité l'exemple du modèle V3, dont les résultats sont au moins aussi bons, voire meilleurs, que ceux des principaux modèles de langage en linguistique, en programmation et en mathématiques, tout en nécessitant moins de ressources.

Le processus de pré-entraînement V3 n'a nécessité que 2,7 millions d'heures de travail GPU, soit 9 % des ressources de calcul de certains autres modèles de haut niveau.

Bernstein a conclu que, si les progrès de DeepSeek sont remarquables, il convient de se méfier des affirmations exagérées. L'idée de créer un concurrent à OpenAI avec seulement 5 millions de dollars semble illusoire.

(Selon le Times of India)

Source : https://vietnamnet.vn/deepseek-khong-the-lam-ai-tuong-duong-openai-voi-5-trieu-usd-2367340.html

![[Photo] Le Premier ministre Pham Minh Chinh participe à la Conférence sur la mise en œuvre des objectifs du secteur de l'industrie et du commerce pour 2026](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766159500458_ndo_br_shared31-jpg.webp&w=3840&q=75)

Comment (0)