नकली AI चित्र कैसे काम करते हैं?

आजकल एआई हर जगह है – युद्ध में भी। इस साल आर्टिफिशियल इंटेलिजेंस के अनुप्रयोगों में इतनी प्रगति हुई है कि लगभग कोई भी एआई जनरेटर का उपयोग करके ऐसी तस्वीरें बना सकता है जो कम से कम पहली नज़र में तो वास्तविक लगें।

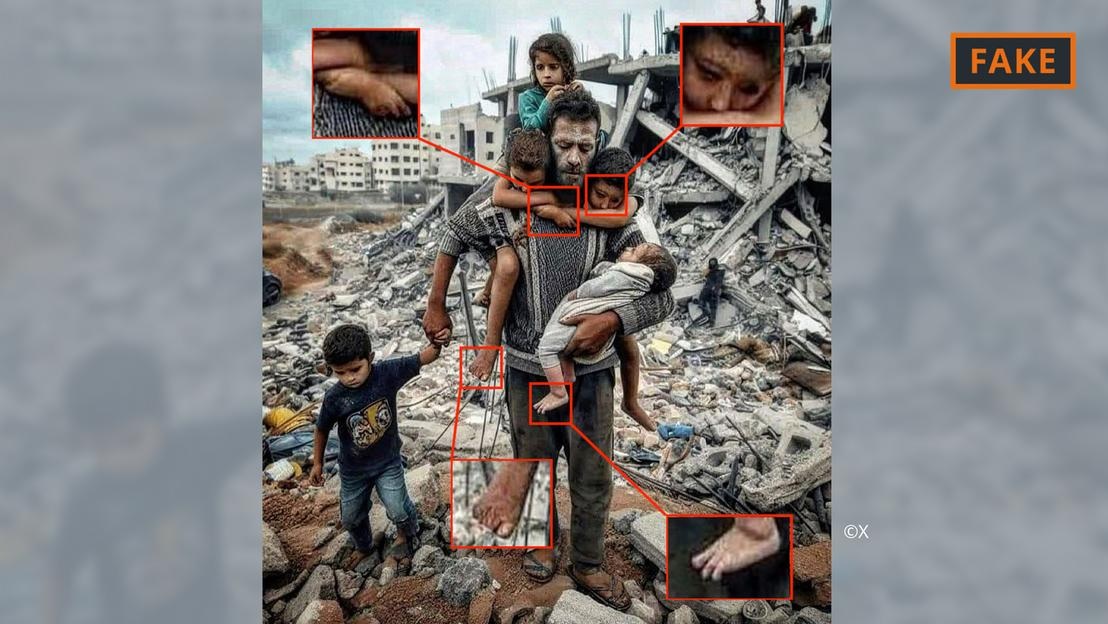

गाजा में युद्ध की एक कृत्रिम बुद्धि (AI) द्वारा निर्मित नकली तस्वीर।

इसके लिए, उपयोगकर्ता मिडजर्नी या डैल-ई जैसे टूल को कुछ संकेत, जैसे विनिर्देश और जानकारी, प्रदान करते हैं। फिर ये एआई टूल टेक्स्ट या यहाँ तक कि वॉइस संकेतों को इमेज में बदल देते हैं।

चित्र निर्माण की यह प्रक्रिया मशीन लर्निंग पर आधारित है। उदाहरण के लिए, अगर कोई निर्माता किसी 70 वर्षीय व्यक्ति को साइकिल चलाते हुए दिखाने के लिए कहता है, तो वे चित्रों से शब्दों का मिलान करने के लिए अपने डेटाबेस में खोज करेंगे।

उपलब्ध जानकारी के आधार पर, एआई एल्गोरिथम बुजुर्ग साइकिल चालक की एक छवि तैयार करेगा। अधिक से अधिक इनपुट और तकनीकी अपडेट के साथ, इन उपकरणों में काफी सुधार हुआ है और ये लगातार सीख रहे हैं।

यह सब मध्य पूर्व संघर्ष से जुड़ी तस्वीरों पर लागू हो रहा है। एआई विशेषज्ञ हनी फ़रीद कहते हैं कि ऐसे संघर्ष में जहाँ "भावनाएँ इतनी तीव्र होती हैं," एआई तस्वीरों के ज़रिए फैलाई गई गलत सूचना का बहुत बड़ा असर होता है।

बर्कले स्थित कैलिफोर्निया विश्वविद्यालय में डिजिटल एनालिटिक्स के प्रोफेसर फरीद ने कहा कि भयंकर लड़ाइयां, नकली सामग्री बनाने और प्रसारित करने के साथ-साथ भावनाओं को भड़काने के लिए आदर्श स्थान हैं।

इज़राइल-हमास युद्ध की AI छवियों के प्रकार

कृत्रिम बुद्धिमत्ता की मदद से बनाई गई छवियों और वीडियो ने यूक्रेन युद्ध से संबंधित गलत सूचनाओं को बढ़ावा दिया है, और इजरायल-हमास युद्ध में भी ऐसा ही हो रहा है।

विशेषज्ञों के अनुसार, सोशल मीडिया पर युद्ध से जुड़ी प्रसारित होने वाली एआई तस्वीरें अक्सर दो श्रेणियों में आती हैं। एक, लोगों की पीड़ा पर केंद्रित होती है और सहानुभूति जगाती है। दूसरी, नकली एआई जो घटनाओं को बढ़ा-चढ़ाकर पेश करती है, जिससे संघर्ष भड़कता है और हिंसा बढ़ती है।

गाजा में मलबे में पिता और बच्चे की एआई द्वारा बनाई गई नकली तस्वीर।

उदाहरण के लिए, पहली श्रेणी में मलबे के ढेर के सामने एक पिता और उसके पाँच बच्चों की ऊपर दी गई तस्वीर शामिल है। इसे एक्स (पहले ट्विटर) और इंस्टाग्राम पर कई बार शेयर किया गया और लाखों बार देखा गया।

इस छवि को समुदाय द्वारा, कम से कम X पर, नकली के रूप में चिह्नित किया गया है। इसे AI छवियों में आम तौर पर पाई जाने वाली विभिन्न त्रुटियों और विसंगतियों से पहचाना जा सकता है (ऊपर दी गई छवि देखें)।

इसी तरह की विसंगतियां नीचे दिए गए X पर वायरल हुई नकली AI छवि में भी देखी जा सकती हैं, जिसमें एक फिलिस्तीनी परिवार को खंडहरों पर एक साथ भोजन करते हुए दिखाया गया है।

फ़िलिस्तीनी पार्टी की AI-जनित नकली तस्वीर।

इस बीच, एक अन्य तस्वीर में सैनिकों को इजरायली झंडे लहराते हुए दिखाया गया है, जब वे बमबारी से तबाह हुए घरों से भरी एक बस्ती से गुजर रहे थे। यह दूसरी श्रेणी में आती है, जिसका उद्देश्य घृणा और हिंसा भड़काना है।

ऐसी एआई छवियां कहां से आती हैं?

संघर्ष की अधिकांश एआई-जनित छवियां सोशल मीडिया प्लेटफॉर्म पर पोस्ट की जाती हैं, लेकिन वे कई अन्य प्लेटफॉर्म और संगठनों और यहां तक कि कुछ समाचार साइटों पर भी उपलब्ध हैं।

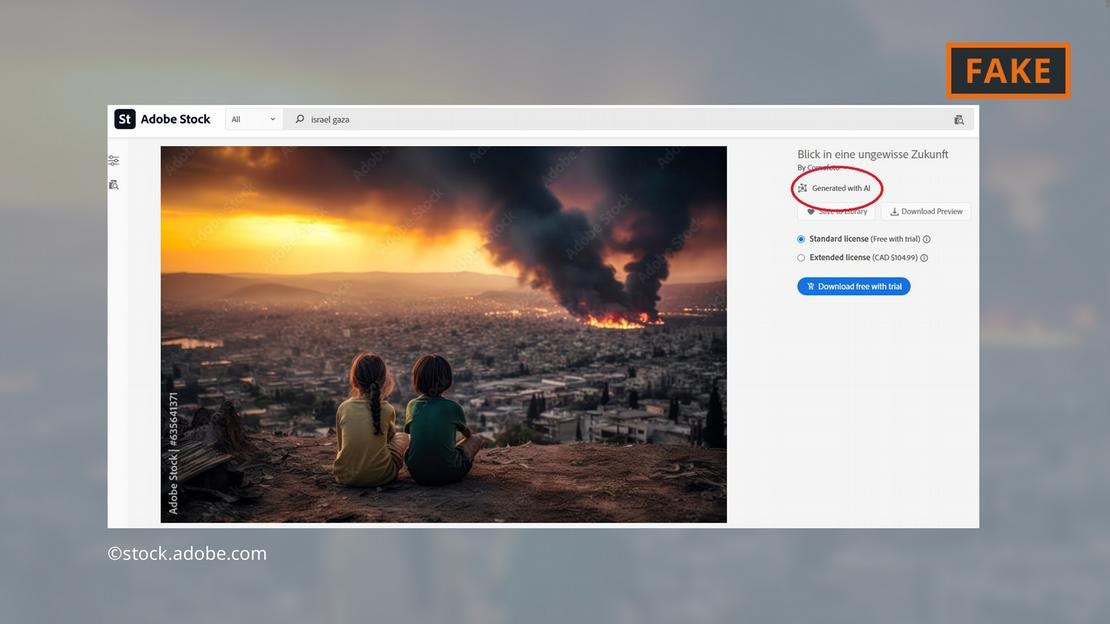

सॉफ्टवेयर कंपनी एडोब ने 2022 के अंत तक अपने स्टॉक फोटो रेंज में एआई-जनरेटेड इमेज जोड़कर सुर्खियां बटोरी हैं। डेटाबेस में उन्हें तदनुसार लेबल किया जाएगा।

एडोब अब मध्य पूर्व युद्ध की एआई छवियां भी बिक्री के लिए उपलब्ध करा रहा है - जैसे विस्फोट, विरोध प्रदर्शन करते लोग, या अल-अक्सा मस्जिद के पीछे धुएं का गुबार।

एडोब गाजा में लड़ाई की एआई-जनरेटेड छवियां पेश कर रहा है।

आलोचकों को यह बात परेशान करने वाली लगी, क्योंकि कुछ वेबसाइट्स ने इन तस्वीरों को एआई-जनरेटेड बताए बिना ही इस्तेमाल करना जारी रखा। उदाहरण के लिए, विवादित तस्वीर "न्यूज़ब्रेक" पेज पर बिना किसी संकेत के दिखाई गई कि यह एआई-जनरेटेड है।

यहां तक कि यूरोपीय संसद की वैज्ञानिक शाखा, यूरोपीय संसदीय अनुसंधान सेवा ने भी मध्य पूर्व संघर्ष के बारे में एक ऑनलाइन पाठ को एडोब डेटाबेस से एक एआई छवि के साथ चित्रित किया - बिना इसे एआई-जनित के रूप में लेबल किए।

यूरोपीय डिजिटल मीडिया वेधशाला ने पत्रकारों और मीडिया पेशेवरों से एआई छवियों का उपयोग करते समय अत्यधिक सावधानी बरतने का आग्रह किया है, तथा इनके उपयोग के विरुद्ध सलाह दी है, विशेष रूप से गाजा में युद्ध जैसी वास्तविक जीवन की घटनाओं को कवर करते समय।

एआई छवियां कितनी खतरनाक हैं?

वायरल एआई सामग्री और तस्वीरें उपयोगकर्ताओं को ऑनलाइन मिलने वाली हर चीज़ को लेकर असहज महसूस कराएँगी। यूसी बर्कले के शोधकर्ता फ़रीद बताते हैं, "अगर हम ऐसी दुनिया में पहुँच जाएँ जहाँ तस्वीरों, ऑडियो और वीडियो से छेड़छाड़ की जा सकती है , तो हर चीज़ संदिग्ध हो जाती है। इसलिए आप हर चीज़ पर, यहाँ तक कि सच्चाई पर भी, भरोसा खो देते हैं।"

निम्नलिखित मामले में ठीक यही हुआ: एक इजरायली बच्चे के जले हुए शव की तस्वीर इजरायल के प्रधानमंत्री बेंजामिन नेतन्याहू और कई अन्य राजनेताओं द्वारा सोशल मीडिया पर साझा की गई।

एक इज़राइल विरोधी प्रभावशाली व्यक्ति, जैक्सन हिंकल ने बाद में दावा किया कि यह तस्वीर कृत्रिम बुद्धिमत्ता का उपयोग करके बनाई गई थी। हिंकल के बयान को सोशल मीडिया पर 2 करोड़ से ज़्यादा बार देखा गया और इस पर प्लेटफ़ॉर्म पर गरमागरम बहस छिड़ गई।

अंततः, कई संगठनों और सत्यापन उपकरणों ने घोषित कर दिया कि तस्वीर असली थी और हिंकल का दावा झूठा था। हालाँकि, यह स्पष्ट है कि कोई भी उपकरण उपयोगकर्ताओं को उनका खोया हुआ विश्वास आसानी से वापस पाने में मदद नहीं कर सकता!

होआंग हाई (डीडब्ल्यू के अनुसार)

[विज्ञापन_2]

स्रोत

![डोंग नाई ओसीओपी संक्रमण: [अनुच्छेद 3] पर्यटन को ओसीओपी उत्पाद उपभोग से जोड़ना](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

टिप्पणी (0)