Para peneliti di DeepSeek telah mengumumkan model eksperimental baru yang disebut V3.2-exp, yang dirancang untuk mengurangi biaya inferensi secara signifikan saat digunakan dalam operasi konteks panjang.

DeepSeek mengumumkan model tersebut dalam sebuah posting di Hugging Face, dan juga memposting makalah akademis terkait di GitHub.

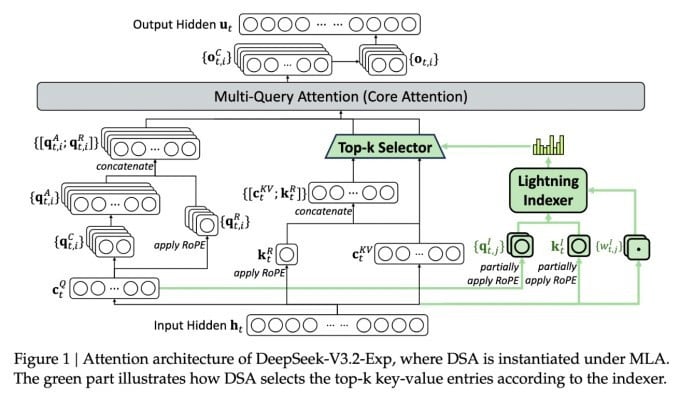

Fitur terpenting dari model baru yang kompleks ini disebut DeepSeek Sparse Attention. Pada dasarnya, sistem ini menggunakan modul yang disebut "lightning indexer" untuk memprioritaskan cuplikan tertentu dari jendela konteks.

DeepSeek mengumumkan model inferensi yang hemat biaya.

Sistem terpisah yang disebut "sistem pemilihan token berbutir halus" kemudian memilih token tertentu dari cuplikan tersebut untuk dimuat ke dalam jendela perhatian terbatas modul. Dengan demikian, model-model Perhatian Jarang dapat beroperasi pada konteks yang panjang dengan beban server yang relatif kecil.

Untuk operasi konteks panjang, manfaat sistem ini signifikan. Pengujian awal DeepSeek menunjukkan bahwa biaya pemanggilan fungsi inferensi (API) sederhana dapat dikurangi hingga setengahnya dalam skenario konteks panjang.

Pengujian lebih lanjut diperlukan untuk membangun penilaian yang lebih kuat, tetapi karena model tersebut terbuka dan tersedia secara bebas di Hugging Face, tidak akan lama lagi sebelum pengujian pihak ketiga dapat mengevaluasi klaim dalam makalah tersebut.

Tidak seperti model Chatbot AI lain yang mengonsumsi banyak energi, DeepSeek mengarah pada penghematan biaya mulai dari pelatihan hingga pengoperasian.

Model baru DeepSeek adalah salah satu dari serangkaian terobosan terkini yang mengatasi masalah biaya inferensi—pada dasarnya, biaya server untuk menjalankan model AI yang telah dilatih sebelumnya, dibandingkan dengan biaya pelatihannya.

Dalam kasus DeepSeek, para peneliti mencari cara untuk membuat arsitektur transformator dasar lebih efisien—dan menemukan bahwa perbaikan signifikan perlu dilakukan.

Berbasis di Tiongkok, DeepSeek merupakan sosok yang tidak biasa dalam tren AI, terutama bagi mereka yang menganggap riset AI sebagai kompetisi antara AS dan Tiongkok. Perusahaan ini membuat gebrakan awal tahun ini dengan model R1-nya, yang dilatih terutama menggunakan pembelajaran penguatan dengan biaya yang jauh lebih rendah daripada pesaingnya di AS.

Akan tetapi, model tersebut gagal memicu revolusi skala penuh dalam pelatihan AI seperti yang diprediksikan oleh beberapa orang, dan perusahaan tersebut perlahan-lahan mundur dari sorotan pada bulan-bulan berikutnya.

Pendekatan “perhatian jarang” yang baru ini kemungkinan besar tidak akan menimbulkan kemarahan sebesar R1 — tetapi pendekatan ini tetap dapat mengajarkan beberapa trik yang sangat dibutuhkan oleh penyedia layanan AS untuk membantu menjaga biaya inferensi tetap rendah.

https://techcrunch.com/2025/09/29/deepseek-merilis-model-perhatian-sparse-yang-memotong-biaya-API-hingga-setengahnya/

Sumber: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Foto] Lam Dong: Pemandangan panorama air terjun Lien Khuong yang mengalir seperti belum pernah terjadi sebelumnya](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F20%2F1763633331783_lk7-jpg.webp&w=3840&q=75)

![[Foto] Ketua Majelis Nasional Tran Thanh Man mengadakan pembicaraan dengan Ketua Majelis Nasional Korea Selatan Woo Won Shik](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F20%2F1763629724919_hq-5175-jpg.webp&w=3840&q=75)

![[Foto] Presiden Luong Cuong menerima Presiden Senat Republik Ceko Milos Vystrcil](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F20%2F1763629737266_ndo_br_1-jpg.webp&w=3840&q=75)

![[INFOGRAFIS] Lexar Armor Gold, "Tank Lapis Baja" dari desa kartu SD](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/21/1763705044474_thumb-the-sd-jpg.webp)

Komentar (0)