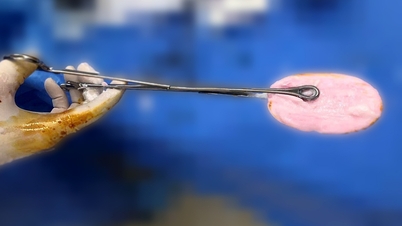

DeepSeak は、コードを書くだけでなく、コード自体の正しさをチェックして証明する AI モデルを開発しました。

DeepSeekMath-V2は、厳しい学術コンテストにおいて人間の記録を凌駕し、前例のないパフォーマンス記録を樹立しました。特筆すべきは、2025年国際数学オリンピック(IMO)で金メダルを獲得し、パトナム試験では118/120という驚異的なスコアを記録し、人間がこれまでに達成した最高得点90点を大きく上回る記録を打ち立てたことです。

しかし、このモデルを本当に画期的なものにしているのは、スコアではなく、DeepSeek の「自己検証」機能です。

DeepSeekの自己検証とエラー訂正メカニズム

長年にわたり、人工知能 (AI) モデルや大規模言語モデル (LLM) は、数学のような絶対的な論理を必要とする問題を解決する際に、「推論は間違っているが答えは正しい」という現象という重大な弱点に直面してきました。

つまり、モデルは正しい最終回答をランダムに生成する可能性がありますが、その結果に至った推論手順、数式、または論理手順のシーケンスは不正確、不完全、または幻覚的である可能性があります。

科学、工学、数学の分野において、正解であっても間違った解法では価値がなく、AIシステムの信頼性を著しく低下させます。DeepSeekMath-V2は、この信頼性の低さの時代を終わらせるために開発されました。

DeepSeekMath-V2の成功の核心は自己検証能力です。これはAIの思考プロセスにおける「内部監査」のような役割を果たします。単一の推論を行って答えを出力するだけでなく、DeepSeekMath-V2モデルは双方向のメカニズムを組み込んでいます。

1つ目は証明の役割で、モデルは議論と解決策の初期連鎖を生成します。その後、モデルは自動的に内部チェッカーシステムを起動し、生成された議論連鎖の各論理ステップをレビューして、エラー、矛盾、または不合理な飛躍がないか確認します。

このプロセスは、IMO-ProofBench評価システムの動作と非常によく似ています。1つのAIが議論を生成し、別のAIがそれを検証します。議論の連鎖が完全に確実であることが確認されるまで、このクロスチェックを繰り返すことで、DeepSeekMath-V2は答えが正しいだけでなく、その答えに至る経路も完全に正しく、透明性があることを保証します。

信頼できるAIの未来を切り開く

この自己検証型推論方法の影響は、現実世界のAI アプリケーションの透明性と信頼性の新たな基準を確立する可能性があります。

将来的には、このモデルは、AI がコードを書くだけでなく、自己チェックを行って正確性を証明し、重大なエラーを最小限に抑えるなど、他の重要な分野にも応用できます。

さらに、AI は仮説を立てたり新しい定理を証明したりするときに複雑な推論の連鎖を自動的に検証できるため、AI による重要な意思決定の合理性と安全性を確保できます。

DeepSeek がモデルのソースコードを Hugging Face や GitHub などのプラットフォームで公開するという決定は戦略的な動きであり、世界中の研究コミュニティがこの検証可能な推論原理にアクセスし、それに基づいて構築できるようにします。

DeepSeekMath-V2は、AIが最も困難な問題を解く優れた能力を示すだけでなく、その能力が信頼と揺るぎないロジックの基盤の上に構築されていることを実証する、飛躍的な進歩を象徴しています。これは、次世代のAIがより賢くなるだけでなく、思考プロセスにおいてより誠実で透明性のあるものになるということを証明しています。

出典: https://tuoitre.vn/deepseek-phat-trien-mo-hinh-co-kha-nang-tu-kiem-chung-cac-suy-luan-trong-toan-hoc-2025113016585069.htm

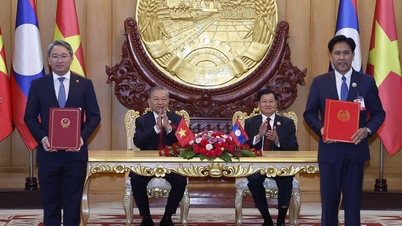

![[写真] ファム・ミン・チン首相がキューバのラテンアメリカ通信社の社長と会見](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F01%2F1764569497815_dsc-2890-jpg.webp&w=3840&q=75)

コメント (0)