|

AIはプログラミングにおいてまだ人間に取って代わっていません。写真:ジョン・マグワイア |

近年、OpenAIやAnthropicの主要なAIモデルがプログラミングアプリケーションでますます利用されるようになっています。ChatGPTとClaudeはメモリと処理能力を強化し、数百行のコードを分析できるようになりました。また、Geminiはプログラマー向けにCanvasによる結果表示機能を統合しました。

2024年10月、GoogleのCEOであるサンダー・ピチャイ氏は、同社の新規コードの25%をAIで生成すると述べました。MetaのCEOであるマーク・ザッカーバーグ氏も、コード生成AIモデルを社内に広く導入したいという意欲を示しています。

しかし、マイクロソフトの研究開発部門であるマイクロソフトリサーチによる新たな調査では、Anthropic の Claude 3.7 Sonnet や OpenAI の o3-mini などの AI モデルが、SWE-bench Lite と呼ばれるプログラミングテストベンチマークで多くのエラーを処理できなかったことが示されています。

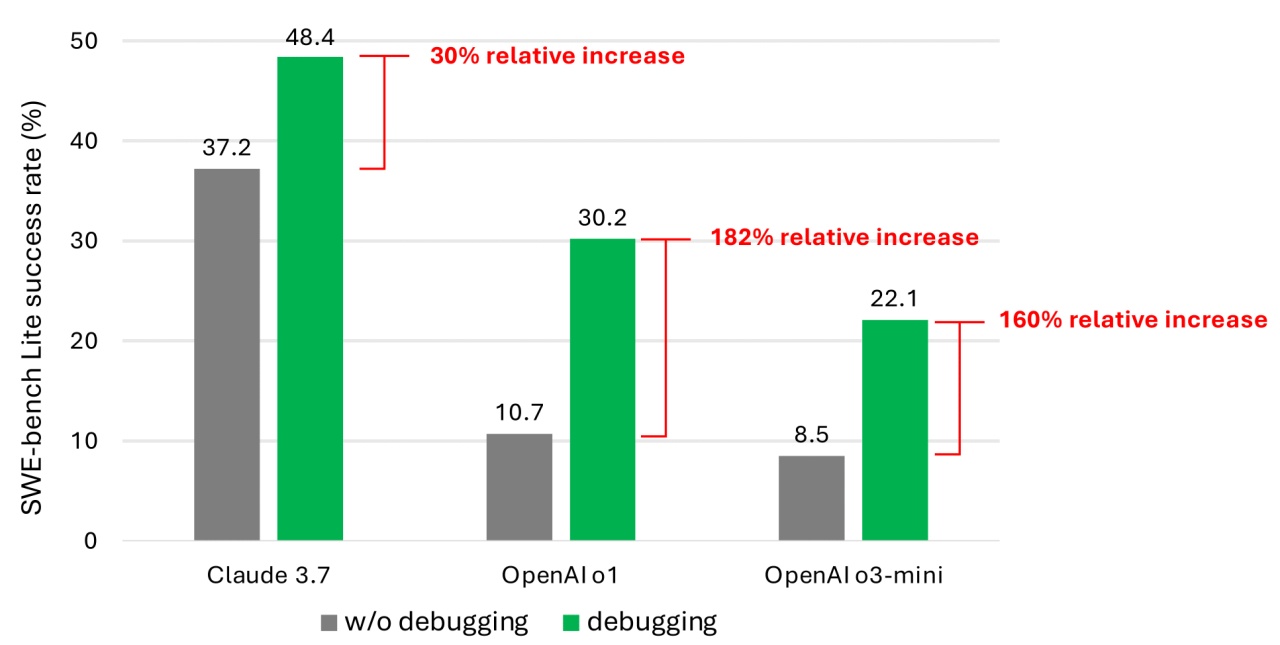

本研究の著者らは、Pythonデバッガーなどの様々なデバッグツールと統合された9つの異なるAIモデルをテストし、単一のステートメントで問題を解決できることを示しました。これらのモデルは、SWE-bench Liteデータセットから選択された300個のソフトウェアバグを解決するという課題を与えられました。

|

SWE-bench Liteデータセットのプログラミング問題を解く際の成功率。写真: Microsoft。 |

より新しく強力なモデルを搭載しても、AIエージェントが割り当てられたデバッグタスクの半分以上を正常に完了することは稀であることが結果で示されました。テスト対象モデルの中では、Claude 3.7 Sonnetが48.4%と最も高い平均成功率を達成し、次いでOpenAIのo1が30.2%、o3-miniが22.1%でした。

パフォーマンスが低い理由としては、一部のモデルが提供されているデバッグツールの適用方法を理解していないことが挙げられます。さらに、著者らによると、より大きな問題はデータの不足にあります。

彼らは、モデルを学習させるシステムには、人間が最初から最後まで行うデバッグ手順をシミュレートするデータがまだ不足していると主張している。言い換えれば、AIは実際のソフトウェアのバグに対処する際に人間がどのように考え、段階的に行動するかを十分に学習できていないのだ。

モデルを訓練し、微調整することで、ソフトウェアのデバッグ能力が向上するだろう。「しかし、そのためには特殊な訓練データセットが必要になるだろう」と著者らは述べている。

AIコード生成には、プログラミングロジックの理解能力の限界といった弱点により、セキュリティ上の脆弱性やエラーが発生することが、多くの研究で指摘されています。AIプログラミングツールであるDevinの最近のレビューでは、20個のプログラミングテストのうち3個しか完了していないことが判明しました。

AIのプログラミング能力は依然として議論の的となっている。以前、OpenAIの最高製品責任者であるケビン・ワイル氏は、今年末までにAIは人間のプログラマーを超えるだろうと述べていた。

一方、マイクロソフトの共同創業者であるビル・ゲイツは、プログラミングは将来も持続可能なキャリアであり続けると考えています。アムジャド・マサド(Replit CEO)、トッド・マッキノン(Okta CEO)、アルヴィンド・クリシュナ(IBM CEO)といった他のリーダーたちも、この見解への支持を表明しています。

マイクロソフトの研究は目新しいものではないが、マネージャーを含むプログラマーに対し、コーディングの完全な制御を AI に委ねる前にもっと慎重に考えるよう警告するものでもある。

出典: https://znews.vn/diem-yeu-chi-mang-cua-ai-post1545220.html

コメント (0)