テクノロジー大手は「多ければ多いほど良い」という信念のもと、人工知能(AI)に数十億ドルを費やしてきた。

しかし、DeepSeek の画期的な進歩は、より小さなモデルで、はるかに低いコストで同様のパフォーマンスを実現できることを示しています。

1月下旬、DeepSeekはR1モデルのトレーニングにかかる最終コストがわずか560万ドルで、米国企業が請求するコストのほんの一部に過ぎないと発表した。

「テクノロジー海賊」

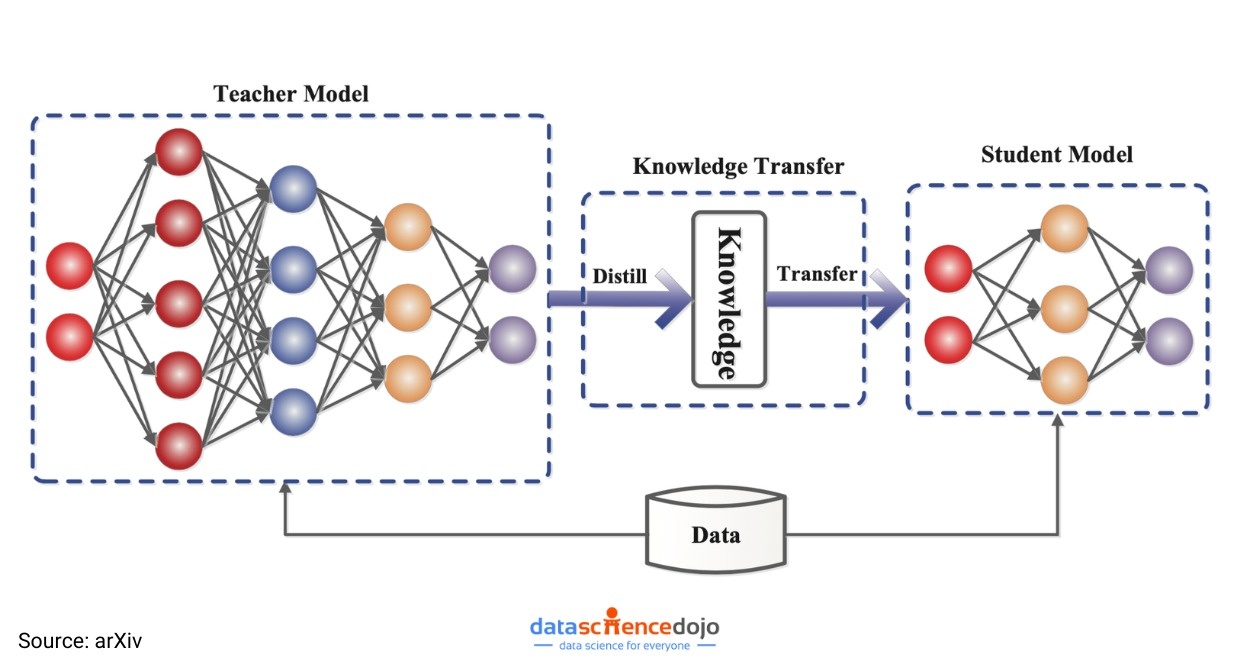

DeepSeekが大手AIメーカーの仲間入りを果たしたことで、シリコンバレーでは「蒸留」と呼ばれるプロセスに関する白熱した議論も巻き起こっている。

これは、数十万の質問をしてその答えを分析することで、新しいシステムが既存のシステムから学習する手法を指します。

蒸留を通じて、企業は「教師」モデルと呼ばれる大規模言語モデル(LLM)を取得し、文章中に現れる可能性が最も高い次の単語を予測できるようになります。

教師モデルはデータを生成し、それを用いてより小さな「生徒」モデルを学習させます。このプロセスにより、大規模なモデルから小規模なモデルへの知識と予測能力の迅速な転送が可能になります。

|

DeepSeekは、モデルのトレーニングに数十億ドルを費やす代わりに、「蒸留」技術を用いることで、既存の大規模なモデルから学習するだけで、同じ結果を達成できる。写真: Mint。 |

蒸留は長年にわたって広く利用されてきましたが、最近の進歩により、業界の専門家は、蒸留がDeepSeekのようなスタートアップ企業にとってますます大きな利点になると考えています。

OpenAI のような業界大手とは異なり、これらの企業は常に AI ベースのアプリケーションを開発するための費用対効果の高いソリューションを模索しています。

「蒸留は本当に魔法のようなものです。大規模でスマートなエッジモデルを取得し、それを用いてより小さなモデルを学習させるプロセスです。特定のタスクに対して非常に強力で、非常に安価で、非常に高速に実行できます」とOpenAIのプロダクトリーダー、オリヴィエ・ゴデメント氏は語る。

数十億ドルの資本の有効性に疑問符

OpenAI の GPT-4、Gemini (Google)、Llama (Meta) などの LLM は、開発と保守に膨大な量のデータと計算能力を必要とすることで有名です。

各社は正確なコストを公表していないが、こうしたモデルのトレーニングには数億ドルかかる可能性があると推定されている。

その中には、Google、OpenAI、Anthropic、そしてイーロン・マスクのxAIなどが含まれます。トランプ大統領就任後、OpenAIはソフトバンクをはじめとするパートナーと提携し、今後5年間でAIインフラに5,000億ドルを投資すると発表しました。

しかし、蒸留のおかげで、開発者や企業は大規模モデルの強力な機能をわずかなコストで利用できるようになります。これにより、AIアプリケーションをノートパソコンやスマートフォンなどのデバイスで高速に実行できるようになります。

|

AIモデルのトレーニングにおける「蒸留」手法のモデル。写真: arXiv。 |

実際、WSJ は、 DeepSeek の成功を受けて、シリコンバレーの経営幹部や投資家がビジネス モデルを見直し、業界リーダーとしての地位を維持する価値があるかどうか疑問視していると報じています。

「後続より8倍もコストがかかるのに、先頭に立つことに経済的価値があるのか?」と、ハナビ・キャピタルのベテラン技術幹部兼ベンチャーキャピタリスト、マイク・ボルピ氏は問う。

CIO は、今後数年間で「蒸留」手法を使用して作成される高品質の AI アプリケーションが多数登場することを期待しています。

具体的には、AI企業Hugging Faceの研究者たちが、DeepSeekに似たモデルの構築に取り組み始めています。「最も簡単に再現できるのは蒸留プロセスです」と、上級研究員のルイス・タンストール氏は述べています。

OpenAI と Google の AI モデルは、依然としてシリコンバレーで広く使用されているチャートをリードしています。

テクノロジー大手は、独創的な研究を行うことで、最先端のシステムにおいて優位性を維持しています。しかし、多くの消費者や企業は、多少劣る技術でもはるかに安い価格で妥協する傾向があります。

|

「蒸留」という手法自体は新しいアイデアではないが、DeepSeekの成功は、低コストのAIモデルでも数十億ドル規模のモデルと同等の効果を発揮できることを証明した。写真: Shutterstock |

蒸留によって適切に機能するモデルを作成できますが、多くの専門家は、蒸留には一定の限界があることも警告しています。

「蒸留には興味深いトレードオフが伴います。モデルを小さくすると、必然的にその機能も低下します」と、Microsoft ResearchのAhmed Awadallah氏は説明します。

Awadallah 氏によると、蒸留モデルは電子メールを要約するのに非常に優れていますが、同時に他のタスクにはあまり適していません。

一方、IBMリサーチのAIモデリング担当副社長デビッド・コックス氏は、ほとんどの企業は自社製品を稼働させるために巨大なモデルを必要としないと述べた。

蒸留モデルは現在、顧客サービス用のチャットボットなどの目的に使用したり、携帯電話などの小型デバイスで動作したりできるほど強力になっています。

「望ましいパフォーマンスを達成しながらコストを削減できるのであれば、それを行わない理由はない」とコックス氏は付け加えた。

出典: https://znews.vn/ky-thaut-chung-cat-ai-dang-dat-ra-cau-hoi-lon-post1535517.html

コメント (0)