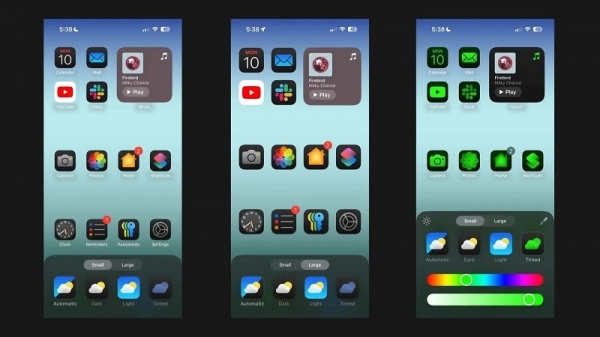

Volgens Android Authority beschrijft Apple's onderzoekspaper een oplossing voor het uitvoeren van grote taalmodellen (LLM's) op apparaten met beperkt RAM-geheugen. Het paper onthult hoe het bedrijf "modelparameters" kan opslaan en een deel ervan in het RAM-geheugen van het apparaat kan laden wanneer dat nodig is, in plaats van het hele model in het RAM-geheugen te laden.

Apple wil oudere iPhones met minder RAM helpen bij het uitvoeren van algemene AI

In het artikel wordt beweerd dat deze methode het mogelijk maakt om modellen te draaien die twee keer zoveel RAM nodig hebben als een iPhone, terwijl er toch nog steeds een 4-5x en 20-25x hogere inferentiesnelheid wordt gegarandeerd vergeleken met eenvoudige laadmethoden op respectievelijk de CPU en GPU.

Het implementeren van synthetische AI op een apparaat met meer RAM zou een enorm voordeel zijn, omdat het hogere lees- en schrijfsnelheden mogelijk zou maken. Snelheid is belangrijk voor AI op het apparaat zelf, wat zorgt voor veel snellere inferentietijden omdat gebruikers niet per se tientallen seconden (of meer) hoeven te wachten op een reactie of eindresultaat. Dit alles betekent dat een AI-assistent op het apparaat mogelijk op conversatiesnelheid zou kunnen werken, afbeeldingen/tekst veel sneller zou kunnen genereren, artikelen sneller zou kunnen samenvatten, enzovoort. Maar Apple's oplossing betekent dat gebruikers niet per se veel RAM nodig hebben om de responsiviteit van AI-taken op het apparaat te versnellen.

De aanpak van Apple zou het mogelijk kunnen maken dat zowel oude als nieuwe iPhones synthetische AI-functies direct op hun apparaten kunnen aanbieden. Dat is belangrijk, omdat Apples iPhones doorgaans minder RAM hebben dan high-end Android-telefoons. De iPhone 11-serie biedt bijvoorbeeld slechts 4 GB RAM, terwijl zelfs de reguliere iPhone 15 slechts 6 GB heeft.

Apple is niet het enige mobiele bedrijf dat werkt aan het verkleinen van LLM. De recente vlaggenschipchips van Qualcomm en MediaTek ondersteunen beide INT4-precisie om deze modellen te verkleinen. Hoe dan ook, bedrijven proberen nieuwe manieren te vinden om de systeemvereisten voor AI op het apparaat te verlagen, zodat zelfs low-end telefoons deze functie kunnen bieden.

Bronlink

![[Foto] Help mensen dringend om zo snel mogelijk een plek te vinden om te wonen en hun leven te stabiliseren](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F09%2F1765248230297_c-jpg.webp&w=3840&q=75)

![[Foto] Secretaris-generaal van Lam werkt samen met de vaste commissies van de subcommissies van het 14e partijcongres](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F09%2F1765253019536_a1-bnd-0983-4829-jpg.webp&w=3840&q=75)

Reactie (0)