Jeffrey McGregor, CEO van Truepic, zei dat het incident slechts het topje van de ijsberg was. "Er komt meer AI-gegenereerde content op sociale media en we zijn er niet klaar voor", aldus McGregor.

Volgens CNN wil Truepic dit probleem oplossen door technologie te bieden die claimt media te authenticeren op het moment dat ze via Truepic Lens worden gemaakt. De dataverzamelende app vertelt gebruikers de datum, tijd, locatie en het apparaat waarmee de afbeelding is gemaakt, en past een digitale handtekening toe om te verifiëren of de afbeelding natuurlijk is of door AI is gegenereerd.

Nepfoto van explosie op Pentagon gaat viraal op Twitter

Truepic, een door Microsoft gesteund bedrijf dat in 2015 werd opgericht, zegt dat er interesse is van NGO's tot mediabedrijven en zelfs verzekeraars die willen controleren of claims legitiem zijn.

McGregor zegt dat we niet meer weten wat de realiteit online is, nu alles nep kan zijn en kunstmatige intelligentie een hoogtepunt in kwaliteit en toegankelijkheid heeft bereikt.

Techbedrijven zoals Truepic zetten zich al jaren in om online desinformatie te bestrijden. Maar de opkomst van een nieuwe generatie AI-tools die op commando van de gebruiker afbeeldingen en tekst kunnen genereren, heeft de urgentie vergroot. Eerder dit jaar werden nepfoto's van paus Franciscus in een Balenciaga-donsjack en de arrestatie van voormalig Amerikaans president Donald Trump breed gedeeld. Beide incidenten hebben miljoenen mensen in verwarring gebracht over de potentiële gevaren van AI.

Sommige wetgevers roepen technologiebedrijven nu op om het probleem aan te pakken door AI-gegenereerde content te labelen. Vicevoorzitter van de Europese Commissie (EC) Vera Jourova zei dat bedrijven zoals Google, Meta, Microsoft en TikTok zich hebben aangesloten bij de vrijwillige gedragscode van de Europese Unie (EU) ter bestrijding van desinformatie.

Steeds meer startups en techgiganten, waaronder bedrijven die generatieve AI in hun producten implementeren, proberen standaarden en oplossingen te implementeren waarmee mensen kunnen vaststellen of een afbeelding of video met AI is gemaakt.

Maar aangezien AI-technologie sneller vordert dan mensen kunnen bijhouden, is het onduidelijk of deze oplossingen het probleem volledig kunnen oplossen. Zelfs OpenAI, het bedrijf achter Dall-E en ChatGPT, heeft toegegeven dat zijn eigen inspanningen om AI-gegenereerde teksten te detecteren, niet optimaal zijn.

Bedrijven die oplossingen ontwikkelen, benaderen het probleem op twee manieren. De eerste is gebaseerd op de ontwikkeling van programma's om door AI gegenereerde afbeeldingen te identificeren nadat ze online zijn gemaakt en gedeeld. De andere richt zich op het markeren van een afbeelding als echt of door AI gegenereerd met een soort digitale handtekening.

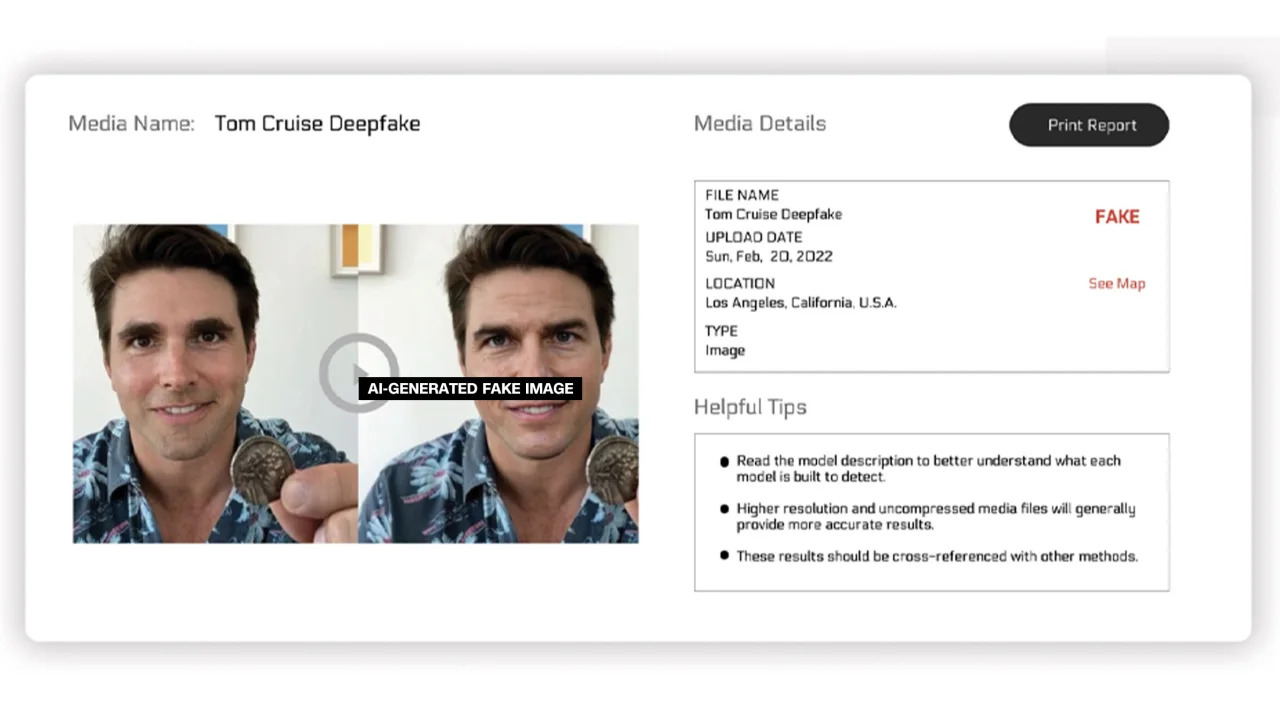

Reality Defender en Hive Moderation werken aan de eerste. Via hun platform kunnen gebruikers afbeeldingen uploaden om te laten scannen en vervolgens een percentage zien of de foto echt is of door AI is gegenereerd.

Reality Defender zegt dat het gebruikmaakt van gepatenteerde deepfake- en generatieve content fingerprinting-technologie om door AI gegenereerde video, audio en afbeeldingen te detecteren. In een voorbeeld dat het bedrijf aangaf, toonde Reality Defender een deepfake-afbeelding van Tom Cruise die voor 53% als "verdacht" werd beschouwd, omdat de persoon op de afbeelding een vervormd gezicht had, wat vaak te zien is op gemanipuleerde foto's.

Door AI gegenereerde gelabelde afbeeldingen

Deze diensten bieden zowel gratis als betaalde versies. Hive Moderation rekent $ 1,50 per 1000 afbeeldingen. Realty Defender zegt dat de prijzen kunnen variëren op basis van diverse factoren, in gevallen waarin klanten de expertise en ondersteuning van het bedrijf nodig hebben. Ben Colman, CEO van Reality Defender, zegt dat het risico elke maand verdubbelt, omdat iedereen met behulp van AI-tools nepfoto's kan maken.

Verschillende andere bedrijven werken aan het toevoegen van een soort label aan afbeeldingen om aan te geven of ze echt zijn of door AI gegenereerd. Tot nu toe is de inspanning grotendeels aangestuurd door de Content Authenticity and Origination Alliance (C2PA).

C2PA werd in 2021 opgericht om een technische standaard te creëren voor het certificeren van de oorsprong en geschiedenis van digitale media. Het combineert Adobe's Content Authentication Initiative (CAI) met Project Origin, onder leiding van Microsoft en de BBC, met als doel desinformatie in digitaal nieuws te bestrijden. Andere bedrijven die bij C2PA betrokken zijn, zijn Truepic, Intel en Sony.

Gebaseerd op de principes van C2PA zal CAI open-sourcetools vrijgeven waarmee bedrijven content credentials, oftewel metadata, kunnen creëren die informatie over afbeeldingen bevatten. Volgens de website van CAI stelt dit makers in staat om transparant details te delen over hoe ze een afbeelding hebben gemaakt. Zo krijgen eindgebruikers toegang tot de context rond wie, wat en hoe een afbeelding is bewerkt – en kunnen ze vervolgens zelf beoordelen hoe authentiek de afbeelding is.

Veel bedrijven hebben de C2PA-standaard en CAI-tools al in hun applicaties geïntegreerd. Adobe's Firefly, een nieuwe AI-imagingtool die aan Photoshop is toegevoegd, voldoet aan de C2PA-standaard via de Content Credentials-functie. Microsoft heeft ook aangekondigd dat afbeeldingen en video's die met Bing Image Creator en Microsoft Designer zijn gemaakt, in de komende maanden cryptografische handtekeningen zullen bevatten.

In mei kondigde Google de functie 'Over deze afbeelding' aan, waarmee gebruikers kunnen zien wanneer een afbeelding voor het eerst op Google verscheen en waar deze te zien is. De zoekgigant kondigde ook aan dat elke door Google AI gegenereerde afbeelding een markup in het originele bestand zal bevatten om 'context toe te voegen' als de afbeelding op een andere website of platform wordt gevonden.

Terwijl techbedrijven proberen de zorgen over door AI gegenereerde beelden en de integriteit van digitale media aan te pakken, benadrukken experts in de sector dat bedrijven met elkaar en met overheden moeten samenwerken om dit probleem aan te pakken. Toch zetten techbedrijven zich in om AI te ontwikkelen, ondanks de risico's.

Bronlink

![[Foto] Dan Mountain Ginseng, een kostbaar geschenk van de natuur aan het Kinh Bac-land](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F30%2F1764493588163_ndo_br_anh-longform-jpg.webp&w=3840&q=75)

Reactie (0)