Forskere ved DeepSeek har annonsert en ny eksperimentell modell kalt V3.2-exp, designet for å redusere kostnadene ved inferens betydelig når den brukes i lange kontekstoperasjoner.

DeepSeek annonserte modellen i et innlegg på Hugging Face, og publiserte også en lenket akademisk artikkel på GitHub.

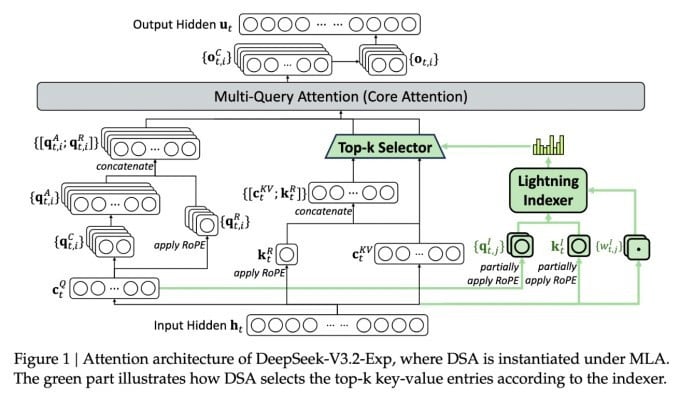

Den viktigste funksjonen i den komplekse nye modellen kalles DeepSeek Sparse Attention. Systemet bruker i hovedsak en modul kalt en «lightning indexer» for å prioritere spesifikke utdrag fra kontekstvinduet.

DeepSeek kunngjør kostnadseffektiv inferensmodell.

Et separat system kalt «finkornet tokenvalgssystem» velger deretter spesifikke tokens fra disse snippene som skal lastes inn i modulens begrensede oppmerksomhetsvindu. Kombinert lar de Sparse Attention-modeller operere på lange kontekstbiter med relativt liten serverbelastning.

For langkontekstoperasjoner er systemets fordeler betydelige. DeepSeeks foreløpige testing viser at kostnaden for et enkelt API-kall (inference function) kan reduseres med opptil halvparten i langkontekstscenarier.

Ytterligere testing er nødvendig for å bygge en mer robust vurdering, men siden modellen er åpen og fritt tilgjengelig på Hugging Face, bør det ikke ta lang tid før tredjepartstester kan evaluere påstandene i artikkelen.

I motsetning til andre AI Chatbot-modeller som bruker mye energi, går DeepSeek i retning av å spare kostnader fra opplæring til drift.

DeepSeeks nye modell er ett av en rekke nylige gjennombrudd som takler problemet med inferenskostnader – i hovedsak serverkostnaden ved å kjøre en forhåndstrent AI-modell, i motsetning til kostnaden ved å trene den.

I DeepSeeks tilfelle lette forskerne etter måter å gjøre den grunnleggende transformatorarkitekturen mer effektiv – og fant ut at det måtte gjøres betydelige forbedringer.

DeepSeek, som er basert i Kina, er en uvanlig figur i AI-manien, spesielt for de som ser på AI-forskning som en konkurranse mellom USA og Kina. Selskapet gjorde et plask tidligere i år med sin R1-modell, som primært ble trent ved hjelp av forsterkningslæring til en mye lavere kostnad enn sine amerikanske konkurrenter.

Modellen klarte imidlertid ikke å utløse den fullskala revolusjonen innen AI-opplæring som noen forutså, og selskapet trakk seg sakte tilbake fra rampelyset i månedene som fulgte.

Den nye tilnærmingen med «sparsom oppmerksomhet» vil sannsynligvis ikke forårsake like mye opprør som R1 – men den kan fortsatt lære amerikanske tjenesteleverandører noen sårt tiltrengte triks for å holde inferenskostnadene lave.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Kilde: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

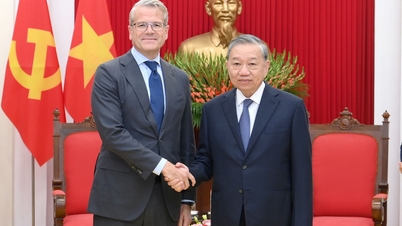

![[Foto] Generalsekretær To Lam mottar den slovakiske visestatsministeren og forsvarsministeren Robert Kalinak](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/18/1763467091441_a1-bnd-8261-6981-jpg.webp)

Kommentar (0)