Per oktober hadde mer enn 200 store språkmodeller (LLM-er) blitt lansert av kinesiske selskaper og forskningsinstitutter, noe som førte til en hard «kamp» i verdens nest største økonomi .

Konkurranse er nødvendig for å fremme innovasjon, men i den spesifikke konteksten til Beijing ville den raske økningen i antall LLM-er være et enormt sløsing med ressurser.

Kinas overfylte AI-marked hemmes av manglende tilgang til avanserte brikker, strenge myndighetsreguleringer om sensitive emner, høye utviklingskostnader og et dypt fragmentert teknologimarked.

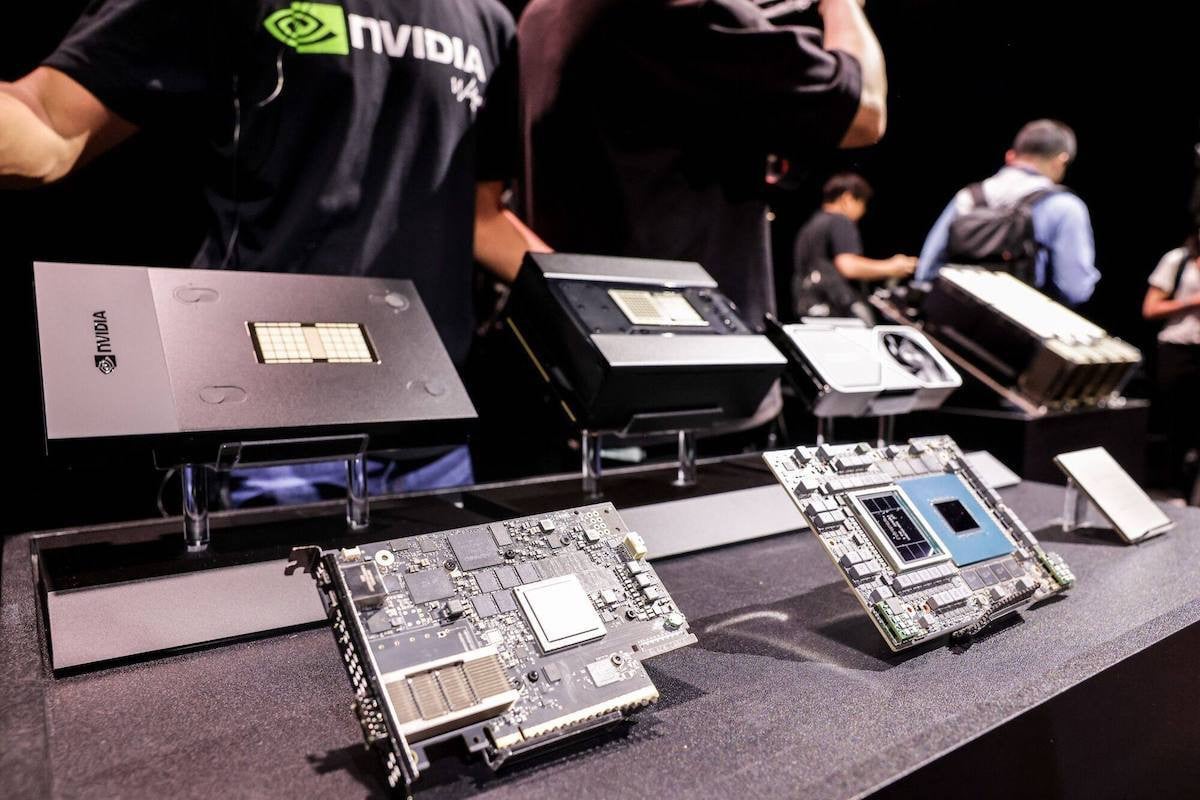

Mangel på datakraft

«Kina står overfor mange utfordringer i utviklingen av LLM ettersom teknologigapet med Vesten øker på grunn av fremveksten av GPT og Googles Gemini», sa Su Lian Jye, sjefsanalytiker hos Omdia.

Den største utfordringen er mangelen på tilgang til avanserte grafikkprosessorer (GPU-er) fra Nvidia på grunn av amerikanske handelssanksjoner. Disse GPU-ene, som Nvidias H100, regnes som hjertet i de nyeste LLM-ene, og bestemmer i stor grad hvor kraftig modellen er.

En måned før OpenAI lanserte GPT, innførte Washington et nasjonalt sikkerhetsforbud mot Beijings tilgang til avanserte brikker som Nvidias H100 og A100. Et år senere strammet den amerikanske regjeringen ytterligere inn restriksjonene på Kina-spesifikke prosessorer som A800 og H800, og truet med å forby alle fremtidige alternativer.

Wang Shuyi, professor som spesialiserer seg i AI og maskinlæring ved Tianjin Normal University, sa at utilstrekkelig datakraft er en av hovedhindringene for utviklingen av AI-modeller i Kina.

«Det vil bli stadig vanskeligere for Kina å få tilgang til avanserte brikker», sa Wang. «Kinesiske selskaper mangler ikke penger, men uten datakraft vil de ikke kunne utnytte datakilder av høy kvalitet fullt ut.»

Og siden innenlandske selskaper fortsatt henger etter i chipproduksjon, er det usannsynlig at Kina vil overvinne disse begrensningene med det første.

Stort sløsing med ressurser

Robin Li Yanhong, medgründer og administrerende direktør i søkemotorgiganten Baidu, sa at det å lansere flere konkurrerende LLM-er i Kina er et «enormt sløsing med ressurser», og at selskaper burde fokusere mer på applikasjoner.

Wang Xiaochuan, administrerende direktør i AI-oppstartsbedriften Baichuan, sa på et Tencent-teknologiforum i Beijing at flere selskaper burde avstå fra å trene sine egne modeller og «i stedet fokusere innsatsen på å finne kommersielt levedyktige og skalerbare AI-produkter ved å utnytte eksisterende modeller gjennom skyen».

I mellomtiden vurderte Luo Yuchen, administrerende direktør i Shenzhen Yantu Intelligence and Innovation, at «selv om ingen plattform har blitt dominerende når det gjelder teknologi eller markedsstørrelse for øyeblikket», bør modellutviklingen «fortsette fordi selv GPT-4 kanskje ikke er god nok til å hjelpe selskaper med å løse daglige oppgaver som håndteres av mennesker».

Begrenset datakvalitet fra det mandarinbaserte internettet sammenlignet med den engelsktalende verden kan også være hindringer for Beijings ambisjoner om å bli et AI-kraftverk, ifølge Omdias Su Lian Jye.

Forskjellene i språkstrukturen mellom engelsk og kinesisk, kombinert med politisk sensitivitet mellom Kina og Vesten, betyr at det er et klart skille mellom det innenlandske og globale markedet for AI-chatbot-svar.

(Ifølge SCMP)

AI-revolusjonen skjer i Kina

I 2020 dominerte Kina 7 av 10 strategiske industrier

Kinas stålindustri på den «grønne veien»

[annonse_2]

Kilde

![[Foto] Statsminister Pham Minh Chinh mottar FNs generalsekretær António Guterres](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/25/1761390212729_dsc-1484-jpg.webp)

![[Foto] Formannen for nasjonalforsamlingen, Tran Thanh Man, mottar FNs generalsekretær António Guterres](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/25/1761390815792_ctqh-jpg.webp)

![[Foto] Statsminister Pham Minh Chinh og FNs generalsekretær António Guterres deltar på pressekonferansen under signeringsseremonien for Hanoi-konvensjonen.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/25/1761391413866_conguoctt-jpg.webp)

![[Foto] Generalsekretær To Lam møter generalsekretær og president i Laos, Thongloun Sisoulith](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/25/1761380913135_a1-bnd-4751-1374-7632-jpg.webp)

Kommentar (0)