Atakuj z każdej strony.

Google wprowadził na rynek nowy produkt oparty na sztucznej inteligencji (AI) o nazwie „Gemini Nano Banana”. Nie jest to wielkoskalowa sztuczna inteligencja lingwistyczna (LLM) zdolna do pisania i rozumowania, lecz raczej sztuczna inteligencja specjalizująca się w edycji zdjęć... Wielu użytkowników jest podekscytowanych tym narzędziem, ale niesie ono ze sobą również szereg wad.

„To jak krok wstecz w technologii sztucznej inteligencji i ograniczeniach etycznych” – powiedział Nguyen Hong Phuc, dyrektor naukowy Conductify AI, wyrażając swoją osobistą opinię. „Gemini Nano Banana oferuje skuteczne możliwości edycji obrazu. Jednak odcenzurowanie Gemini Nano Banana przez Google, rozluźnienie barier i mechanizmów ograniczających, pozwala tej sztucznej inteligencji tworzyć obrazy, które są niezwykle podobne do celebrytów, obrazy sugestywne, obrazy o charakterze wrażliwym itp.” – powiedział Phuc.

Zdaniem pana Nguyen Hong Phuc, dzięki tej funkcji Gemini Nano Banana staje się narzędziem do tworzenia realistycznych, fałszywych obrazów, których nawet eksperci od sztucznej inteligencji nie potrafią odróżnić. To z kolei wiąże się z nowymi zagrożeniami w zakresie oszustw i cyberzagrożeń. Przykładami takich działań są tworzenie fałszywych zdjęć znanych polityków w celu rozpowszechniania fałszywych informacji, a nawet narażanie osób na manipulację zdjęciami i zniesławienie w mediach społecznościowych przy użyciu sztucznej inteligencji.

Co więcej, wraz z dziesiątkami innych narzędzi do edycji zdjęć opartych na sztucznej inteligencji, które podbijają internet, oszustwa deepfake nie mają zamiaru ustać. Statystyki organizacji bezpieczeństwa pokazują, że technologia deepfake generuje kampanie phishingowe wymierzone w wartościowe osoby, zwłaszcza liderów biznesu. W 2024 roku odnotowano 140 000–150 000 takich przypadków na całym świecie, z czego 75% dotyczyło prezesów i kadry kierowniczej wyższego szczebla... Deepfake może zwiększyć globalne straty gospodarcze o 32%, czyli około 40 miliardów dolarów rocznie do 2027 roku.

Niedawno firma Anthropic, zajmująca się sztuczną inteligencją, wykryła i udaremniła kampanię cyberataków przeprowadzoną przez zagranicznych hakerów, w której po raz pierwszy odnotowano wykorzystanie sztucznej inteligencji do koordynowania zautomatyzowanych działań atakowych. Hakerzy wykorzystali systemy sztucznej inteligencji do planowania, kierowania i wdrażania operacji włamaniowych – to „niepokojące” zjawisko, które grozi zwiększeniem skali i szybkości kampanii cyberataków…

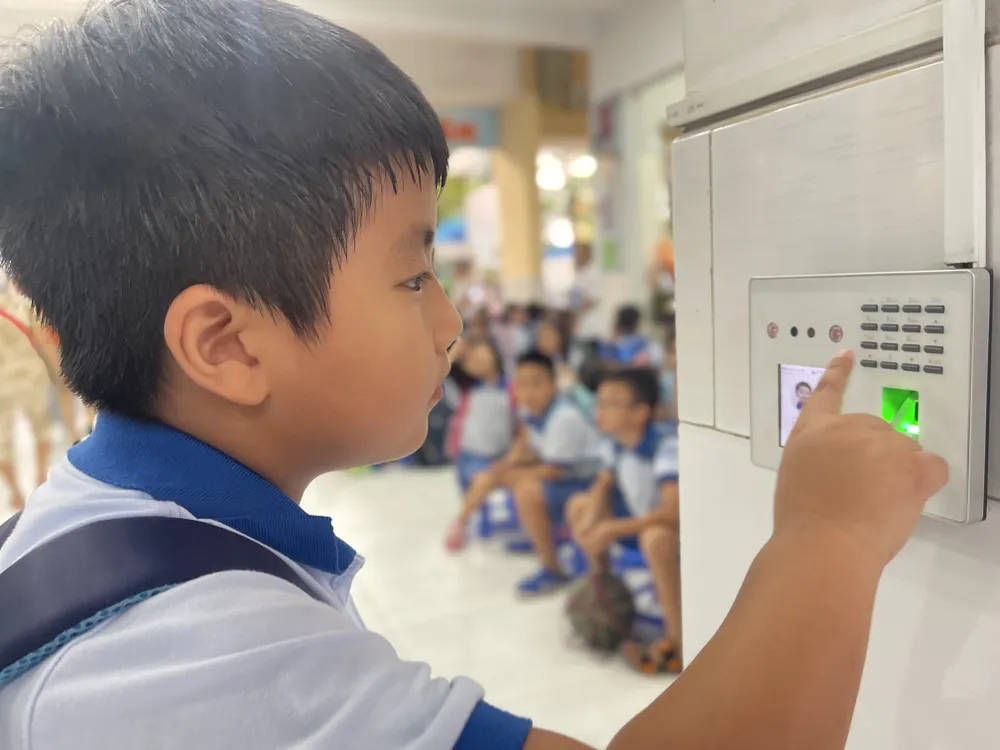

Pan Ngo Minh Hieu, dyrektor organizacji antyfraudowej National Cybersecurity Association, powiedział, że narzędzia zintegrowane ze sztuczną inteligencją (AI) zwiększają szybkość oszustw około 20-krotnie w porównaniu z wykorzystaniem prawdziwych ludzi. Oszuści dostarczają sztucznej inteligencji scenariusz oszustwa do analizy, a system natychmiast automatycznie nawiązuje kontakt z ofiarami. Na podstawie danych początkowych AI może zrozumieć, czego chce ofiara i komunikować się z nią w czasie rzeczywistym. Najbardziej wyrafinowaną taktyką jest atak „Man-in-the-Middle”, w którym gdy użytkownik dokonuje uwierzytelnienia wideo (np. nagrywa swoją twarz lub wydaje polecenia), haker interweniuje, aby zakłócić przesyłane dane. Cyberprzestępcy następnie wstawiają wstępnie przygotowane filmy deepfake, zastępując prawdziwy strumień danych użytkownika, aby ominąć proces uwierzytelniania. Dzięki tej metodzie systemy bezpieczeństwa banków i instytucji finansowych również są narażone na oszustwa.

Lepsze zarządzanie danymi

Wraz ze wzrostem popularności sztucznej inteligencji (AI), znacząco rosną również zagrożenia dla bezpieczeństwa i prywatności. Dane przechowywane i przetwarzane na zdalnych serwerach staną się atrakcyjnym celem dla hakerów i cyberprzestępców. Według danych National Cyber Security Association, w samym drugim kwartale 2025 roku liczba cyberataków z wykorzystaniem AI wzrosła o 62%, powodując globalne straty sięgające 18 miliardów dolarów...

Eksperci uważają, że ochrona danych jest kluczowa. Jednak gromadzenie i sprzedaż danych jest nadal jawna na wielu platformach „czarnego rynku”, za jedyne 20 dolarów miesięcznie. Cyberprzestępcy mogą korzystać z narzędzi, które naśladują modele językowe, ale są dostosowane do celów przestępczych. Narzędzia te potrafią generować złośliwe oprogramowanie, a nawet omijać programy antywirusowe.

W Wietnamie dekret nr 13/2023/ND-CP (obowiązujący od 17 kwietnia 2023 r.) reguluje ochronę danych osobowych. Ponadto ustawa o ochronie danych osobowych, która ma wejść w życie 1 stycznia 2026 r., stworzy silniejszy mechanizm prawny w celu ograniczenia ryzyka wycieku i niewłaściwego wykorzystania danych osobowych. Jednak, według Narodowego Stowarzyszenia Cyberbezpieczeństwa, skuteczność egzekwowania prawa nadal wymaga wzmocnienia w trzech filarach: podniesieniu świadomości społecznej, zwiększeniu odpowiedzialności korporacyjnej oraz poprawie zdolności przetwarzania danych przez organy regulacyjne. Poza środkami technicznymi, każda osoba musi rozwinąć umiejętność rozpoznawania nietypowych i podejrzanych sygnałów oraz proaktywnie chronić się przed niebezpiecznymi interakcjami cyfrowymi…

Firma Kaspersky ostrzega przed wykorzystaniem Dark AI (termin ten odnosi się do wdrażania dużych modeli językowych (LLM), które działają poza standardowymi mechanizmami bezpieczeństwa, często umożliwiając działania takie jak phishing, manipulacja, cyberataki lub nadużycia danych). Organizacje i osoby prywatne muszą przygotować się na coraz bardziej wyrafinowane i trudne do wykrycia cyberataki ze względu na rosnącą popularność Dark AI w regionie Azji i Pacyfiku.

Siergiej Łożkin, szef Globalnego Zespołu Badań i Analiz (GReAT) na regiony Bliskiego Wschodu, Turcji, Afryki i Azji i Pacyfiku w firmie Kaspersky, dodał, że jednym z przejawów obecnych nadużyć sztucznej inteligencji (AI) jest pojawienie się modeli GPT (Black Hat GPT). Są to modele AI specjalnie opracowane lub zmodyfikowane w celu realizacji nieetycznych i nielegalnych celów, takich jak tworzenie złośliwego oprogramowania, tworzenie płynnych i przekonujących wiadomości e-mail phishingowych na potrzeby ataków na dużą skalę, tworzenie deepfake'ów, głosów i filmów, a nawet wspieranie symulowanych ataków.

Eksperci firmy Kaspersky zalecają osobom prywatnym i firmom korzystanie z rozwiązań bezpieczeństwa nowej generacji w celu wykrywania złośliwego oprogramowania generowanego przez sztuczną inteligencję, przy jednoczesnym priorytetowym traktowaniu ochrony danych. Firmy powinny wdrożyć narzędzia do monitorowania w czasie rzeczywistym, aby śledzić wykorzystywanie luk w zabezpieczeniach przez sztuczną inteligencję; wzmocnić kontrolę dostępu i szkolić pracowników, aby ograniczyć wykorzystanie sztucznej inteligencji w „ciemnej strefie” i ryzyko wycieku danych; a także utworzyć centrum operacji cyberbezpieczeństwa w celu monitorowania zagrożeń i szybkiego reagowania na incydenty.

Źródło: https://www.sggp.org.vn/bao-mat-du-lieu-thoi-ai-post824210.html

![[Zdjęcie] Członek Stałego Komitetu Centralnego Partii Tran Cam Tu przedstawia decyzję o mianowaniu Sekretarza Komitetu Partyjnego Narodowej Akademii Politycznej Ho Chi Minha.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2026%2F02%2F02%2F1770039902160_le-cong-bo-bt-hvctqg-11-7880-jpg.webp&w=3840&q=75)

![OCOP w okresie Tet: [Część 3] Ultracienki papier ryżowy zyskuje popularność.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F402x226%2Fvietnam%2Fresource%2FIMAGE%2F2026%2F01%2F28%2F1769562783429_004-194121_651-081010.jpeg&w=3840&q=75)

Komentarz (0)