W połowie grudnia Meta rozpoczęła integrację chatbota opartego na sztucznej inteligencji o nazwie Meta AI z aplikacją Messenger w Wietnamie i udostępniła go bezpłatnie wszystkim użytkownikom. Narzędzie to wykorzystuje model językowy Llama 3.2, obsługuje język wietnamski, umożliwia wyszukiwanie informacji, tworzenie obrazów i czatowanie.

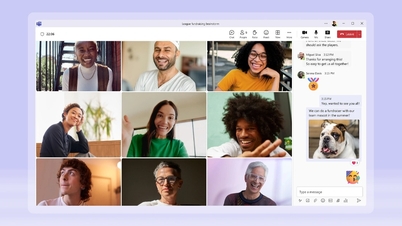

Niedługo potem wielu użytkowników w Wietnamie odkryło, że Meta AI miała poważny błąd w tworzeniu obrazu. Po wpisaniu słowa kluczowego „czarny pies” chatbot zwracał wynik przedstawiający ciemnoskórego mężczyznę lub chłopca z kręconymi włosami. Po wpisaniu wietnamskiego słowa kluczowego „obraz czarnego psa” Meta AI również zwracała podobne wyniki.

Meta AI rysująca osoby kolorowe, podczas gdy polecenie wymaga innej treści, to poważny problem

31 grudnia przedstawiciel Meta w Wietnamie oficjalnie zabrał głos w sprawie incydentu. Firma potwierdziła istnienie wspomnianego problemu i ogłosiła jego rozwiązanie. Jednocześnie Meta Vietnam przeprosiła za incydent i poinformowała, że problem ten może wystąpić w innych istniejących systemach generatywnej sztucznej inteligencji.

„Przepraszamy za ten błąd. Meta wprowadza zabezpieczenia do naszych funkcji i modeli sztucznej inteligencji, aby zapewnić wszystkim bezpieczniejsze i przyjemniejsze korzystanie z serwisu. Jednak, podobnie jak inne generatywne systemy sztucznej inteligencji, ten model może zwracać niedokładne lub obraźliwe treści, dlatego zachęcamy użytkowników do odpowiedzialnego korzystania z tych narzędzi” – powiedział przedstawiciel firmy.

Po pewnym czasie użytkowania, Meta AI jest wysoko ceniona przez wielu użytkowników za możliwość płynnego reagowania na potrzeby języka. Funkcja tworzenia obrazu zapewnia również dobrą jakość w porównaniu z modelem udostępnianym bezpłatnie. Przyczyną może być również fakt, że Meta wykorzystuje treści publikowane na Facebooku jako dane wejściowe w procesie szkolenia AI, co pomaga temu narzędziu w wyrażaniu i wykonywaniu naturalnych poleceń.

Jednak incydenty takie jak rasizm czy reakcje niezgodne ze standardami wyznaczonymi dla sztucznej inteligencji są nadal trudne do uniknięcia. Meta twierdzi, że testuje swoją sztuczną inteligencję z ekspertami w dziedzinie sztucznej inteligencji za pomocą testów „Red Teaming”, aby zidentyfikować niezamierzone zastosowania, które następnie są rozwiązywane w ramach procesu ciągłego doskonalenia.

Source: https://thanhnien.vn/meta-xin-loi-vi-su-co-ai-ve-con-cho-da-den-185241231104908626.htm

![[Zdjęcie] Sekretarz generalny To Lam przyjął delegację uczestniczącą w międzynarodowej konferencji poświęconej studiom wietnamskim](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761456527874_a1-bnd-5260-7947-jpg.webp)

![[Zdjęcie] Premier Pham Minh Chinh i Sekretarz Generalny ONZ Antonio Guterres uczestniczą w konferencji prasowej z okazji podpisania Konwencji Hanoi](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/25/1761391413866_conguoctt-jpg.webp)

![[Zdjęcie] Premier Pham Minh Chinh uczestniczy w otwarciu 47. szczytu ASEAN](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761452925332_c2a-jpg.webp)

![[Zdjęcie] Przewodniczący Zgromadzenia Narodowego Tran Thanh Man przyjmuje Sekretarza Generalnego ONZ Antonio Guterresa](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/25/1761390815792_ctqh-jpg.webp)

Komentarz (0)