Atacar por todos os ângulos.

O Google lançou um novo produto de inteligência artificial (IA) chamado "Gemini Nano Banana", que não é uma IA linguística (LLM) em larga escala capaz de escrever e raciocinar, mas sim uma IA especializada em edição de fotos... Muitos usuários estão entusiasmados com essa ferramenta, mas ela também apresenta algumas desvantagens.

“É como um ‘passo para trás’ na tecnologia de IA e nas limitações éticas”, disse Nguyen Hong Phuc, Diretor Científico da Conductify AI, expressando sua opinião pessoal. “O Gemini Nano Banana tem recursos eficazes de edição de imagens. Mas a liberação da censura pelo Google ao Gemini Nano Banana, afrouxando as barreiras e os mecanismos de limitação, permite que essa IA crie imagens incrivelmente semelhantes a celebridades, imagens sugestivas, imagens sensíveis, etc.”, afirmou Phuc.

Segundo o Sr. Nguyen Hong Phuc, essa capacidade torna o Gemini Nano Banana uma ferramenta para criar imagens falsas realistas, a ponto de nem mesmo especialistas em IA conseguirem distingui-las, o que acarreta novos riscos de fraude e segurança cibernética, como a criação de fotos falsas com políticos famosos para disseminar informações falsas, e até mesmo indivíduos sendo submetidos à manipulação de fotos geradas por IA e difamação nas redes sociais...

Além disso, com dezenas de outras ferramentas de edição de fotos com IA dominando a internet, os golpes com deepfakes não mostram sinais de arrefecimento. Estatísticas de organizações de segurança demonstram que a tecnologia deepfake cria campanhas de phishing direcionadas a indivíduos de alto valor, especialmente líderes empresariais. Em 2024, houve entre 140.000 e 150.000 casos em todo o mundo, com 75% deles visando CEOs e executivos seniores... Os deepfakes podem aumentar as perdas econômicas globais em 32%, aproximadamente US$ 40 bilhões por ano até 2027.

Recentemente, a empresa de IA Anthropic detectou e frustrou uma campanha de ciberataques realizada por hackers estrangeiros, registrando pela primeira vez o uso de IA para coordenar atividades de ataque automatizadas. Especificamente, os hackers utilizaram sistemas de IA para planejar, dirigir e executar operações de intrusão – um desenvolvimento “preocupante” que corre o risco de ampliar a escala e a velocidade das campanhas de ciberataques…

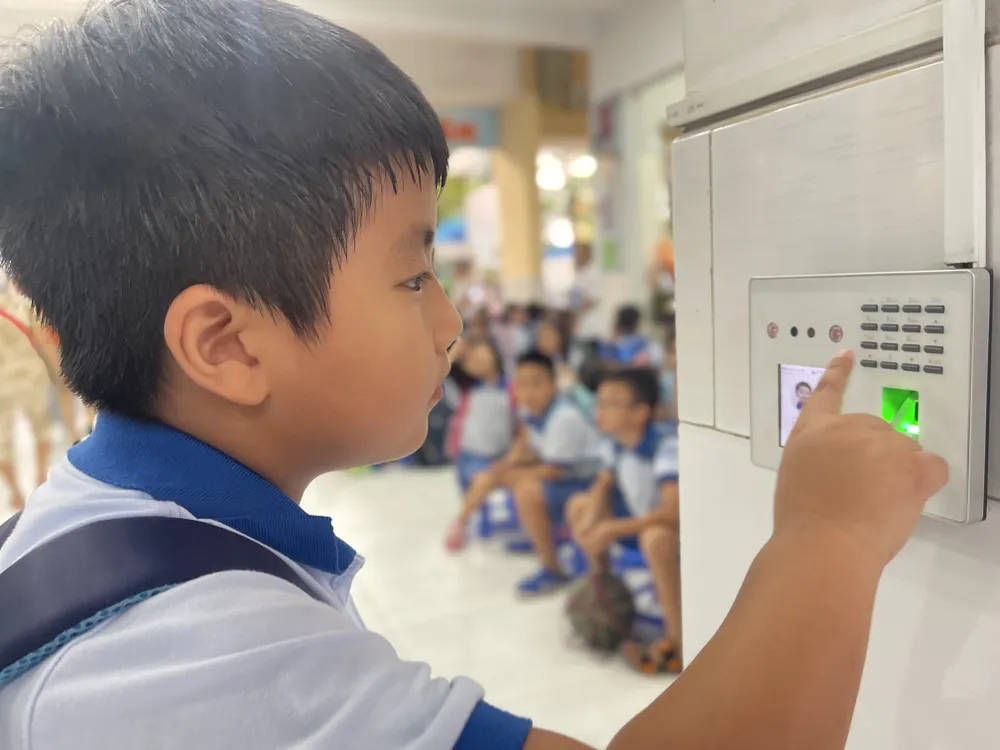

O Sr. Ngo Minh Hieu, Diretor da Organização Antifraude da Associação Nacional de Segurança Cibernética, afirmou que as ferramentas integradas com IA aumentam a velocidade das fraudes em cerca de 20 vezes em comparação com o uso de pessoas reais. Os fraudadores fornecem à IA um cenário de fraude para análise, e o sistema imediatamente inicia uma conversa automática com as vítimas. A partir dos dados iniciais, a IA consegue entender o que a vítima deseja e se comunicar com ela em tempo real. A tática mais sofisticada é o ataque "Homem no Meio", no qual, quando um usuário realiza autenticação por vídeo (como gravar o rosto ou dar comandos), o hacker intervém para interferir nos dados transmitidos. Os cibercriminosos inserem vídeos deepfake pré-fabricados, substituindo o fluxo de dados real do usuário para burlar o processo de autenticação. Com esse método, os sistemas de segurança de bancos e instituições financeiras também correm o risco de serem enganados.

Melhor gestão de dados

Com a crescente prevalência da IA, os riscos à segurança e à privacidade também aumentam significativamente. Os dados armazenados e processados em servidores remotos se tornarão um alvo atraente para hackers e cibercriminosos. De acordo com dados da Associação Nacional de Segurança Cibernética (NCSA), somente no segundo trimestre de 2025, o número de ataques cibernéticos impulsionados por IA aumentou 62%, causando prejuízos globais de até US$ 18 bilhões.

Especialistas acreditam que a proteção de dados é crucial. No entanto, a coleta e venda de dados continuam ocorrendo abertamente em muitas plataformas do "mercado negro", por valores tão baixos quanto US$ 20 por mês. Criminosos cibernéticos podem usar ferramentas que imitam modelos de linguagem, mas são personalizadas para fins criminosos. Essas ferramentas são capazes de gerar malware e até mesmo burlar softwares antivírus.

No Vietnã, o Decreto nº 13/2023/ND-CP (em vigor desde 17 de abril de 2023) regulamenta a proteção de dados pessoais. Além disso, a Lei de Proteção de Dados Pessoais, com previsão de entrada em vigor em 1º de janeiro de 2026, criará um mecanismo legal mais robusto para lidar com o risco de vazamentos e uso indevido de dados pessoais. No entanto, segundo a Associação Nacional de Segurança Cibernética, a eficácia da aplicação da lei ainda precisa ser aprimorada em três pilares: conscientização pública, aumento da responsabilidade corporativa e melhoria da capacidade de processamento dos órgãos reguladores. Além das medidas técnicas, cada indivíduo precisa desenvolver a capacidade de identificar sinais incomuns e suspeitos e se proteger proativamente de interações digitais perigosas.

A Kaspersky alertou sobre a exploração da IA Sombria (um termo que se refere à implantação de grandes modelos de linguagem (LLMs) que operam fora dos controles de segurança padrão, muitas vezes permitindo ações como phishing, manipulação, ataques cibernéticos ou abuso de dados). Organizações e indivíduos precisam se preparar para enfrentar ataques cibernéticos cada vez mais sofisticados e difíceis de detectar devido ao crescimento da IA Sombria na região da Ásia-Pacífico.

Sergey Lozhkin, chefe da Equipe Global de Pesquisa e Análise (GReAT) para o Oriente Médio, Turquia, África e Ásia-Pacífico da Kaspersky, afirmou que uma das manifestações do atual abuso de IA é o surgimento de modelos Black Hat GPT. Esses modelos de IA são especificamente desenvolvidos ou modificados para fins antiéticos e ilegais, como a criação de malware, a elaboração de e-mails de phishing fluentes e persuasivos para ataques em larga escala, a criação de vozes e vídeos deepfake e até mesmo o suporte a ataques simulados.

Especialistas da Kaspersky recomendam que indivíduos e empresas utilizem soluções de segurança de última geração para detectar malware gerado por IA, priorizando também a proteção de dados. As empresas devem implementar ferramentas de monitoramento em tempo real para rastrear a exploração de vulnerabilidades impulsionadas por IA; fortalecer o controle de acesso e o treinamento de funcionários para limitar a IA na zona escura e o risco de vazamento de dados; e estabelecer um centro de operações de cibersegurança para monitorar ameaças e responder rapidamente a incidentes.

Fonte: https://www.sggp.org.vn/bao-mat-du-lieu-thoi-ai-post824210.html

Comentário (0)