Um grupo de renomados especialistas internacionais se reuniu em Pequim na semana passada, onde identificaram "linhas vermelhas" no desenvolvimento da IA, incluindo a criação de armas biológicas e a realização de ataques cibernéticos.

Em um comunicado divulgado dias após a reunião, os acadêmicos alertaram que uma abordagem comum para a segurança da IA é necessária para evitar "riscos catastróficos ou mesmo existenciais para a humanidade em nossas vidas".

“No auge da Guerra Fria, a cooperação internacional entre governos e cientistas ajudou a evitar uma catástrofe nuclear. A humanidade deve, mais uma vez, trabalhar em conjunto para evitar a catástrofe que pode surgir de uma tecnologia sem precedentes”, dizia o comunicado.

Especialistas presentes no Diálogo Internacional sobre Segurança da IA, em Pequim, identificaram "linhas vermelhas" no desenvolvimento da IA. Foto: FT

Entre os signatários estão Geoffrey Hinton e Yoshua Bengio, frequentemente descritos como os "pais" da IA; Stuart Russell, professor de ciência da computação na Universidade da Califórnia; e Andrew Yao, um dos cientistas da computação mais proeminentes da China.

A declaração surge após o Diálogo Internacional sobre Segurança da IA, realizado em Pequim na semana passada, uma reunião que contou com a presença de autoridades do governo chinês para expressar sua aprovação ao fórum e seus resultados.

O presidente dos EUA, Joe Biden, e o presidente chinês, Xi Jinping, se reuniram em novembro do ano passado e discutiram a segurança da IA, concordando em estabelecer um diálogo sobre o assunto. Empresas líderes globais em IA também se reuniram em particular com especialistas chineses em IA nos últimos meses.

Em novembro de 2023, 28 países, incluindo a China, e empresas líderes em IA concordaram com um amplo compromisso de trabalhar em conjunto para abordar os riscos existenciais decorrentes da IA avançada durante a cúpula de segurança de IA do Ministro das Finanças do Reino Unido, Rishi Sunak.

Na semana passada, em Pequim, especialistas discutiram as ameaças associadas ao desenvolvimento da "Inteligência Artificial Geral - IAG", ou seja, sistemas de IA iguais ou superiores aos humanos.

“O foco principal da discussão foram as linhas vermelhas que nenhum sistema de IA poderoso deveria ultrapassar e que os governos de todo o mundo deveriam impor no desenvolvimento e na implementação da IA”, disse Bengio.

Essas diretrizes garantiriam que “nenhum sistema de IA possa se replicar ou se aprimorar sem o consentimento e suporte explícitos de humanos” ou “tomar medidas que aumentem indevidamente seu poder e influência”.

Os cientistas acrescentaram que nenhum sistema "aumentaria significativamente a capacidade dos agentes de projetar armas de destruição em massa, violar a Convenção sobre Armas Biológicas ou Químicas" ou seria capaz de "realizar automaticamente ataques cibernéticos que resultem em sérias perdas financeiras ou danos equivalentes".

Hoang Hai (de acordo com o FT)

Fonte

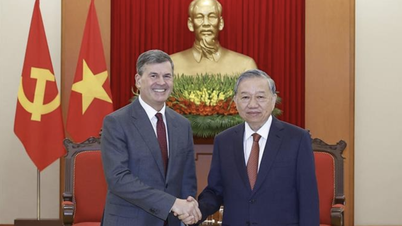

![[Foto] O Secretário-Geral To Lam recebe o Diretor da Academia de Administração Pública e Economia Nacional junto à Presidência da Federação Russa.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F08%2F1765200203892_a1-bnd-0933-4198-jpg.webp&w=3840&q=75)

Comentário (0)