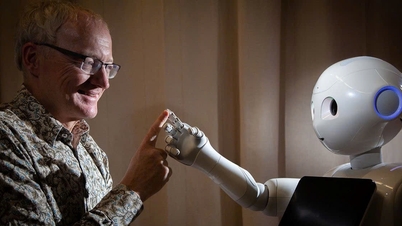

Raportul OpenAI din octombrie a constatat că actorii cibernetici la nivel global integrează în principal inteligența artificială (IA) în canalele de atac existente pentru a îmbunătăți performanța, în loc să dezvolte instrumente sau metode de atac complet noi.

Conform OpenAI, o mare parte din activitatea detectată a implicat utilizarea inteligenței artificiale pentru a ajuta la sarcini familiare precum dezvoltarea de programe malware, construirea infrastructurii de control, crearea de e-mailuri de phishing mai sofisticate și colectarea de informații despre ținte.

„Echipele blocate încorporau în mare parte inteligența artificială în procesele existente, în loc să construiască procese noi bazate pe inteligență artificială”, se arată în raport.

Raportul a constatat, de asemenea, că multe grupuri de utilizatori au utilizat modele lingvistice mari (LLM) pentru a extrage cunoștințe într-o varietate de domenii tehnice, de la dezvoltarea de aplicații la configurarea sistemelor de rețea, adesea într-un mod care specializează fiecare cont pentru o anumită sarcină.

Mai multe alte rețele de utilizatori au fost identificate ca utilizând platforme de inteligență artificială pentru a genera conținut online, inclusiv articole, imagini și videoclipuri , pentru a derula campanii media sau a promova anumite puncte de vedere. Cu toate acestea, majoritatea acestor conturi sunt ineficiente, cu niveluri de implicare foarte scăzute.

În plus, OpenAI a înregistrat și fenomenul centrelor de fraudă și al infractorilor cibernetici care utilizează ChatGPT pentru a sprijini activitățile de fraudă online în Myanmar și Cambodgia. Unele cazuri arată că IA este utilizată nu doar pentru editarea conținutului, ci și pentru gestionarea programului de lucru, a resurselor umane și a finanțelor.

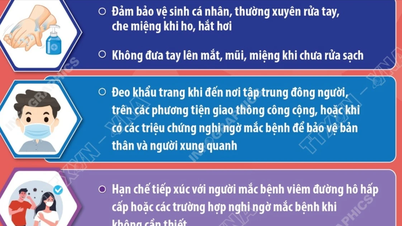

Cu toate acestea, OpenAI observă că inteligența artificială este utilizată în mod activ și pentru prevenirea fraudei. Se estimează că ChatGPT este utilizat de trei ori mai des pentru a identifica și evita escrocheriile decât pentru a comite fraude.

Majoritatea cererilor rău intenționate sunt respinse de sistem, dar raportul notează că există încă o „zonă gri” în care cererile tehnice sau bazate pe cercetare pot fi exploatate în scopuri neintenționate.

Cu toate acestea, OpenAI afirmă că codul sau conținutul creat nu este rău intenționat până când nu este utilizat în mod abuziv în afara platformei.

(TTXVN/Vietnam+)

Sursă: https://www.vietnamplus.vn/openai-canh-bao-tin-tac-loi-dung-ai-de-hoat-dong-tinh-vi-hon-post1068941.vnp

![[Foto] Lângă „muntele de gunoi” de după inundații, locuitorii din Tuy Hoa se străduiesc să-și reconstruiască viața](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F24%2F1763951389752_image-1-jpg.webp&w=3840&q=75)

Comentariu (0)