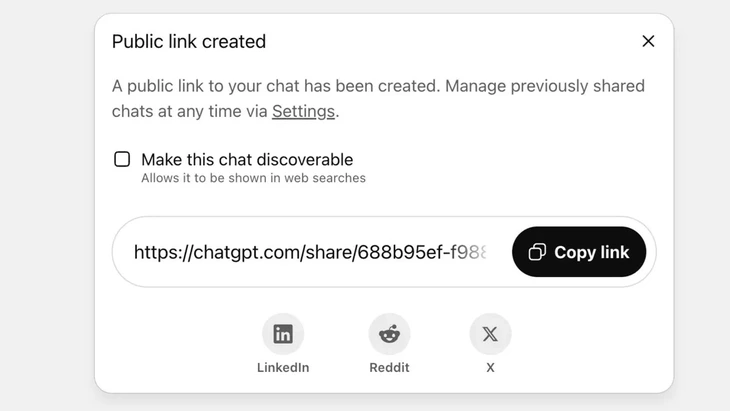

Возможность делиться чатами через публичную ссылку на ChatGPT — Фото: Techradar

В настоящее время ChatGPT обрабатывает более 2,5 миллиардов запросов от пользователей по всему миру ежедневно, что свидетельствует о растущей популярности этого чат-бота.

Однако этот инструмент столкнулся с резкой негативной реакцией пользователей, поскольку функция «поделиться» привела к утечке конфиденциальной информации из тысяч разговоров в Google и некоторые другие поисковые системы в Интернете.

Высокий риск безопасности

Г-н Ву Нгок Сон, глава технологического департамента Национальной ассоциации кибербезопасности (NCA), оценил, что вышеуказанный инцидент демонстрирует высокий уровень риска безопасности для пользователей ChatGPT.

«Вышеупомянутый инцидент не обязательно является технической ошибкой, поскольку пользователь проявил инициативу, нажав кнопку «Поделиться». Однако можно сказать, что проблема кроется в конструкции чат-бота на основе искусственного интеллекта, который вводит пользователей в заблуждение, а меры предупреждения о риске утечки персональных данных при обмене информацией недостаточны», — проанализировал г-н Ву Нгок Сон.

В ChatGPT эта функция реализуется после того, как пользователь решает поделиться чатом через публичную ссылку, контент будет сохранен на сервере OpenAI как публичный веб-сайт (chatgpt.com/share/...), для доступа не требуется логин или пароль.

Роботы Google автоматически сканируют и индексируют эти страницы, благодаря чему они появляются в результатах поиска, включая конфиденциальный текст, изображения или данные чата.

Многие пользователи не осознавали риска, полагая, что делятся чатом с друзьями или знакомыми. Это привело к утечке тысяч переписок, в некоторых случаях содержащих конфиденциальную личную информацию.

Хотя OpenAI быстро удалила эту функцию в конце июля 2025 года после негативной реакции сообщества, всё равно потребовалось время на согласование с Google удаления старых индексов. Учитывая сложную систему хранения данных, включающую кеш-серверы Google, это невозможно сделать быстро.

Не относитесь к чат-ботам на основе искусственного интеллекта как к «черному ящику безопасности»

Эксперт по безопасности данных Ву Нгок Сон — руководитель отдела технологий Национальной ассоциации кибербезопасности (NCA) — Фото: CHI HIEU

Утечка тысяч журналов чатов может представлять опасность для пользователей, например, раскрытие личных и деловых секретов, ущерб репутации, финансовые риски или даже угрозу безопасности из-за раскрытия домашних адресов.

«Чат-боты с поддержкой искусственного интеллекта полезны, но не являются «черным ящиком», поскольку общие данные могут существовать в сети вечно, если их не проверять.

Вышеупомянутый инцидент, безусловно, является уроком как для поставщиков, так и для пользователей. Другие поставщики услуг ИИ могут извлечь уроки из этого опыта и разработать функции с более чёткими и прозрачными предупреждениями.

«В то же время пользователям также необходимо заблаговременно ограничивать неконтролируемую публикацию идентифицирующей или личной информации на платформах ИИ», — рекомендовал эксперт по безопасности Ву Нгок Сон.

По мнению экспертов по безопасности данных, вышеупомянутый инцидент демонстрирует необходимость разработки правовых коридоров и стандартов кибербезопасности для ИИ. Поставщикам и разработчикам ИИ также необходимо разрабатывать системы, обеспечивающие безопасность, предотвращая риск утечки данных, такой как: утечка через серьёзные уязвимости; уязвимости программного обеспечения, приводящие к атакам на базы данных; слабый контроль, приводящий к отравлению данных; злоупотребления для ответов на ложные и искажённые вопросы.

Пользователям также необходимо контролировать передачу персональных данных ИИ, не передавая конфиденциальную информацию. В случае реальной необходимости рекомендуется использовать анонимный режим или активное шифрование информации, чтобы избежать прямой привязки данных к конкретным лицам.

Источник: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Фото] «Кладбище кораблей» в заливе Сюань-Дай](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[Видео] Памятники Хюэ вновь открываются для посетителей](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Комментарий (0)