Сложная картина использования роботов-убийц с искусственным интеллектом

Предоставление ИИ возможности управлять системами вооружения может означать, что цели будут идентифицироваться, атаковаться и уничтожаться без участия человека. Это поднимает серьёзные правовые и этические вопросы.

Подчеркивая серьезность ситуации, министр иностранных дел Австрии Александр Шалленберг заявил: «Это момент Оппенгеймера нашего поколения».

Роботы и оружие с искусственным интеллектом начинают широко использоваться в армиях многих стран. Фото: Forbes

Действительно, вопрос о том, в какой степени «джинн вырвался из бутылки», стал насущным, поскольку беспилотники и искусственный интеллект (ИИ) стали широко использоваться военными по всему миру .

«Использование беспилотников в современных конфликтах Россией и Украиной, использование беспилотников США в операциях по нанесению целевых ударов в Афганистане и Пакистане и, как было недавно объявлено в прошлом месяце, в рамках израильской программы Lavender, показывает, как возможности обработки информации с помощью ИИ активно используются армиями по всему миру для усиления их наступательной мощи», — сказал военный аналитик GlobalData Уилсон Джонс.

Расследования, проведённые лондонским Управлением военной журналистики, показали, что израильская военная система искусственного интеллекта Lavender с точностью 90% идентифицировала лиц, связанных с ХАМАС, то есть 10% не были таковыми. Это привело к гибели мирных жителей из-за возможностей ИИ по идентификации и принятию решений.

Угроза глобальной безопасности

Такое использование ИИ подчеркивает необходимость управления технологиями в системах вооружения.

«Использование ИИ в системах вооружения, особенно при наведении на цель, поднимает фундаментальные вопросы о нас, людях, и нашем отношении к войне , и, в частности, о наших предположениях о том, как мы можем использовать насилие в вооруженных конфликтах», — объяснил изданию Army Technology доктор Александр Бланшар, старший научный сотрудник программы «Управление искусственным интеллектом» в Стокгольмском международном институте исследований проблем мира (СИПРИ), независимой исследовательской группе, занимающейся глобальной безопасностью.

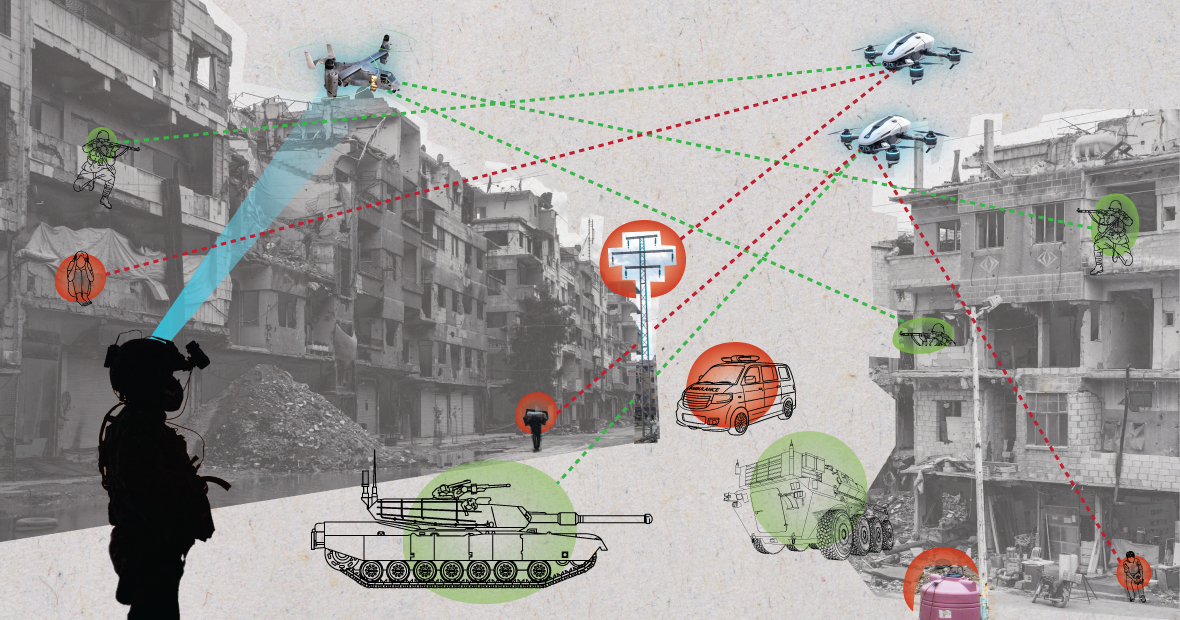

Системы искусственного интеллекта при использовании в хаотичной обстановке могут вести себя непредсказуемо и не всегда точно идентифицировать цели. Фото: МЧС

«Меняет ли ИИ способ, которым военные выбирают цели и применяют к ним силу? Эти изменения, в свою очередь, поднимают множество правовых, этических и оперативных вопросов. Наибольшие опасения вызывают гуманитарные вопросы», — добавил доктор Бланшар.

«Многие обеспокоены тем, что, в зависимости от того, как спроектированы и используются автономные системы, они могут подвергнуть гражданских лиц и других лиц, защищённых международным правом, большему риску причинения вреда», — пояснил эксперт СИПРИ. «Это связано с тем, что системы ИИ, особенно при использовании в хаотичных условиях, могут действовать непредсказуемо и могут неточно идентифицировать цели и атаковать гражданских лиц, а также не идентифицировать комбатантов, не участвующих в боевых действиях».

Аналитик по вопросам обороны GlobalData Уилсон Джонс, комментируя этот вопрос, отметил, что вопрос о том, как определяется виновность, может оказаться спорным.

«Согласно действующим законам войны, существует концепция ответственности командира», — сказал г-н Джонс. «Это означает, что офицер, генерал или другой руководитель несёт юридическую ответственность за действия войск, находящихся под его командованием. Если войска совершают военные преступления, офицер несёт ответственность, даже если он не отдавал приказов; бремя доказывания лежит на нём, он должен доказать, что сделал всё возможное для предотвращения военных преступлений».

«С системами искусственного интеллекта это усложняет ситуацию. Кто несёт ответственность: IT-специалист? Разработчик системы? Неясно. Если это неясно, это создаёт моральный риск, если субъекты считают, что их действия не защищены действующим законодательством», — подчеркнул г-н Джонс.

Американский солдат патрулирует территорию с роботом-собакой. Фото: Forbes

Конвенции о контроле над вооружениями. Несколько крупных международных соглашений ограничивают и регулируют определённые виды применения оружия. Существуют запреты на химическое оружие, договоры о нераспространении ядерного оружия и Конвенция о конкретных видах обычного оружия, которая запрещает или ограничивает применение конкретных видов оружия, которые, как считается, причиняют излишние или неоправданные страдания воюющим сторонам или неизбирательно затрагивают гражданское население.

«Для контроля над ядерными вооружениями потребовались десятилетия международного сотрудничества и последующих договоров», — объясняет военный аналитик Уилсон Джонс. «Даже тогда мы продолжали испытания в атмосфере до 1990-х годов. Одной из главных причин успеха ядерного нераспространения было сотрудничество между Соединёнными Штатами и Советским Союзом в рамках биполярного миропорядка. Сейчас этого больше не существует, и технологии, создающие ИИ, для многих стран более доступны, чем ядерная энергетика».

«Обязательный договор должен был бы посадить всех заинтересованных игроков за стол переговоров и договориться не использовать инструмент, увеличивающий их военную мощь. Это вряд ли сработает, поскольку ИИ может повысить военную эффективность с минимальными финансовыми и материальными затратами».

Текущая геополитическая перспектива

Хотя страны — члены Организации Объединенных Наций признали необходимость ответственного военного использования ИИ, предстоит еще многое сделать.

«Без чёткой нормативно-правовой базы эти заявления остаются в основном пустыми словами», — заявила изданию Army Technology Лаура Петроне, главный аналитик GlobalData. «Неудивительно, что некоторые страны хотят сохранить свой суверенитет при принятии решений по вопросам внутренней обороны и национальной безопасности, особенно в нынешних геополитических условиях».

Г-жа Петроне добавила, что, хотя Закон ЕС об ИИ устанавливает некоторые требования к системам ИИ, он не распространяется на системы ИИ военного назначения.

«Я считаю, что, несмотря на это исключение, Закон об ИИ — это важная попытка создать давно назревшую рамочную основу для применения ИИ, которая может привести к определённому единообразию соответствующих стандартов в будущем», — отметила она. «Такое единообразие будет важно и для применения ИИ в военной сфере».

Нгуен Кхань

Источник: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

Комментарий (0)