ในบทสัมภาษณ์กับ The Guardian ผู้เขียนหนังสือ “Sapiens: A Brief History of Humankind” กล่าวว่า ปัญหาที่เกิดจากโมเดล AI นั้นไม่ได้จำกัดอยู่แค่สถานการณ์ใหญ่ๆ เพียงสถานการณ์เดียว ไม่เหมือนกับอาวุธนิวเคลียร์

ด้วย AI จึงมีสถานการณ์อันตรายมากมายนับไม่ถ้วน โดยแต่ละสถานการณ์อาจรวมกันเป็นหนึ่งและก่อให้เกิดภัยคุกคามต่อการดำรงอยู่ของอารยธรรมมนุษย์ได้

ปฏิญญาพหุภาคีที่การประชุมสุดยอดความปลอดภัย AI ระดับโลกที่ Bletchley Park สหราชอาณาจักร ถือเป็น "ก้าวสำคัญอย่างยิ่ง" เนื่องจาก รัฐบาล ชั้นนำมารวมตัวกันเพื่อแสดงความกังวลเกี่ยวกับเทคโนโลยีดังกล่าวและดำเนินการบางอย่างเกี่ยวกับเรื่องนี้ นายฮารารีกล่าว

“หากไม่มีความร่วมมือระดับโลก การจะควบคุมศักยภาพอันตรายที่สุดของ AI จะเป็นเรื่องยากยิ่งหรือแทบจะเป็นไปไม่ได้เลย” เขากล่าว

การประชุมสุดยอดครั้งนี้สิ้นสุดลงด้วยข้อตกลงระหว่างรัฐบาล 10 แห่งและบริษัท AI รายใหญ่ รวมถึงผู้พัฒนา ChatGPT อย่าง OpenAI และ Google เพื่อร่วมมือกันทดสอบโมเดล AI ขั้นสูงก่อนและหลังจากที่เปิดตัว

ผู้เขียน Sapiens โต้แย้งว่าปัญหาประการหนึ่งในการทดสอบความปลอดภัยของแบบจำลองคือการต้องคาดการณ์ปัญหาต่างๆ ที่อาจเกิดขึ้น

AI แตกต่างจากเทคโนโลยีทุกอย่างในอดีตที่ผ่านมาในประวัติศาสตร์มนุษยชาติ เนื่องจากเป็นเทคโนโลยีแรกที่สามารถตัดสินใจ สร้างแนวคิดใหม่ๆ และเรียนรู้และพัฒนาได้ด้วยตัวเอง

เมื่อพิจารณาตามนิยามแล้ว เป็นเรื่องยากยิ่งสำหรับมนุษย์ – แม้แต่ “บิดา” ของ AI – ที่จะคาดการณ์อันตรายและปัญหาที่อาจเกิดขึ้นทั้งหมด

รัฐบาลได้หยิบยกภัยคุกคามจากระบบ AI ที่ช่วยสร้างอาวุธชีวภาพ แต่ยังมีสถานการณ์อื่นๆ ที่สามารถพิจารณาได้

นายฮารารีชี้ให้เห็นว่าการเงินเป็นสาขาที่เหมาะสมกับระบบ AI เนื่องจากข้อมูลและ AI เพียงอย่างเดียวสามารถสร้างวิกฤตการณ์ร้ายแรงได้

“จะเกิดอะไรขึ้นถ้า AI ไม่เพียงแต่ได้รับอำนาจควบคุมระบบการเงินของ โลก มากขึ้นเท่านั้น แต่ยังเริ่มสร้างอุปกรณ์ทางการเงินใหม่ๆ ที่เฉพาะ AI เท่านั้นที่เข้าใจได้ แต่มนุษย์ไม่เข้าใจ” ฮารารีถาม

วิกฤตการณ์ทางการเงินในปี 2550-2551 เกิดจากตราสารหนี้ เช่น ตราสารหนี้ที่มีหลักประกัน (CDO) ซึ่งนักประวัติศาสตร์กล่าวเสริมว่า ยังไม่ค่อยมีใครเข้าใจและไม่ได้ควบคุมอย่างเพียงพอ

“AI มีศักยภาพในการสร้างอุปกรณ์ทางการเงินที่ซับซ้อนยิ่งกว่า CDO ลองนึกภาพสถานการณ์ที่เรามีระบบการเงินที่มนุษย์ไม่สามารถเข้าใจและควบคุมไม่ได้” เขากล่าว “แล้ววิกฤตการณ์ทางการเงินก็เกิดขึ้นโดยที่ไม่มีใครเข้าใจสิ่งที่เกิดขึ้น”

เมื่อเดือนที่แล้ว รัฐบาลอังกฤษได้แสดงความกังวลเกี่ยวกับโมเดล AI ขั้นสูงที่อาจก่อให้เกิดภัยคุกคามต่อการดำรงอยู่โดยการควบคุมและจัดการระบบการเงิน

แต่คุณฮารารีเชื่อว่าวิกฤตการณ์ทางการเงินที่เกิดจาก AI จะไม่ทำลายอารยธรรมของมนุษย์ "อย่างน้อยก็ไม่ใช่โดยตรง"

“มันอาจก่อให้เกิดสงครามหรือความขัดแย้งทางอ้อมได้ หากมันก่อให้เกิดสงครามหรือความขัดแย้งใดๆ ก็ตาม มันเป็นความเสี่ยงหายนะ ทั้งทางเศรษฐกิจ สังคม และ การเมือง ” เขากล่าวเสริม

ผู้เขียนชาวอิสราเอลซึ่งสนับสนุนการเรียกร้องให้หยุดการพัฒนา AI ขั้นสูงเป็นเวลา 6 เดือน และให้บริษัท AI รับผิดชอบต่อความเสียหายที่ผลิตภัณฑ์ของพวกเขาก่อขึ้น กล่าวว่าจุดเน้นไม่ควรอยู่ที่กฎระเบียบและกฎหมายเฉพาะ แต่ควรอยู่ที่องค์กรกำกับดูแลที่เชี่ยวชาญด้านเทคโนโลยี ซึ่งสามารถตอบสนองได้อย่างรวดเร็วเมื่อมีความก้าวหน้าใหม่ๆ เกิดขึ้น

“เราจำเป็นต้องสร้างสถาบันกำกับดูแลที่เข้มแข็งโดยเร็วที่สุดเท่าที่จะเป็นไปได้ ซึ่งมีความสามารถในการระบุและตอบสนองต่ออันตรายเมื่อเกิดขึ้น โดยยึดหลักความเข้าใจว่าเราไม่สามารถคาดการณ์อันตรายและปัญหาทั้งหมดล่วงหน้าได้”

“นี่ควรเป็นความพยายามหลัก ไม่ใช่การเขียนกฎระเบียบที่ยาวและซับซ้อนมากเกินไป ซึ่งเมื่อถึงเวลาที่ผ่านรัฐสภาก็อาจล้าสมัยไปแล้ว” เขากล่าว

นายฮารารีกล่าวว่าสถาบันวิจัยความปลอดภัยของ AI ควรจ้างผู้เชี่ยวชาญที่เข้าใจถึงผลกระทบที่อาจเกิดขึ้นของ AI ต่อโลกการเงิน

เดือนที่แล้ว ริชี ซูนัค รัฐมนตรีว่าการกระทรวงการคลังอังกฤษ ประกาศจัดตั้งสถาบันความปลอดภัยด้าน AI ของสหราชอาณาจักร ไม่กี่วันต่อมา ทำเนียบขาวได้ประกาศแผนการจัดตั้งสถาบันที่คล้ายคลึงกัน คาดว่าทั้งสองสถาบันจะมีบทบาทสำคัญในการทดสอบโมเดล AI ขั้นสูง

นายซูนัคกล่าวที่การประชุมสุดยอดว่าอังกฤษจำเป็นต้องเข้าใจความสามารถของโมเดล AI ขั้นสูงก่อนที่จะออกกฎหมายเพื่อจัดการกับโมเดลดังกล่าว

(ตามรายงานของ The Guardian)

แอปพลิเคชัน AI GraphCast พยากรณ์อากาศ 10 วันที่แม่นยำที่สุดในโลก

ห้องปฏิบัติการ DeepMind ของ Google ในสหราชอาณาจักรได้พัฒนาระบบ GraphCast ซึ่งเป็นแอปพลิเคชันปัญญาประดิษฐ์ (AI) ที่สามารถพยากรณ์อากาศ 10 วันได้แม่นยำที่สุดในโลก

พลังรวมของ AI และการประมวลผลแบบคลาวด์

การผสมผสานระหว่างปัญญาประดิษฐ์ (AI) และระบบคลาวด์คอมพิวติ้งเป็นแนวโน้มที่ไม่อาจหยุดยั้งได้ซึ่งกำลังเปลี่ยนแปลงอุตสาหกรรมทั่วโลก

แหล่งที่มา

![[ภาพ] เลขาธิการโต ลัม ให้การต้อนรับคณะผู้แทนเข้าร่วมการประชุมนานาชาติว่าด้วยเวียดนามศึกษา](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761456527874_a1-bnd-5260-7947-jpg.webp)

![[ภาพ] หนังสือพิมพ์หนานตันจัดแสดงและขอความคิดเห็นเกี่ยวกับร่างเอกสารการประชุมสมัชชาใหญ่พรรคครั้งที่ 14](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761470328996_ndo_br_bao-long-171-8916-jpg.webp)

![[ภาพถ่าย] เพลิดเพลินกับเทศกาลดอกไม้ไฟ Liuyang ในหูหนาน ประเทศจีน](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761463428882_ndo_br_02-1-my-1-jpg.webp)

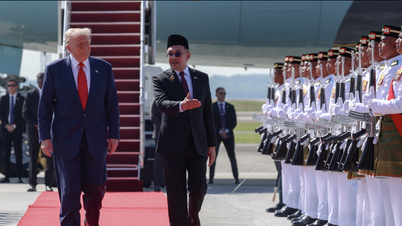

![[ภาพ] นายกรัฐมนตรี ฝ่าม มินห์ จิ่ง เข้าร่วมพิธีเปิดการประชุมสุดยอดอาเซียนครั้งที่ 47](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761452925332_c2a-jpg.webp)

การแสดงความคิดเห็น (0)