Атака з усіх боків.

Google запустив новий продукт штучного інтелекту (ШІ) під назвою «Gemini Nano Banana», який не є масштабним лінгвістичним ШІ (LLM), здатним писати та міркувати, а радше ШІ, що спеціалізується на редагуванні фотографій... Багато користувачів захоплені цим інструментом, але він також має низку недоліків.

«Це як «крок назад» у технології штучного інтелекту та етичних обмеженнях», – сказав Нгуєн Хонг Фук, головний науковий директор Conductify AI, висловлюючи свою особисту думку. «Gemini Nano Banana має ефективні можливості редагування зображень. Але те, що Google усунула цензуру в Gemini Nano Banana, послаблюючи бар’єри та обмежувальні механізми, дозволяє цьому штучному інтелекту створювати зображення, неймовірно схожі на знаменитостей, зображення з провокаційним характером, чутливі зображення тощо», – сказав Фук.

За словами пана Нгуєна Хонг Фука, ця можливість робить Gemini Nano Banana інструментом для створення реалістичних підроблених зображень, аж до того, що навіть експерти зі штучного інтелекту не можуть їх розрізнити, що призводить до нових ризиків шахрайства та кібербезпеки, таких як створення підроблених фотографій із відомими політиками для поширення неправдивої інформації, і навіть маніпуляції фотографіями та наклепи на окремих осіб у соціальних мережах, створених штучним інтелектом...

Крім того, оскільки десятки інших інструментів для редагування фотографій на основі штучного інтелекту захоплюють інтернет, шахрайство з використанням діпфейків не припиняється. Статистика організацій безпеки показує, що технологія діпфейків створює фішингові кампанії, спрямовані на високоцінних осіб, особливо на бізнес-лідерів. У 2024 році у світі було зареєстровано 140 000-150 000 випадків, причому 75% були спрямовані на генеральних директорів та керівників вищої ланки... Діпфейки можуть збільшити глобальні економічні втрати на 32%, приблизно на 40 мільярдів доларів на рік до 2027 року.

Нещодавно компанія Anthropic, що займається штучним інтелектом, виявила та запобігла кібератак, здійсненому іноземними хакерами, в результаті чого вперше зафіксовано використання штучного інтелекту для координації автоматизованих атак. Зокрема, хакери використовували системи штучного інтелекту для планування, керівництва та розгортання операцій зі вторгнення – «тривожний» розвиток подій, який ризикує розширити масштаби та швидкість кампаній кібератак…

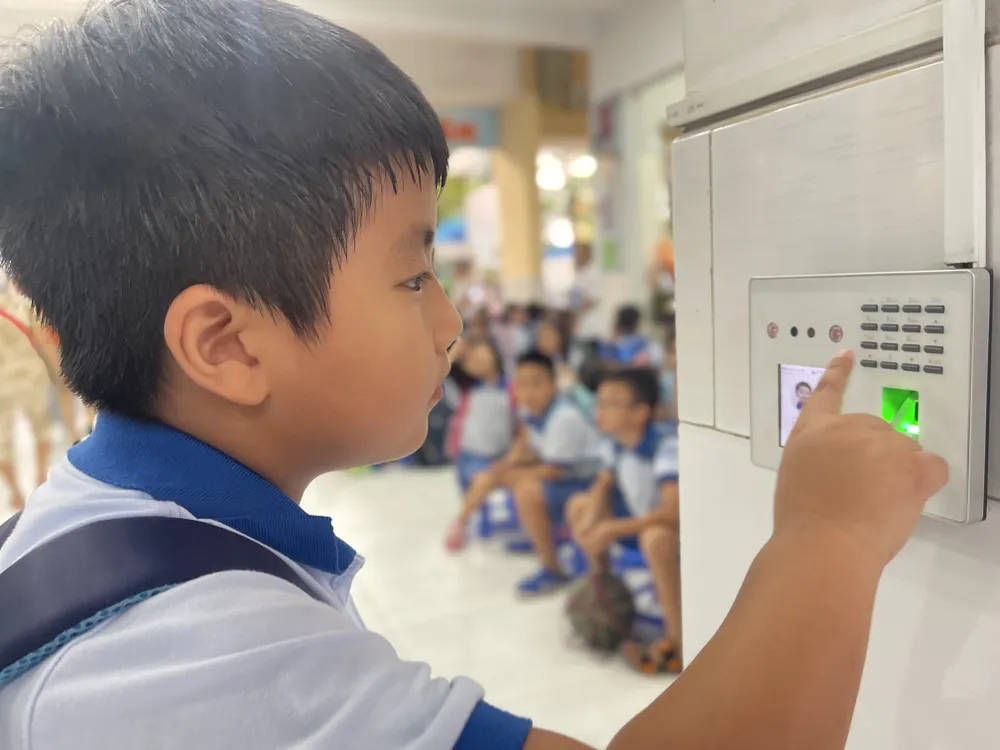

Пан Нго Мінь Х'єу, директор Організації боротьби з шахрайством Національної асоціації кібербезпеки, поділився тим, що інструменти, інтегровані зі штучним інтелектом, збільшують швидкість шахрайства приблизно у 20 разів порівняно з використанням реальних людей. Шахраї надають штучному інтелекту сценарій шахрайства для аналізу, і система негайно автоматично спілкується з жертвами. За початковими даними штучний інтелект може зрозуміти, чого хоче жертва, та спілкуватися з нею в режимі реального часу. Найскладнішою тактикою є атака «Людина посередині», коли користувач виконує відеоаутентифікацію (наприклад, записує своє обличчя або дає команди), хакер втручається, щоб перешкодити переданим даним. Потім кіберзлочинці вставляють заздалегідь підготовлені відео з дипфейками, замінюючи реальний потік даних користувача, щоб обійти процес автентифікації. За допомогою цього методу системи безпеки банків та фінансових установ також ризикують бути обманутими.

Краще управління даними

Зі зростанням поширеності штучного інтелекту, ризики для безпеки та конфіденційності також значно зростають. Дані, що зберігаються та обробляються на віддалених серверах, стануть привабливою мішенню для хакерів та кіберзлочинців. Згідно з даними Національної асоціації кібербезпеки, лише у другому кварталі 2025 року кількість кібератак за допомогою штучного інтелекту зросла на 62%, що спричинило глобальні втрати до 18 мільярдів доларів...

Експерти вважають захист даних надзвичайно важливим. Однак збір та продаж даних відкрито продовжуються на багатьох платформах «чорного ринку» всього за 20 доларів на місяць. Кіберзлочинці можуть використовувати інструменти, що імітують мовні моделі, але налаштовані для злочинних цілей. Ці інструменти здатні генерувати шкідливе програмне забезпечення та навіть обходити антивірусне програмне забезпечення.

У В'єтнамі Декрет № 13/2023/ND-CP (набрав чинності з 17 квітня 2023 року) регулює захист персональних даних. Крім того, Закон про захист персональних даних, який, як очікується, набуде чинності 1 січня 2026 року, відкриє сильніший правовий механізм для боротьби з ризиком витоку та неправомірного використання персональних даних. Однак, за даними Національної асоціації кібербезпеки, ефективність правозастосування все ще потребує посилення за трьома напрямками: підвищення обізнаності громадськості, підвищення корпоративної відповідальності та покращення можливостей обробки даних регуляторних органів. Окрім технічних заходів, кожна людина повинна розвинути здатність виявляти незвичайні та підозрілі ознаки та проактивно захищати себе від небезпечних цифрових взаємодій…

«Лабораторія Касперського» попередила про експлуатацію темного штучного інтелекту (термін, що стосується розгортання моделей великих мов програмування (LLM), які працюють поза стандартними засобами контролю безпеки, часто уможливлюючи такі дії, як фішинг, маніпуляції, кібератаки або зловживання даними). Організаціям та окремим особам необхідно бути готовими до зіткнення зі все більш складними та важковиявлюваними кібератаками через зростання популярності темного штучного інтелекту в Азіатсько-Тихоокеанському регіоні.

Сергій Ложкін, керівник Глобальної дослідницької та аналітичної групи (GReAT) для регіонів Близького Сходу, Туреччини, Африки та Азіатсько-Тихоокеанського регіону в Kaspersky, поділився тим, що одним із проявів поточного зловживання ШІ є поява моделей Black Hat GPT. Це моделі ШІ, спеціально розроблені або модифіковані для неетичних та незаконних цілей, таких як створення шкідливого програмного забезпечення, створення плавних та переконливих фішингових електронних листів для масштабних атак, створення дипфейкових голосів та відео та навіть підтримка симульованих атак.

Експерти Kaspersky рекомендують окремим особам та підприємствам використовувати рішення безпеки наступного покоління для виявлення шкідливого програмного забезпечення, створеного штучним інтелектом, а також надавати пріоритет захисту даних. Підприємствам слід впроваджувати інструменти моніторингу в режимі реального часу для відстеження експлуатації вразливостей, спричинених штучним інтелектом; посилювати контроль доступу та навчання співробітників, щоб обмежити використання штучного інтелекту в темній зоні та ризик витоку даних; а також створювати центр кібербезпеки для моніторингу загроз та швидкого реагування на інциденти.

Джерело: https://www.sggp.org.vn/bao-mat-du-lieu-thoi-ai-post824210.html

Коментар (0)