Дослідники з DeepSeek анонсували нову експериментальну модель під назвою V3.2-exp, розроблену для значного зниження вартості логічного висновку під час використання в операціях з довгим контекстом.

DeepSeek анонсував модель у дописі на Hugging Face, а також опублікував посилання на академічну статтю на GitHub.

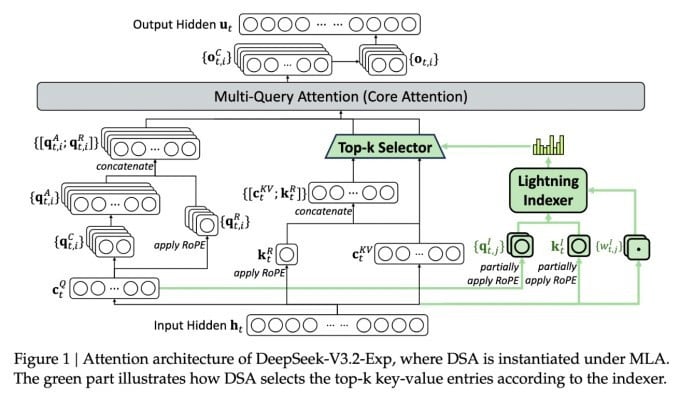

Найважливішою особливістю нової складної моделі є DeepSeek Sparse Attention. По суті, система використовує модуль під назвою «індексатор блискавки» для визначення пріоритетів певних уривків з контекстного вікна.

DeepSeek анонсує економічно ефективну модель логічного висновку.

Окрема система під назвою «система тонкозернистого вибору токенів» потім вибирає певні токени з цих фрагментів для завантаження у вікно обмеженої уваги модуля. Разом вони дозволяють моделям розрідженої уваги працювати з довгими фрагментами контексту з відносно невеликим навантаженням на сервер.

Для операцій з довгим контекстом переваги системи є значними. Попереднє тестування DeepSeek показує, що вартість простого виклику функції виводу (API) може бути зменшена до половини в сценаріях з довгим контекстом.

Для створення більш надійної оцінки необхідні подальші тестування, але оскільки модель є відкритою та вільно доступною на Hugging Face, незабаром сторонні тести зможуть оцінити твердження, викладені в статті.

На відміну від інших моделей чат-ботів зі штучним інтелектом, які споживають багато енергії, DeepSeek йде шляхом економії витрат, починаючи від навчання і закінчуючи експлуатацією.

Нова модель DeepSeek є однією з серії нещодавніх проривів, що вирішують проблему вартості логічного висновку — по суті, вартості сервера для запуску попередньо навченої моделі штучного інтелекту, на відміну від вартості її навчання.

У випадку DeepSeek дослідники шукали способи зробити базову архітектуру трансформатора ефективнішою — і виявили, що необхідно внести значні покращення.

Китайська компанія DeepSeek є незвичною фігурою в ажіотажі штучного інтелекту, особливо для тих, хто розглядає дослідження в галузі штучного інтелекту як конкуренцію між США та Китаєм. Компанія справила фурор на початку цього року зі своєю моделлю R1, яка навчається переважно за допомогою навчання з підкріпленням за значно нижчою ціною, ніж її конкуренти зі США.

Однак, модель не змогла спровокувати повномасштабну революцію в навчанні ШІ, яку деякі передбачали, і компанія поступово відійшла від уваги в наступні місяці.

Новий підхід «розрідженої уваги» навряд чи викличе стільки ж обурення, як R1, але він все ж може навчити американських постачальників послуг деяким необхідним хитрощам, які допоможуть знизити витрати на логічний висновок.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Джерело: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Фото] Відвідайте Хунг Єн, щоб помилуватися пагодою «дерев'яного шедевра» в самому серці Північної дельти](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F21%2F1763716446000_a1-bnd-8471-1769-jpg.webp&w=3840&q=75)

![[Фото] Генеральний секретар То Лам приймає Голову Сенату Чеської Республіки Мілоша Вистрчила](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F21%2F1763723946294_ndo_br_1-8401-jpg.webp&w=3840&q=75)

![[Фото] Голова Національних зборів Чан Тхань Ман провів переговори з Головою Сенату Чеської Республіки Мілошем Вистрчилом](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F21%2F1763715853195_ndo_br_bnd-6440-jpg.webp&w=3840&q=75)

![[Фото] Президент Луонг Куонг приймає спікера Національних зборів Кореї У Вон Шіка](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F21%2F1763720046458_ndo_br_1-jpg.webp&w=3840&q=75)

Коментар (0)