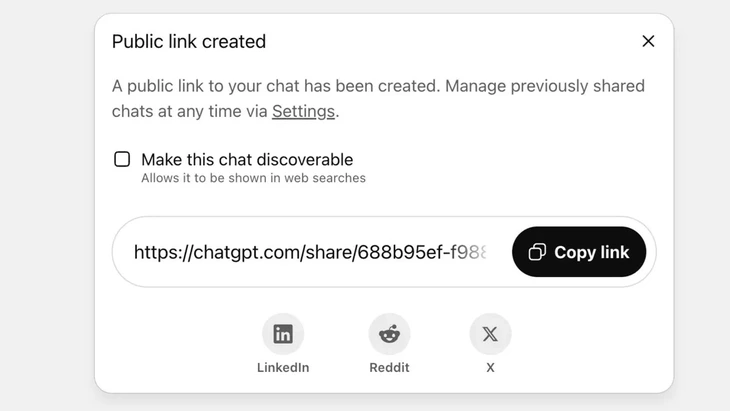

ميزة مشاركة الدردشات عبر رابط عام على ChatGPT - صورة: Techradar

يصل ChatGPT الآن إلى ما يزيد عن 2.5 مليار استعلام من المستخدمين العالميين كل يوم، مما يدل على الشعبية المتزايدة لهذا الروبوت المحادثة.

لكن هذه الأداة تواجه انتقادات شديدة من جانب المستخدمين، إذ تسببت ميزة "المشاركة" في تسريب معلومات حساسة من آلاف المحادثات إلى جوجل وبعض محركات البحث على الإنترنت.

مخاطر أمنية عالية

وصرح السيد فو نغوك سون - رئيس قسم التكنولوجيا في الجمعية الوطنية للأمن السيبراني (NCA) - بأن الحادث المذكور أعلاه يُظهر مستوى عالٍ من المخاطر الأمنية لمستخدمي ChatGPT.

حلل السيد فو نغوك سون قائلاً: "إن الحادثة المذكورة ليست بالضرورة عيبًا فنيًا، إذ إن هناك مبادرة من المستخدم بالنقر على زر المشاركة. ومع ذلك، يمكن القول إن المشكلة تكمن في تصميم منتج روبوت الدردشة الذكي، إذ تسبب في إرباك المستخدمين، ولم تكن هناك إجراءات تحذيرية كافية بشأن خطر تسريب البيانات الشخصية في حال مشاركة المستخدمين لها".

في ChatGPT، يتم تنفيذ هذه الميزة بعد أن يختار المستخدم مشاركة الدردشة عبر رابط عام، وسيتم تخزين المحتوى على خادم OpenAI كموقع ويب عام (chatgpt.com/share/...)، ولا يلزم تسجيل الدخول أو كلمة المرور للوصول.

تعمل أدوات الزحف الخاصة بـ Google تلقائيًا على مسح هذه الصفحات وفهرستها، مما يجعلها تظهر في نتائج البحث، بما في ذلك النصوص الحساسة أو الصور أو بيانات الدردشة.

لم يكن العديد من المستخدمين على دراية بالخطر، ظانّين أنهم يشاركون الدردشة مع أصدقائهم أو جهات اتصالهم. أدى ذلك إلى كشف آلاف المحادثات، التي احتوت في بعض الحالات على معلومات شخصية حساسة.

على الرغم من أن OpenAI أزالت هذه الميزة بسرعة في أواخر يوليو 2025 بعد ردود فعل سلبية من المجتمع، إلا أن الأمر استغرق بعض الوقت للتنسيق مع جوجل لإزالة الفهارس القديمة. وخصوصًا مع نظام التخزين المعقد، الذي يتضمن خوادم التخزين المؤقت من جوجل، لا يمكن إنجاز ذلك بسرعة.

لا تعامل روبوتات الدردشة التي تعمل بالذكاء الاصطناعي باعتبارها "صندوقًا أسودًا آمنًا"

خبير أمن البيانات فو نغوك سون - رئيس قسم التكنولوجيا في الرابطة الوطنية للأمن السيبراني (NCA) - الصورة: CHI HIEU

إن تسريب آلاف سجلات الدردشة قد يشكل مخاطر على المستخدمين مثل الكشف عن الأسرار الشخصية والتجارية؛ والإضرار بالسمعة، والمخاطر المالية أو حتى المخاطر الأمنية بسبب الكشف عن عناوين المنازل.

"تعد برامج المحادثة المدعومة بالذكاء الاصطناعي مفيدة ولكنها ليست "صندوقًا أسود"، حيث يمكن أن توجد البيانات المشتركة إلى الأبد على الويب إذا تركت دون مراقبة.

لا شك أن الحادثة المذكورة أعلاه تُعدّ درسًا لكلٍّ من مُقدّمي الخدمات والمستخدمين. ويمكن لمُقدّمي خدمات الذكاء الاصطناعي الآخرين التعلّم من هذه التجربة وتصميم ميزات بتحذيرات أوضح وأكثر شفافية.

وفي الوقت نفسه، يحتاج المستخدمون أيضًا إلى الحد بشكل استباقي من النشر غير المنضبط للمعلومات التعريفية أو الشخصية على منصات الذكاء الاصطناعي،" أوصى خبير الأمن فو نغوك سون.

وفقًا لخبراء أمن البيانات، تُظهر هذه الحادثة الحاجة إلى ممرات قانونية ومعايير أمن سيبراني للذكاء الاصطناعي. كما يتعين على موردي ومطوري الذكاء الاصطناعي تصميم أنظمة تضمن الأمان، وتتجنب مخاطر تسرب البيانات، مثل: التسرب من خلال ثغرات أمنية خطيرة؛ وثغرات البرامج التي تؤدي إلى هجمات على قواعد البيانات؛ وضعف الرقابة الذي يؤدي إلى التسريب وإساءة استخدام المعلومات للإجابة على أسئلة خاطئة ومشوهة.

يجب على المستخدمين أيضًا التحكم في مشاركة معلوماتهم الشخصية باستخدام الذكاء الاصطناعي، وتجنب مشاركة المعلومات الحساسة. في حال الحاجة الماسة، يُنصح باستخدام وضع عدم الكشف عن الهوية أو تشفير المعلومات بشكل نشط لتجنب ربط البيانات مباشرةً بأشخاص محددين.

المصدر: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[صورة] "مقبرة السفن" في خليج شوان داي](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[فيديو] إعادة فتح آثار هوي لاستقبال الزوار](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

تعليق (0)