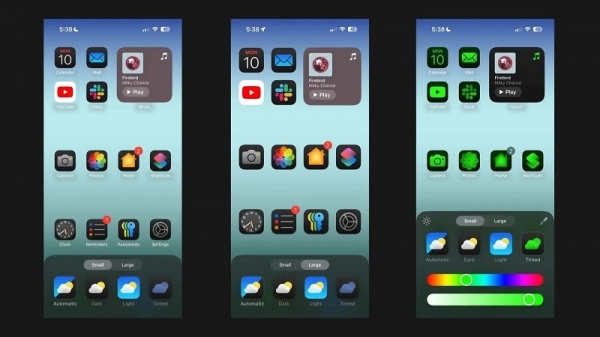

Podle Android Authority výzkumná práce společnosti Apple podrobně popisuje řešení pro spouštění velkých jazykových modelů (LLM) na zařízeních s omezenou pamětí RAM. Článek odhaluje, jak může společnost ukládat „parametry modelu“ a v případě potřeby načítat jejich část do paměti RAM zařízení, místo aby do paměti RAM načítala celý model.

Apple se snaží pomoci starším iPhonem s menší pamětí RAM spustit obecnou umělou inteligenci

Článek tvrdí, že tato metoda umožňuje spouštět modely, které vyžadují dvojnásobek RAM, než může mít iPhone, a zároveň zajišťuje 4-5x a 20-25x rychlost inference ve srovnání s jednoduchými metodami načítání na CPU a GPU.

Nasazení syntetické umělé inteligence na zařízení s větší pamětí RAM by bylo obrovským přínosem, protože by umožnilo rychlejší čtení/zápis. Rychlost je pro umělou inteligenci na zařízení důležitá, protože umožňuje mnohem rychlejší inferenci, protože uživatelé nemusí nutně čekat desítky sekund (nebo i déle) na odpověď nebo konečný výsledek. To vše znamená, že asistent umělé inteligence na zařízení by mohl potenciálně běžet konverzační rychlostí, generovat obrázky/text mnohem rychleji, rychleji shrnout články atd. Řešení od Applu však znamená, že uživatelé nemusí nutně potřebovat mnoho paměti RAM, aby urychlili odezvu umělé inteligence na úkoly na zařízení.

Přístup společnosti Apple by mohl starým i novým iPhonům umožnit nabízet syntetické funkce umělé inteligence přímo ve svých zařízeních. To je důležité, protože iPhony od Applu obvykle nabízejí méně RAM než špičkové telefony s Androidem. Například řada iPhone 11 nabízí pouze 4 GB RAM, zatímco i běžný iPhone 15 má jen 6 GB.

Apple není jedinou mobilní společností, která pracuje na zmenšení LLM. Nedávné vlajkové lodě od Qualcommu a MediaTeku podporují přesnost INT4, aby tyto modely zmenšily. Ať tak či onak, společnosti se snaží najít nové způsoby, jak snížit systémové požadavky pro umělou inteligenci v zařízení, což by umožnilo nabízet tuto funkci i telefonům nižší třídy.

Zdrojový odkaz

![[Fotografie] Třetí vlastenecký kongres Ústřední komise pro vnitřní záležitosti](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761831176178_dh-thi-dua-yeu-nuoc-5076-2710-jpg.webp)

![[Foto] Předseda Národního shromáždění Tran Thanh Man přijímá zahraniční velvyslance, kteří se přišli rozloučit](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761820977744_ndo_br_1-jpg.webp)

![[Foto] Dojemná scéna tisíců lidí, kteří zachraňují nábřeží před zuřící vodou](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825173837_ndo_br_ho-de-3-jpg.webp)

![[Fotografie] Generální tajemník To Lam se účastní vietnamsko-britské ekonomické konference na vysoké úrovni](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825773922_anh-1-3371-jpg.webp)

![[Fotografie] Generální tajemník To Lam se setkal s bývalým britským premiérem Tonym Blairem](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761821573624_tbt-tl1-jpg.webp)

Komentář (0)