Προϊόντα Τεχνητής Νοημοσύνης: Ρατσισμός και Προκατάληψη

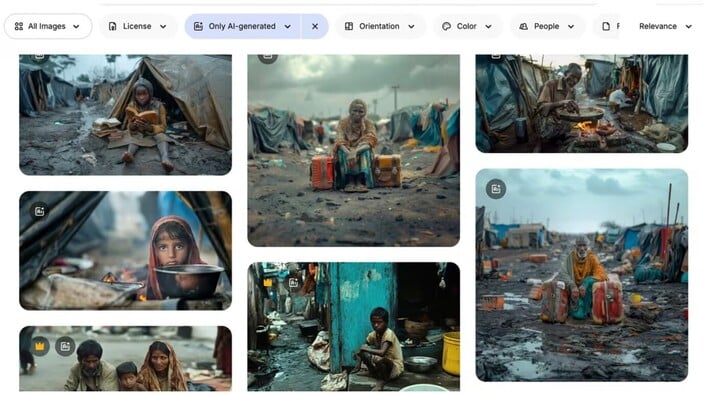

Εικόνες που δημιουργούνται από τεχνητή νοημοσύνη και απεικονίζουν θέματα όπως η φτώχεια, τα παιδιά και τα θύματα σεξουαλικής βίας κατακλύζουν τα διαδικτυακά φωτογραφικά αρχεία, με τις μη κυβερνητικές οργανώσεις (ΜΚΟ) να τις χρησιμοποιούν ολοένα και περισσότερο, σύμφωνα με παγκόσμιους ειδικούς υγείας . Οι ειδικοί προειδοποιούν ότι αυτό θα μπορούσε να σηματοδοτήσει μια «νέα εποχή στην κουλτούρα εκμετάλλευσης της φτώχειας».

«Αυτές οι εικόνες αντικατοπτρίζουν την τυπική άποψη για τη φτώχεια - παιδιά που κρατούν άδεια μπολ, ραγισμένο έδαφος... πολύ στερεοτυπικό», δήλωσε ο Arsenii Alenichev, ερευνητής στο Ινστιτούτο Τροπικής Ιατρικής στην Αμβέρσα, ο οποίος μελετά την παραγωγή εικόνων παγκόσμιας υγείας .

Ο κ. Αλενίτσεφ συνέλεξε περισσότερες από 100 εικόνες ακραίας φτώχειας, δημιουργημένες από τεχνητή νοημοσύνη, οι οποίες χρησιμοποιήθηκαν από άτομα ή ΜΚΟ σε εκστρατείες στα μέσα κοινωνικής δικτύωσης κατά της πείνας και της σεξουαλικής βίας.

Οι εικόνες που μοιράστηκε με την εφημερίδα Guardian δείχνουν υπερβολικές, στερεοτυπικές σκηνές: παιδιά κουλουριασμένα σε λακκούβες λάσπης· ένα Αφρικανό κορίτσι με νυφικό με δάκρυα να τρέχουν στο πρόσωπό της. Σε πρόσφατο σχόλιο που δημοσιεύτηκε στο περιοδικό Lancet Global Health, υποστήριξε ότι οι εικόνες ισοδυναμούσαν με «πορνό φτώχειας έκδοση 2.0».

Στιγμιότυπο οθόνης που δείχνει μια εικόνα «φτώχειας» που δημιουργήθηκε από τεχνητή νοημοσύνη σε έναν ιστότοπο φωτογραφιών. (Φωτογραφία: Freepik)

Ο κ. Αλενίτσεφ και πολλοί άλλοι ειδικοί λένε ότι η χρήση εικόνων τεχνητής νοημοσύνης αυξάνεται λόγω ανησυχιών σχετικά με τα πνευματικά δικαιώματα και το κόστος. Οι περικοπές στον προϋπολογισμό της κυβέρνησης των ΗΠΑ προς τις ΜΚΟ έχουν επιδεινώσει το πρόβλημα.

«Προφανώς, πολλοί οργανισμοί αρχίζουν να εξετάζουν τη χρήση εικόνων τεχνητής νοημοσύνης αντί για πραγματικές φωτογραφίες, επειδή είναι φθηνό. Επίσης, δεν χρειάζεται να ανησυχείτε για τα πνευματικά δικαιώματα και πολλά άλλα πράγματα», είπε.

Η ευθύνη βαρύνει τον χρήστη ή την πλατφόρμα;

Εικόνες φτώχειας που δημιουργούνται από τεχνητή νοημοσύνη εμφανίζονται σε δεκάδες ιστότοπους φωτογραφιών, συμπεριλαμβανομένων των Adobe Stock Photos και Freepik. Πολλές έχουν λεζάντες: «σουρεαλιστικό παιδί σε καταυλισμό προσφύγων». «Ασιατικά παιδιά κολυμπούν σε ένα ποτάμι γεμάτο σκουπίδια». «λευκός εθελοντής παρέχει ιατρικές συμβουλές σε μαύρα παιδιά σε ένα αφρικανικό χωριό» και άλλα. Η Adobe πωλεί τα δικαιώματα για τις δύο τελευταίες εικόνες σε αυτήν τη λίστα για περίπου 60 λίρες.

«Αυτές οι φωτογραφίες είναι κατάφωρα ρατσιστικές και δεν θα έπρεπε να επιτρέπεται η δημοσίευσή τους, επειδή αποτελούν τα χειρότερα στερεότυπα για την Αφρική, την Ινδία ή οτιδήποτε μπορείτε να φανταστείτε», δήλωσε ο Αλενίτσεφ.

Ο Joaquín Abela, Διευθύνων Σύμβουλος της Freepik, δήλωσε ότι η ευθύνη για τη χρήση τέτοιων ακραίων εικόνων βαρύνει τους χρήστες, όχι πλατφόρμες όπως η δική του. Κατά την άποψή του, οι φωτογραφίες αρχείου τεχνητής νοημοσύνης δημιουργούνται από μια παγκόσμια κοινότητα χρηστών, οι οποίοι μπορούν να λαμβάνουν δικαιώματα όταν οι πελάτες της Freepik επιλέγουν να αγοράσουν τις φωτογραφίες τους.

Το Freepik προσπάθησε να περιορίσει τις προκαταλήψεις που εντοπίζονται στις φωτογραφικές του συλλογές «ενισχύοντας την ποικιλομορφία». Ταυτόχρονα, προσπαθεί επίσης να διασφαλίσει την ισορροπία των φύλων στις φωτογραφίες δικηγόρων και στελεχών.

Αλλά, λέει, η πλατφόρμα του μπορεί να κάνει μόνο ένα συγκεκριμένο βήμα. «Είναι σαν να προσπαθείς να στεγνώσεις τον ωκεανό. Το έχουμε προσπαθήσει, αλλά η πραγματικότητα είναι ότι, αν οι πελάτες σε όλο τον κόσμο θέλουν οι εικόνες τους να φαίνονται με έναν συγκεκριμένο τρόπο, δεν υπάρχει απολύτως τίποτα που μπορεί να κάνει κανείς γι' αυτό».

Εικόνα που δημιουργήθηκε από τεχνητή νοημοσύνη από την εκστρατεία κατά του παιδικού γάμου του φιλανθρωπικού οργανισμού Plan International για το 2023, η οποία στοχεύει στην προστασία της «ιδιωτικότητας και της αξιοπρέπειας των κοριτσιών». (Φωτογραφία: Plan International)

Πολλοί αναγνωρισμένοι οργανισμοί έχουν χρησιμοποιήσει εικόνες που δημιουργούνται από τεχνητή νοημοσύνη, ακόμη και τα Ηνωμένα Έθνη.

Πέρυσι, τα Ηνωμένα Έθνη δημοσίευσαν ένα βίντεο στο YouTube με «αναπαραστάσεις» σεξουαλικής βίας, συμπεριλαμβανομένης της μαρτυρίας μιας γυναίκας από το Μπουρούντι που περιγράφει τον βιασμό της και την εγκατέλειψαν νεκρή από τρεις άνδρες το 1993. Το περιεχόμενο δημιουργήθηκε εξ ολοκλήρου από τεχνητή νοημοσύνη. Το βίντεο αφαιρέθηκε αφού η Guardian επικοινώνησε με τον ΟΗΕ για μια συνέντευξη.

Ένας εκπρόσωπος του ΟΗΕ εξήγησε αργότερα γιατί το βίντεο αφαιρέθηκε. «Πιστεύουμε ότι το βίντεο δημιουργήθηκε ακατάλληλα από την Τεχνητή Νοημοσύνη και ενδέχεται να θέσει σε κίνδυνο την ακεραιότητα των πληροφοριών, αναμειγνύοντας πραγματικό υλικό με τεχνητό περιεχόμενο που φαίνεται να είναι πραγματικό».

Τα προϊόντα που παράγονται από την τεχνητή νοημοσύνη έχουν από καιρό αποδειχθεί αντιγραφές, μερικές φορές υπερβάλλοντας την αλήθεια. Ο κ. Αλενίτσεφ είπε ότι ο πολλαπλασιασμός αυτών των προκατειλημμένων εικόνων θα μπορούσε να επιδεινώσει το πρόβλημα, επειδή οι εικόνες μπορούν να διαδοθούν στο αχανές διαδίκτυο και να χρησιμοποιηθούν για την εκπαίδευση της επόμενης γενιάς τεχνητής νοημοσύνης.

Ένας εκπρόσωπος της Plan International δήλωσε ότι η ΜΚΟ «συνιστά επί του παρόντος να μην χρησιμοποιείται τεχνητή νοημοσύνη για την απεικόνιση παιδιών».

Μιν Χόαν

Πηγή: https://vtcnews.vn/chuyen-gia-bao-dong-tinh-trang-ai-tao-anh-rap-khuon-phong-dai-ar972160.html

Σχόλιο (0)